「液体冷却サービスの開始」だけではない取り組み、ベストなアーキテクチャの構築

“プライベートAI/マルチAI時代”に必要なデータセンター戦略、エクイニクスが説明

2024年08月26日 07時00分更新

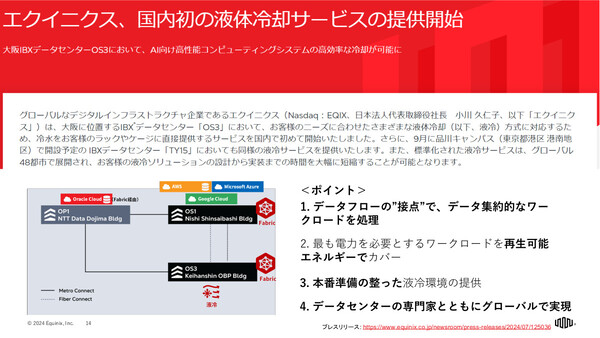

データセンター(DC)事業者のエクイニクスが2024年7月、大阪市にある「OS3」DCにおいて、同社では国内初となる液体冷却(液冷)サービスの提供を開始した。その背景にあるのは、AIなどの高負荷な(=発熱量の大きい)ワークロードを自社保有のITインフラで実行したいという顧客企業ニーズの高まりだ。今後、東京の「TY15」DCでも提供を予定している。

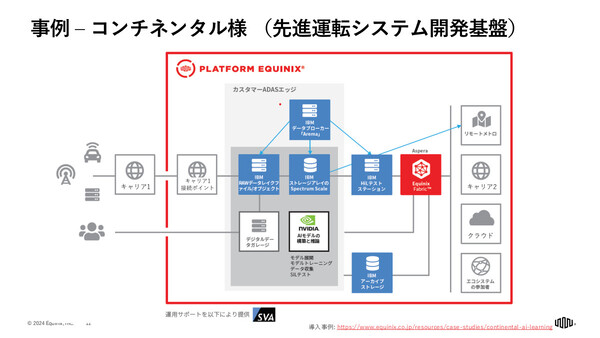

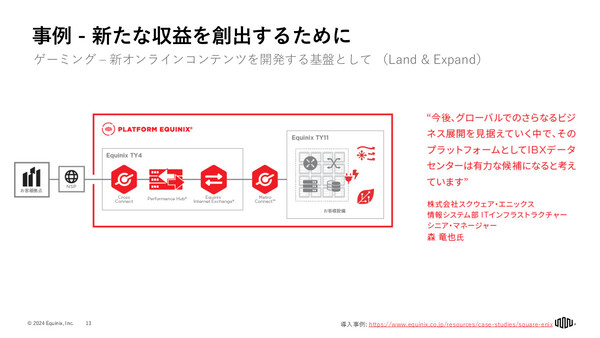

エクイニクスが2024年8月23日に行ったメディアとの意見交換会では、企業が独自のAIモデルを構築/利用する“プライベートAI”時代や、その先の“マルチAI”時代に考えられるITアーキテクチャの変化、同社DCにおける取り組み、ベストプラクティスとなる顧客事例などを紹介した。

ニーズが高まる「プライベートAI」に適したデータセンターの姿

世界33カ国/71都市で260以上のDCを展開するエクイニクスは、“グローバルなデジタルインフラストラクチャ企業”を標榜している。これは、単にDCスペースを提供するだけでなく、同社DCを利用する1万社以上の企業(クラウドサービス事業者、ネットワーク事業者、エンタープライズ企業など)どうしをシームレスに相互接続可能にすることで“包括的なデジタルエコシステム”を提供する、という意味だ。

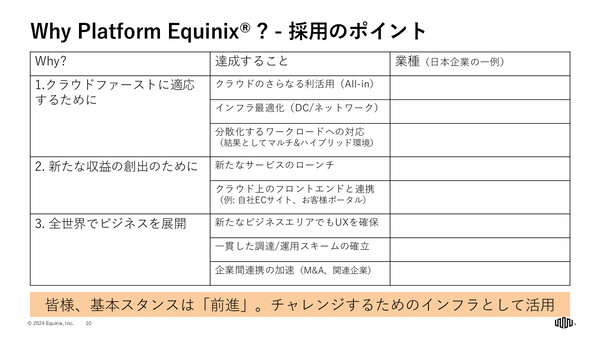

エクイニクス・ジャパンの内田武志氏は、「こうした顧客企業間の相互接続数は現在、46万2000以上に及ぶ」と述べ、この点がエクイニクスの競合差別化ポイントになっていると説明する。このエコシステムを提供するグローバルなデジタルプラットフォームが「Platform Equinix」であり、「単なる『DCコストの削減』ではなく、『デジタルを用いた新たなチャレンジのためのインフラ』を目的に利用いただいている」という。

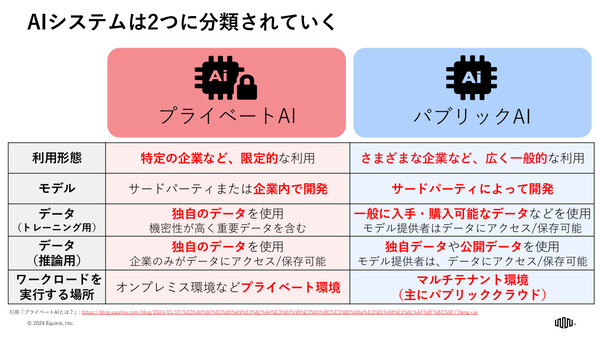

さて、今後のDC需要に変化をもたらすと考えられるのが、冒頭で触れた「プライベートAI」という新たな潮流だ。内田氏は、これからのAIシステムは「パブリックAI」と「プライベートAI」の2つに分かれていくだろうと語る。ユーザー企業が独自のデータを用いてトレーニングや推論を行うプライベートAIは、データの機密性などの観点から、オンプレミス、プライベートクラウドといった顧客企業の専有環境で実行されることになる。

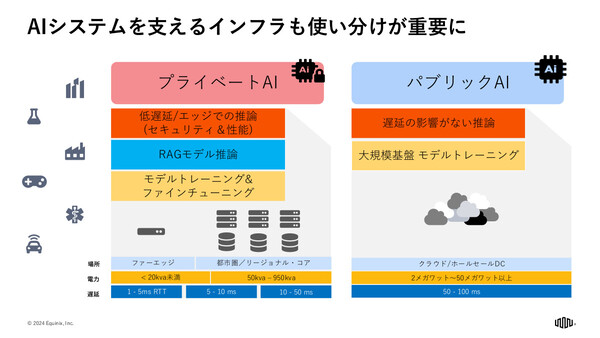

したがって、DCにもプライベートAIへの対応が求められるようになる。内田氏は、適したDCの種類という観点でも、プライベートAI/パブリックAIには違いがあることを説明する。

クラウド事業者のサービスとして提供されることが多いパブリックAIの場合は、消費電力の大きい基盤モデルのトレーニング処理も必要となるため、郊外型の大規模DC(クラウドDC)が適している。一方でプライベートAIの場合は、そこまでの電力規模は必要とせず、むしろ推論やRAGの低遅延性などを目的として、都市中心部に近いDCが適していることになる。

直接液冷(DLC)をフルマネージドサービスとして提供開始

AIのトレーニングや大規模な推論を行うDCに求められるのが、これまでよりも大きな電力供給能力と冷却能力だ。

冷却能力について言えば、高密度化が進む近年のGPUサーバー(「NVIDIA DGX」など)においては、サーバー内部まで冷却液を引き込みCPUやGPUのチップを直接冷却する高効率な冷却方式、DLC(Direct Liquid Cooling、直接液冷)へのニーズが高まっている。そこでエクイニクスでは、冒頭で触れたとおりOS3データセンターにおいて、液冷サービスの提供を開始した。

内田氏は、この液冷サービスの差別化ポイントを説明した。単に液冷設備をデータセンターに配置したというだけにはとどまらないという。

「ひとつは、エクイニクスがクラウド接続で持つ優位性、ネットワークエコシステムをうまく生かした液冷ロケーションであること。OS3は、AWS/Azure/Google Cloudの接続ポイントがあるOS1、Oracle Cloudの接続ポイントがあるOP1と光ファイバ接続されている。また、液冷サーバーを導入できる環境、導入を支援するデータセンター専門家も含めて、エクイニクス側でグローバルに標準化された“フルマネージド”のかたちで提供できるため、お客様には“プラグアンドプレイ”のように利用いただける」

液冷サービスは順次ほかのDCにも拡大していくが、そこは顧客ニーズの広がりも見極めながら投資と拡大を進めていくとした。

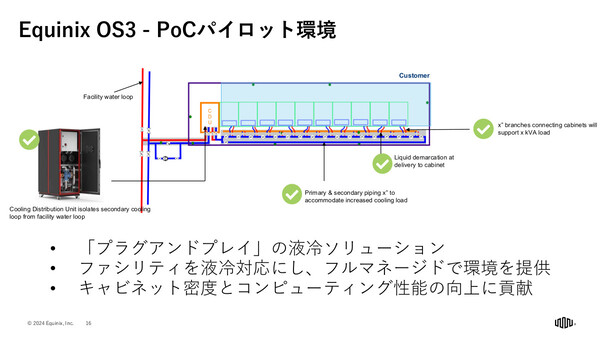

なお、OS3ではPoC向けのパイロット環境を用意している。ラック列の隣にCDU(Cooling Distribution Unit、冷却分配ユニット)を設置し、各ラックへの冷却水供給をコントロールしている。なお、現状ではサーバーメーカーごとに適切な冷却水の流量や温度が異なるケースもあるが、そうした差異もある程度はCDUで吸収できると説明した。

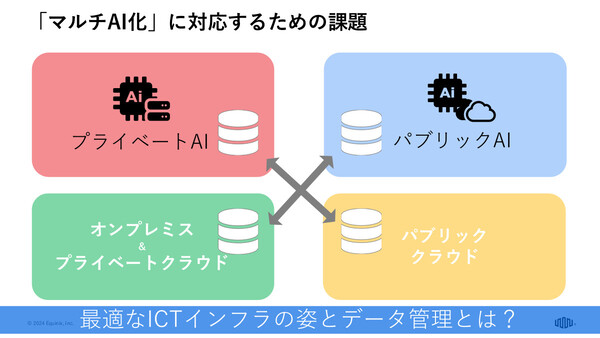

将来の「マルチAI」時代に適したアーキテクチャとは

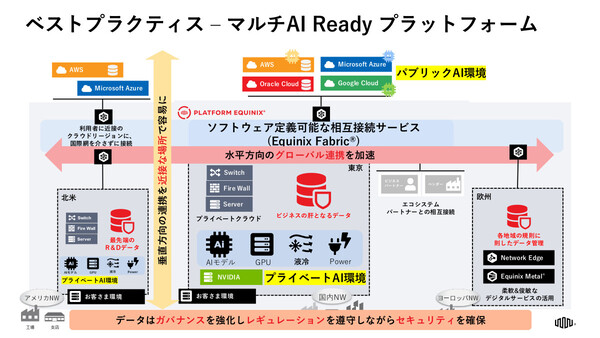

企業におけるAI活用は、前述したプライベートAIとパブリックAIを併用しながら進化していくことになる。当然ながらそこでは、プライベートAI環境(オンプレミス、プライベートクラウド)とパブリックAI環境(パブリッククラウド)、あるいはさまざまな国/地域で展開するプライベートAI環境どうしのデータ連携も重要になる。

内田氏は、こうしたAI環境の分散化を「マルチAI」化と表現し、データ連携やセキュリティ、ガバナンスなどを考慮したインフラアーキテクチャ、データ管理手法を考えておく必要があると指摘する。

そのうえで、エクイニクスとしてのベストプラクティスを紹介した。プライベートAI環境は、パブリッククラウドとの接続が容易な場所に設置すること、各国のデータ規制を順守しつつも相互連携できるようにすることといった具合で、このアーキテクチャの中心には柔軟なネットワークファブリックである「Equinix Fabric」が存在する。

まだ多くはないが、日本の顧客企業でもこうしたアーキテクチャの将来像を理解したうえで、プライベートAIの戦略をスタートさせている企業はあると、内田氏は説明した。

「まずは部分的にプライベートAIの取り組みをスタートさせて、ある程度運用が軌道に乗ってきたらクラウドと連携させる、また日本で成功したら海外拠点にも同じ環境を持って行く、そうした将来像を見据えているお客様は多い。中長期のTo Beモデル(あるべき姿)として、こうしたマルチAIアーキテクチャを否定されるお客様はいない」