Stable Diffusion入門 from Thailand 第20回

話題の画像生成AI「FLUX.1」をStable Diffusion用の「WebUI Forge」で動かす(高速化も試してみました)

2024年08月18日 17時00分更新

モデルによる比較

最後に、量子化処理がされていないベースモデルも含む以下の6モデルを使い、同じプロンプト、SEED値で作成された画像、そして生成時間を比較してみよう。

| バージョン | ファイル名 |

|---|---|

| Dev (オリジナル) | flux1-dev.safetensors |

| Dev FP8 | flux1-dev-fp8.safetensors |

| Dev NF4 v2 | flux1-dev-bnb-nf4-v2.safetensors |

| Schnell (オリジナル) | flux1-schnell.safetensors |

| Schnell FP8 | flux1-schnell-fp8.safetensors |

| Schnell NF4 | flux1-schnell-bnb-nf4.safetensors |

プロンプト:A photorealistic portrait of a young Japanese woman with long black hair and natural makeup, wearing a casual white blouse, sitting in a modern Tokyo cafe with soft window light

なおSEED値はすべて「2307193247」を使用している。

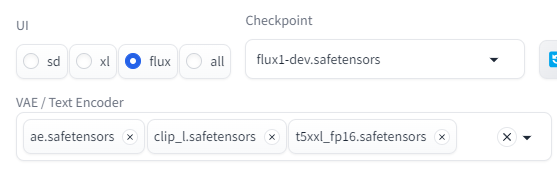

「Dev」系モデル

まずは「Dev」系のオリジナルモデル。FP16の「flux1-dev.safetensors」で試してみよう。なお、このモデルは量子化されたモデルと異なり、テキストエンコーダーやVAEが含まれていないので、「VAE/Text Encoder」に「ae.safetensors(VAE)」と「clip_l.safetensors」「t5xx_fp16.safetensors」の2つのテキストエンコーダーを明示的に指定する必要がある。

生成された画像の下には、プロンプトや各種パラメーターがすべて記載されている。描画時間は1分9秒。

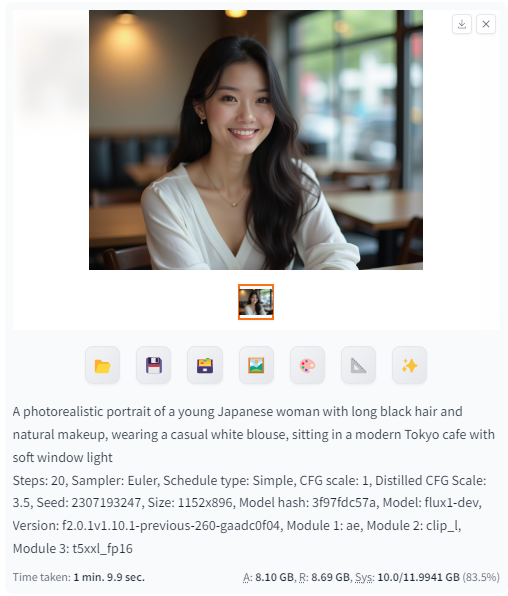

次に、「FP8」で量子化された「flux1-dev-fp8.safetensors」モデル。こちらはVAEやテキストエンコーダーが含まれているファイルだと思うが念のために指定しておいた。

描画時間はなぜかオリジナルモデルよりも長い1分30秒。設定を追い込めばもう少し早くはなるだろう。

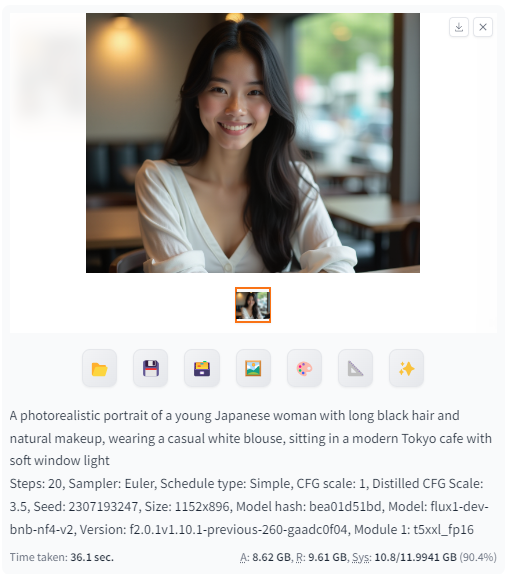

最後に、「NF4」で量子化されたモデル「flux1-dev-bnb-nf4-v2.safetensors」だ。こちらは「t5xx_fp16.safetensors」を指定している。

描画時間は36秒。画像もオリジナルと比べてそれほど劣化しているようには見えない。

「Schnell」系モデル

次に、軽量な「Schnell」系モデルを使ってみよう。まずはオリジナルモデルの「flux1-schnell.safetensors」を使用。こちらもVAEとテキストエンコーダーを明示的に指定する。

「Dev」では20にしていたSampling Stepsを、「Schnell」では「4」に変更するのを忘れずに。

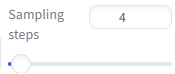

生成された画像。同じプロンプト、SEED値にも関わらず「Dev」とはかなり異なる画像が生成された。生成時間は17.5秒とさすがに早い。

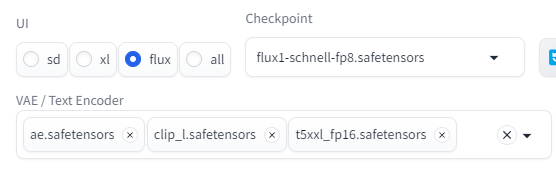

次に「FP8」で量子化された「flux1-schnell.safetensors」モデル。こちらもVAEとテキストエンコーダーを指定しているが、恐らく指定しなくとも描画は可能なはず。

描画時間は21.9秒と、こちらもオリジナルモデルより遅いという結果になってしまった。

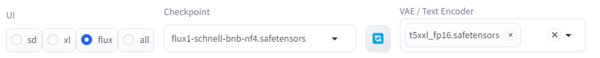

最後に「NF4」で量子化された最も軽量なモデル「flux1-schnell-bnb-nf4.safetensors」。

描画時間はなんと7.9秒。4ステップにも関わらず画像のクオリティーも悪くない。

この連載の記事

-

第40回

AI

Suno級がローカルで? 音楽生成AI「ACE-Step 1.5」を本気で検証 -

第39回

AI

欲しい映像素材が簡単に作れる! グーグル動画生成AI「Veo 3.1」の使い方 -

第38回

AI

最新の画像生成AIは“編集”がすごい! Nano Banana、Adobe、Canva、ローカルAIの違いを比べた -

第37回

AI

画像生成AIで比較!ChatGPT、Gemini、Grokどれを選ぶ?得意分野と使い分け【作例大量・2025年最新版】 -

第36回

AI

【無料で軽くて高品質】画像生成AI「Z-Image Turbo」が話題。SDXLとの違いは? -

第35回

AI

ここがヤバい!「Nano Banana Pro」画像編集AIのステージを引き上げた6つの進化点 -

第34回

AI

無料で始める画像生成AI 人気モデルとツールまとめ【2025年11月最新版】 -

第33回

AI

初心者でも簡単!「Sora 2」で“プロ級動画”を作るコツ -

第32回

AI

【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ -

第31回

AI

“残念じゃない美少女イラスト”ができた! お絵描きAIツール4選【アニメ絵にも対応】 -

第30回

AI

画像生成AI「Midjourney」動画生成のやり方は超簡単! - この連載の一覧へ