Stable Diffusion入門 from Thailand 第20回

話題の画像生成AI「FLUX.1」をStable Diffusion用の「WebUI Forge」で動かす(高速化も試してみました)

2024年08月18日 17時00分更新

さっそく生成してみよう

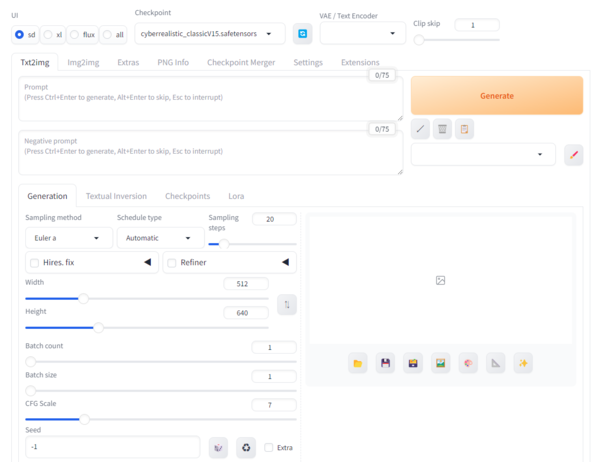

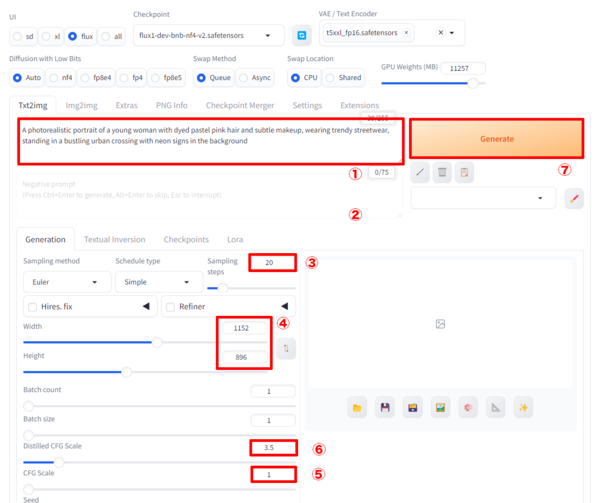

以下はStable Diffusion WebUI Forgeの起動画面だ。

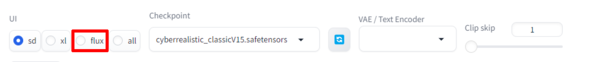

画面左上の「UI」セクションでは、利用するAIモデルを選択できるようになっている。今回はFLUX.1を使用するので「flux」をクリックしてみよう。

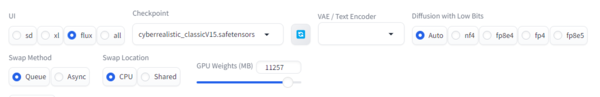

すると、画面上部の要素がFLUX.1専用のものに変更される。

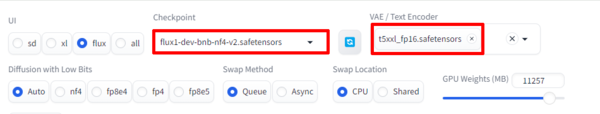

ここでは「Checkpoint」欄に「flux1-dev-bnb-nf4-v2.safetensors」、「VAE/Text Encoder」欄に「t5xxl_fp16.safetensors」を選択しよう。

次に各種設定を確認していこう。AUTOMATIC1111版WebUIやForgeを利用したことがある人ならスムーズに理解できるだろう。

①「Prompt」:描いてほしい画像の説明を英語で記入する。推奨は75トークン以下となっている。

②「Negative Prompt」:FluxモデルはNegative Promptを使用しないためここは空欄で。

③「Sampling steps」:「Dev」は20、「Schnell」は4が推奨されている。

④「Width / Height」:ここでは「1152/896」とした。

⑤「CFG Scale」:Fluxモデルは「1」で固定。

⑥「Distiler CFG Scale」:Fluxモデル特有の機能で、通常のCFG Scaleを補完または置き換える。推奨値は「3.5」。

⑦「Generate」:画像生成を開始

プロンプトは前回も使用したものを流用。なお、これで30トークンなのでこれの2.5倍くらいの分量まではいけそうだ。

プロンプト:A photorealistic portrait of a young woman with dyed pastel pink hair and subtle makeup, wearing trendy streetwear, standing in a bustling urban crossing with neon signs in the background

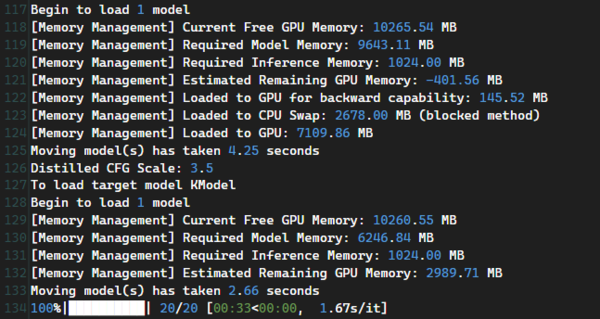

「Generate」をクリックすると生成が開始される。ログを注意深く見ていくとわかるが、モデルのロードに必要なメモリーの計算をして、GPUメモリーで足りない分はCPU側のメモリーにロードしているようだ。

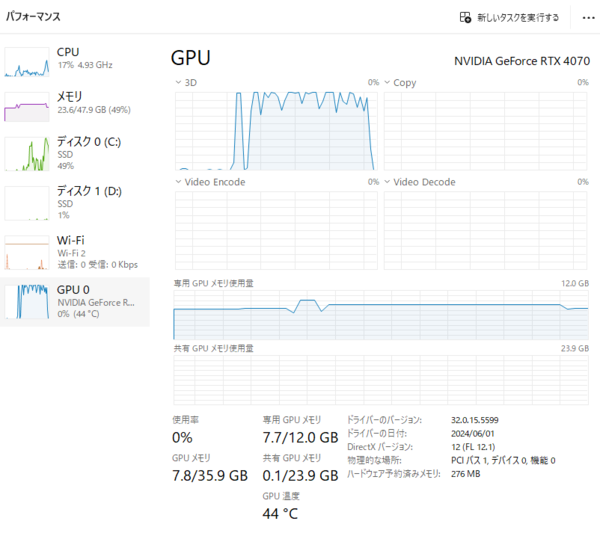

タスクマネージャーのパフォーマンスを見ると、GPUメモリーは12GB中7.7GBしか使われておらず、CPUのメモリーが23.6GB使われていることがわかる。貴重なGPUメモリーをCUDAの共有GPUメモリーではなく通常のCPUメモリーで肩代わりしているわけだ。

ということで、無事いつものピンク髪お姉さんが生成された。かかった時間は50秒だったが、2度目以降は35秒ほどに落ち着いた。ComfyUIでは1分以上かかっていたので大幅なスピードアップに思えるが、今回使用しているのは前述のように量子化によって軽量化したNF4版のため、純正モデルより画像のクオリティーは落ちているはずだ。

この連載の記事

-

第40回

AI

Suno級がローカルで? 音楽生成AI「ACE-Step 1.5」を本気で検証 -

第39回

AI

欲しい映像素材が簡単に作れる! グーグル動画生成AI「Veo 3.1」の使い方 -

第38回

AI

最新の画像生成AIは“編集”がすごい! Nano Banana、Adobe、Canva、ローカルAIの違いを比べた -

第37回

AI

画像生成AIで比較!ChatGPT、Gemini、Grokどれを選ぶ?得意分野と使い分け【作例大量・2025年最新版】 -

第36回

AI

【無料で軽くて高品質】画像生成AI「Z-Image Turbo」が話題。SDXLとの違いは? -

第35回

AI

ここがヤバい!「Nano Banana Pro」画像編集AIのステージを引き上げた6つの進化点 -

第34回

AI

無料で始める画像生成AI 人気モデルとツールまとめ【2025年11月最新版】 -

第33回

AI

初心者でも簡単!「Sora 2」で“プロ級動画”を作るコツ -

第32回

AI

【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ -

第31回

AI

“残念じゃない美少女イラスト”ができた! お絵描きAIツール4選【アニメ絵にも対応】 -

第30回

AI

画像生成AI「Midjourney」動画生成のやり方は超簡単! - この連載の一覧へ