オルツは、「P.A.I.(パーソナル人工知能)」を開発するAIベンチャーで、独自開発したLLM(大規模言語モデル)である「LHTM-2(ラートム2)」を活用したAIサービスを展開している。

今回は、オルツのCTOである西村祥一氏に、LHTM-2を開発した経緯を伺いつつ、同LLMを活用した、人間の人格をデジタルで再現する「CLONEdev」やノーコードでAIチャットボットを作成できる「altBRAIN」をレビューする。

パーソナル人工知能のために日本発の独自LLMを開発

オルツが創業したのは2014年11月。当時は、ChatGPTのような機械学習を用いた対話エンジンはなく、ヒューリスティックな自然言語処理が主流だった。しかし、オルツは近い将来、人知を超えたようなAIと会話ができる時代が来ると見越して、準備を進めていた。

そして2017年に、生成AI誕生のブレイクスルーとなった論文「Attention Is All You Need」が発表される。オルツも論文を元に環境を構築して、研究を開始。2022年にはChatGPTがリリースされて大ブレイクした。

「我々もChatGPTに匹敵するような日本語版のLLMを作ろうじゃないかと取り組んだのが『LHTM』です。その時は、ChatGPTを使えばいいのではという声も多かったのですが、他社のLLMだとカスタマイズができない。我々が手掛けるパーソナル人工知能は、それぞれの顧客に応じてカスタマイズする必要があります。『自由にカスタマイズできる言語モデルを自社で持たなければいけない』という想いが開発の経緯です」(西村氏)

生成AIでは、事実と異なることをもっともらしく出力してしまうハルシネーション(幻覚)が混じることがある。個人用途であれば笑って済ませられるが、ビジネスユースだとトラブルの原因になりかねない。

そこで「LHTM-2」は、RAG(Retrieval-Augmented Generation、検索拡張生成)と呼ばれる手法を用いている。例えば、ある国の首都について質問されても、その答えをLLMが持っている必要はなく、根拠付けとして検索などで情報を取得し、その情報をもとにLLMが人間らしく解答してくれるのが特徴だ。

さらにハルシネーションに対して、2つの対応策を用意している。ひとつ目が、ハルシネーションスコアを算定することだ。LLMが回答した文章がどれくらい確からしいかをスコア化する。90%正しいとなっているなら信じよう、20%であれば使うのをやめよう、といった判断が可能になる。

もうひとつが、出力のソースを確認できること。もしミスがあった場合に原因を辿ることができる。AIとは言え、出力するロジックがブラックボックス化するとビジネスで使いづらい点を解消している。

人格生成プラットフォーム「CLONEdev」で経済学者の成田悠輔さんと話してみた

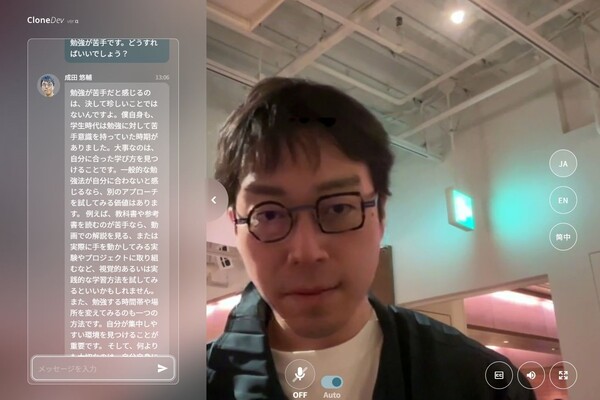

オルツの人格生成プラットフォーム「CLONEdev」は、人間の人格をデジタルで再現するシステムだ。現在はα版で、オルツのCEO 米倉千貴氏、経済学者の成田悠輔氏、およびアーティスト・シンガーソングライターの静電場朔氏の3名がAIクローン化されており、会話ができる。

CLONEdevのサイトを開き、話したい相手をクリックすると、チャット欄や音声入力を介して対話ができる。本人の映像が表示されるだけでなく、本人の声で話してくれるのが凄い。もちろん、AIっぽさはあるが、声やイントネーションが本物に近いのだ。

実際に、成田氏のクローンに色々と質問してみた。普段切れ味のいいシニカルな物言いをする成田氏だが、AIの回答は優等生気味。とはいえ、成田氏の経験談などから回答してくれることもあり、本人と話しているような雰囲気は感じられた。

右側の言語ボタンを切り替えると、英語と中国語で回答してもらうこともできる。成田氏の声で流ちょうに話すうえ、リップシンクもしているのが驚きだ。

もちろん、CLONEdevは同社のLLMであるLHTM-2を利用している。映像に関しては10~20分の動画を機械学習させ、リアルタイムの映像を生成しているという。音声の学習に関しては、これまではスタジオに入って原稿を30分間読んだりする必要があったが、現在は10~20秒話してもらえれば、その人の声を生成できるようになっている。

AIで人格を再現するにはどのくらいのデータを学習させればよいのだろうか?

「人間は生まれた時は喋れないですが、1歳になると少し喋りはじめて、3歳ぐらいになると会話できるようになります。これは、脳が3年分、大人の言っていることなどを溜め込むからといわれ、AIも3年分のデータを入れると話せるようになる感覚です」(西村氏)

SNSやブログ、議事録、Slackなどに書き込んだデータを集めると、3年分くらいのデータは集められる。それらのデータを学習させることで、その人らしく喋る対話エンジンができるという。

「将来的は、ウェアラブルなのか埋め込みなのかはわかりませんが、生まれた時から死ぬまでずっと記録される時代が来ると思っています。今は倫理的にも受け入れられる社会ではないので難しいですけど、その時に備えて、自分が見たもの聞いたものの記録は、極力取っておきたいと考えています」(西村氏)