Google I/O 2024で発表されたAI関連まとめ

グーグルのAI「Gemini○○」いっぱいありすぎてワケ分からん問題に分かりやすく答える

2024年05月20日 10時00分更新

Google I/Oで発表された「Gemini○○」

いっぱいありすぎてワケ分からん問題

5月14日(現地時間)にグーグルが開催した開発者向けカンファレンス「Google I/O 2024」では、同社のAIであるGeminiに関連する技術が山程発表されました。正直、ここで発表された「Gemini○○」と名付けられたサービスや技術が多過ぎて、一般の人にはなんだかよく分からんという状態になってしまっていたような気がします。

まあ、元から技術者向けのカンファレンスなので一般の人がどうしても理解しなければいけない内容でもないのですけど、たとえ一般人であっても、あのグーグルが何を考え、次に何をしようとしているのか知っておきたい、と思っても不思議はないでしょう。そこで本稿では、「Google I/O 2024」で発表された内容を、私と同じくらいの一般の方に向けてキーワードごとにちょっとずつ解説してみようと思います。

「Gemini 1.5 Pro」200万トークン入力可能になったことの何がすごいのか?

→ 将来的には『ONE PIECE』に張られた伏線をすべて列挙できる

■Gemini 1.5 Pro

まず、頭に入れておいてもらいたのが、Geminiシリーズのメインプロダクトである「Gemini 1.5 Pro」です。

Gemini Proは、マルチモーダル対応の多機能AIモデル。テキストはもちろん、音声や画像、動画などの入力データを理解し、さまざまなタスクに対応できる性能を持った、一般利用できる高性能なGeminiシリーズです。

今回の発表では、「このGemini 1.5 Proは、コンテキストウィンドウが200万トークンと大幅に向上した」というのがトップトピックでした。とはいえ、この時点でもう一般人にはよく分からない感じかと思います。

コンテキストウィンドウというのは、AIが推論するに当たり、あらかじめAIに渡しておける事前情報や資料のこと。コンテキストが資料、ウィンドウがそれを乗せる机です。要するに、より多くの資料を机の上に積み上げて、それを元に、さらに深い考察やその中の複数の因子から導き出す高度な推論ができるようになった、ということなんです。

問題は、この200万トークンというのがどのくらいの情報量なのか、ということです。具体的には、

●200万トークンの情報量

・2時間のビデオ≒映画1本分

・22時間のオーディオ≒約1日分の会話録音

・1500ページのテキスト

に当たります。つまり、Gemini 1.5 Proなら、1本の映画から、そのテーマやテーゼの考察、ストーリーテリングの技法、伏線と回収、映像表現技法、役者の演技などを多角的に推論、研究することができるようになり、1日分の録音データから、その人の1日の行動履歴を追い、興味深いトピックだけを抜き出して日記を付けたり、誰とどこで会ってどんな会話をしたかを抽出したり、何を見たり食べたりして、そのとき感情がどう動いたかといったことを推察することもできるというわけです。

また、1500ページのテキストがどのくらいのものかと言えば、日本聖書教会発行の旧約聖書のページ数が1502ページです。まあ、聖書を持っているという方もそう多くはないでしょうから、もう少し身近な例でいうと、厚すぎて鈍器代わりとしても利用できるのではと評判の京極夏彦先生の小説の最新刊『鵺の碑(ぬえのいしぶみ)』 が832ページ、先生の最も厚い本『絡新婦の理(じょろうぐものことわり)』が1408ページです。

で、Geminiが京極夏彦を読破できたから何なの?って思いましたよね。ではこのトークン数が増えるとどんなことができるのか、もう少し具体的な例を挙げてみましょう。

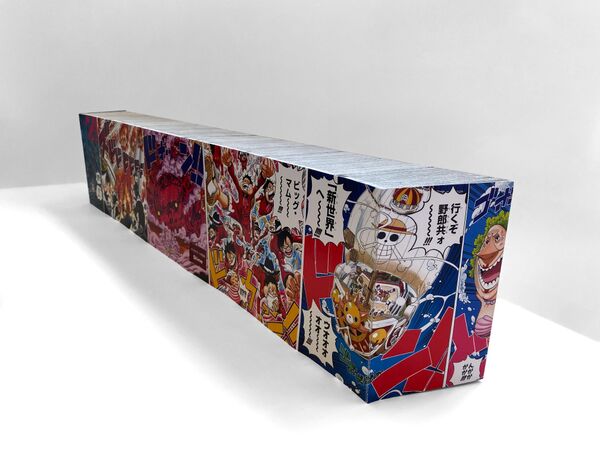

尾田栄一郎先生の長編漫画『ONE PIECE』は、多くの伏線が張られていて、最終話に向けその伏線回収考察もファンの楽しみのひとつになっていますが、この『ONE PIECE』の25年分の連載を1冊にまとめた海外のアート作品「ONEPIECE BY ILAN MANOUACH」は 2万1450ページあるそうです。最終話までにはまだページ数が増えそうですが、要するに入力トークン数が劇的にアップするということは、将来的にGemini Proは『ONE PIECE』全巻に張り巡らされた伏線回収を一瞬ですべて列挙できるくらいの性能になる、という未来も見えてくるわけです。

JBE BOOKSで販売されているアート作品「ONEPIECE BY ILAN MANOUACH」(€1,900.00 EUR)日本円で約32万円強。ちなみに日本で現在発売中のコミックス全巻(105巻)なら4万9000円です。急に安く思えてきますね。

とはいえ他のAIだってバカじゃありませんので、Gemini Proが2万ページ超の漫画をすべて読んで理解できる能力を持った時点で「『ONE PIECE』の伏線回収リストを出して」とお願いしたら、ほとんどの場合、1巻からすべて読んで探す、なんてことはせず、すでにどこかでまとめられている一覧表を引っ張り出してくると思います。Gemini Proでもそれは同じです。しかし、本当にこのどこかから持ってきた一覧表に書かれていることが全てなのか? ほかにも誰にも気づかれていない隠された伏線はないのか? それをリストと照らし合わせて見つけ出せるとしたらどうでしょう? それができるのが、Gemini ProのようなAIというわけです。

そのほかのGemini○○と名付けられたAIたち

■Gemini 1.5 Flash

さて、続いては「Gemini 1.5 Flash」です。こちらはより高速な応答を目指した軽量モデルのGemini。今回のGoogle I/Oではじめて仲間入りした新モデルですが、コンテキストウインドウは100万トークンで、もちろんマルチモーダル対応。

専門的な研究や開発向けというより、一般論や広く知られた知識をベースにした、翻訳やコーディング、文章の要約、画像や動画のキャプションや字幕付け、長い文書や表からのデータ抽出などなど、高頻度なアクセスが必要な、より限定されたタスク向けのモデルです。

要するに専門職でない一般的なホワイトカラーワーカーのAIを利用する仕事のほとんどは、このGemini 1.5 Flashで対応できてしまうというわけです。光の速さで仕事を終わらせるモデル、それがGemini 1.5 Flash。

また、回答速度が速いので、ブレインストーミングや壁打ちのチャット、アイデアのブラッシュアップなどに利用するのにも良いモデルと言えます。「フラッシュアイデア」という言葉から連想されるように、ひらめきを得るためのモデル、として覚えると分かりやすいと思います。

このモデルとGemini 1.5 Proとを比較しての一番のメリットは、運用コストのパフォーマンスに優れている点で、APIを利用してAIサービスを作る際、かかるコストが段違いに安く済みます。具体的な数値を出して話をするとまた頭が混乱してきますのでここでは省きますが、Gemini 1.5 FlashのAPI利用では、Gemini 1.5 Proのおよそ10分の1から20分の1のコストで済みます。一般業務向けのAIサービスであれば丸っと対応可能なので、無理にコストのかかるGemini Proを利用しなくても済む、というわけです。

■Gemini 1.0 Nano

「Gemini 1.0 Nano」は、Android機など、オンデバイス向けのAIモデル。こちらはマルチモーダル対応になったことが今回の発表のトピックで、今後はAndorid OSに組み込まれ、AndoridはAI OSになっていくとのことなので、一般人にとっては最も身近になりそうなGeminiです。

Google I/Oでは、通話時に会話パターンから詐欺電話の可能性がある場合にアラートを発してくれるデモンストレーションが行われました。

▼

このデモが示しているのは、Geminiがデバイスの中で独立して活用されている、ということで、通話するたびに通話内容をサーバーに送って詐欺かどうか判断している、なんてことになったら安心して電話なんて掛けられませんよね。しかし、これからはスマホの中のAIが独自にそのくらいの判断はしてくれるようになる、というわけです。

このほかにも、マルチモーダル対応になったことで、サーバーにある膨大なバックエンド資料と照合しなくても、写真やカメラを通して見た世界をスマホの中にあるGeminiの知識だけで推察したり、電話でのやりとりを文字起こしする、1ヵ月分のチャットのやりとりをまとめて要点だけ箇条書きにする、といったことが、ネット環境の有無を問わずできるようになります。

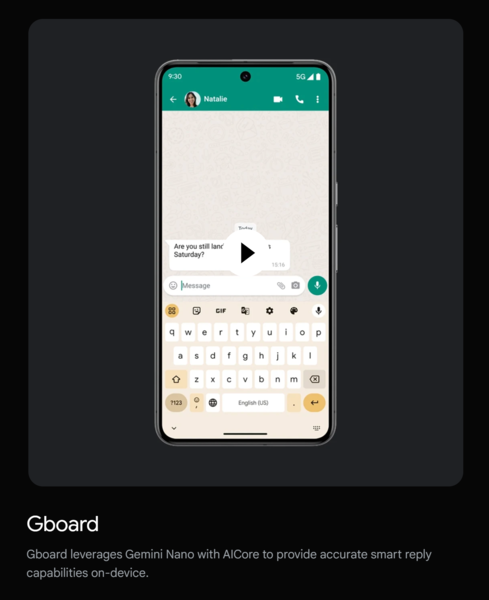

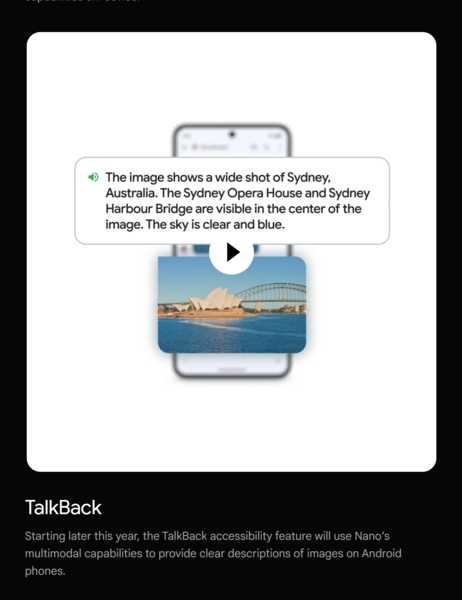

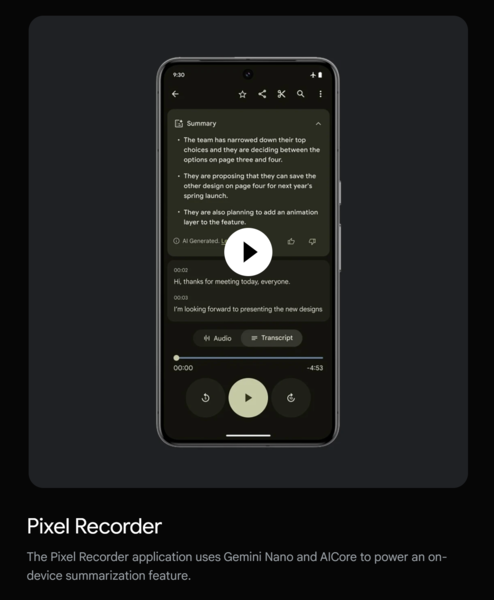

もちろん、Android向けアプリからもAPIを介して利用可能。グーグルからは、すでにGemini 1.0 NanoとAndroid 14から導入している「AI Core(AIコア)」アプリという仕組みのなかで、チャットやメールにAIが自動でいい感じに返信してくれる「Gbord」、スマホの中にある写真や画像を説明し視覚障害者の手助けをしてくれる「Talk Back」、スマホに保存したテキストを要約してくれる「Pixel Recorder」といったものが発表されています。

●Gemini Ultra

今回のGoogle I/Oでは言及がありませんでしたが、Geminiには、Proの上に最上位モデルとして「Gemini Ultra」というモデルもあります。こちらは、Gemini Proよりさらに大規模で上位の開発に向けたAIで、非常に複雑なタスクに対応し、AIの性能限界を押し広げるために使われるようなAIとなっています。

●Gemini Live

今回の発表で、名前は挙がりましたが特にデモンストレーションなどは行われなかったのがこちらの「Gemini Live」。これは、人間との自然な対話が可能になるGeminiということでしたが、お目見えするのは今年の後半とのこと。

実は、より自然な対話や人間くさいレスポンス、といったAIの反応は、Google I/Oの前日にOpenAIが発表したChatGPTの新バージョンGPT-4oの押していたポイントでもあり、この発表で発話を聞かせるデモがなかったことで、Gemini Liveの精度はまだGPT-4oレベルにまでは達しておらず、急遽デモンストレーションをしないで済ませる演出にしたのではないかという穿った見方をしてしまいました。GPT-4oは、近々スマホ版のアプリでも自然な対話が可能になると言われていますので、一歩先んじることにはなりそうですが、どちらにしろ、Geminiも同じように自然な反応を返すようになっていくようです。

AIじゃないけど「Gemini○○」と名前の付いたアレ

●Gemini Advanced

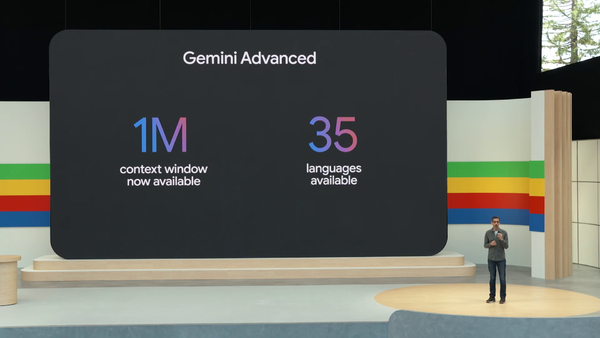

Geminiの名前を冠するものを列挙していくと、もうひとつでてきたのがこの「Gemini Advanced」。こちらはAIの名前ではなくて、Geminiを利用する有料プランの名称で、グーグルのサブスクサービス「Google One」の最上位プランである「Google One AI プレミアム」に含まれるサービスです。こちらのサービスでは100万トークンのコンテキストウィンドウが利用でき、35ヵ国語をカバーするとの発表がありました。

日本では月額2900円で2TBのオンラインストレージ(Googleドライブ)付き。2ヵ月間は無料で使えます。

●Gemini Era

おまけにもうひとつ、プレゼンテーションの冒頭でピチャイCEOが口にした「The Gemini Era」ですが、こちらはプロダクトでもサービスでもなく、単に「これからはGeminiの時代です」という今回のプレゼンのテーゼを表わした言葉です。

この宣言どおり、2時間の発表のほぼすべてがAI関連の話題で、新しいハードウェアや予想を裏切るようなサービスのプレゼンはまったく含まれないGoogle I/Oとなりましたが、ここまで解説してきた「Gemini○○」と名前の付いたもの以外にも、多くのAIサービスやプロダクトが発表されました。残りの発表内容についても知っておきたい方は、ぜひ以下の記事で。