情報通信研究機構(NICT)は7月4日、独自に収集した350GBの日本語ウェブテキストのみを用い、400億パラメータの生成系大規模言語モデル(LLM)を開発したと発表した。

きっかけはChatGPT

NICTはこれまでも深層学習を自然言語処理技術に応用し、様々な研究開発に取り組んできた。

独自に収集した日本語のウェブテキストを用い、グーグルが開発したBERTをベースに日本語用に改良した識別系言語モデルを構築。大規模ウェブ情報分析システム「WISDOM X 深層学習版」や高齢者介護支援用対話システム「MICSUS」等の実績がある。

一方、生成系言語モデルに関しては、偽情報やバイアス、各種悪用のリスクが指摘されていることもあり研究は出遅れていたが、2022年のChatGPTの登場以降、自国での開発力強化が喫緊の課題と認識し、本格的に取り組み始めたという経緯だ。

スピード重視のため性能はまだまだ

今回発表したLLMは、これまでのノウハウの蓄積もあり、ユーザインタフェースを含め4ヵ月程度で開発が完了した。

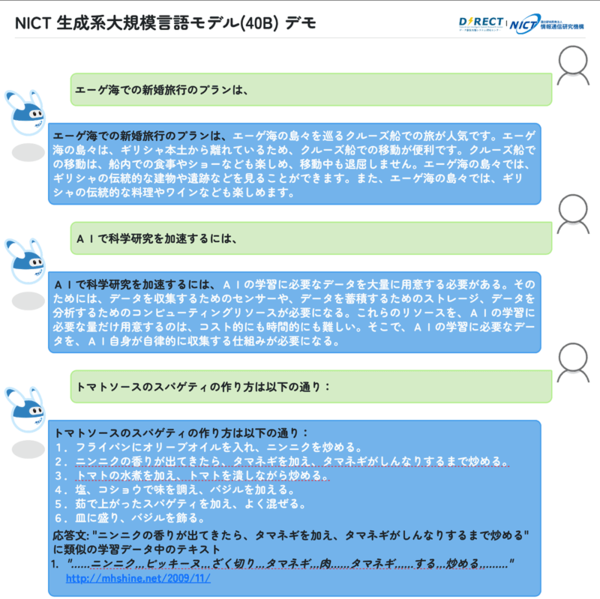

今回は学習の完了を最優先課題としたため、ファインチューニングや強化学習は未実施。その結果、誤回答、短めの入出力、あまり洗練されていない日本語表現など、性能面ではまだまだChatGPTと比較できるレベルにはないが、各種質問への回答、要約、論文要旨の生成、翻訳などが可能になっている。

さらに、生成したテキストに類似するテキストが学習データにないかを自動検索し、著作権侵害のチェックを容易にしているという。

現在は、1750億パラメーターのGPT-3と同等規模となる1790億パラメータの生成系LLMの学習を実施中であり、学習用テキストの大規模化にも取り組んでいるという。

今後は、共同研究等を通じ、民間企業、国研、大学等と協力し、日本語の大規模言語モデルの研究開発や利活用に取り組む予定だ。