AMDが米国時間の11月8日に開催したオンラインイベント“AMD Accelerated Data Center Premiere”の概略は発表記事にまとまっているが、これをもう少しかみ砕いて説明していこう。まず今回はMilan-Xの話である。

AMDがMilan-Xこと第3世代EPYCを発表

2022年第1四半期に投入

今回の発表内容は「3D V-Cacheを搭載したMilanベースのEPYCを、2022年第1四半期に市場投入する」の一言に尽きる。この3D V-Cache搭載MilanはMilan-Xというコード名なので、以下記事内でもMilan-Xで通すが、このMilan-Xはすでに特定顧客への納入が始まっていることも明言されている。

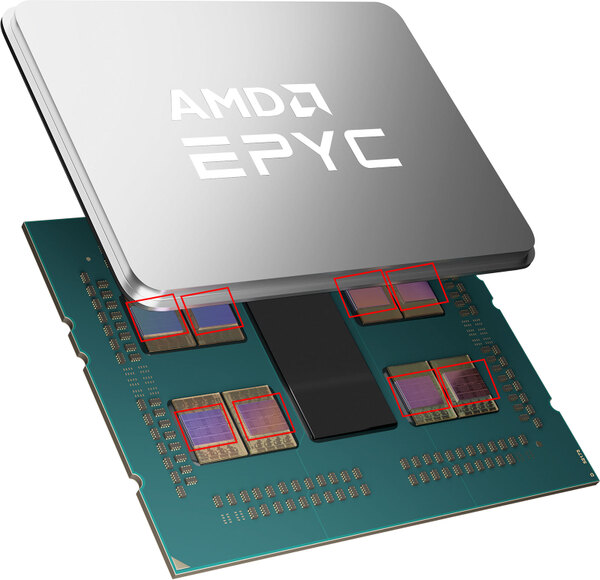

さて、そのMilan-Xであるが、こちらは純粋にMilanの既存の8つのダイを、3D V-Cache付きに更新しただけである。

キャッシュは以下のとおり。

- L1:(命令32KB+データ32KB)×8=512KB

- L2:Unified 512KB×8=4MB

- L3:Unified 32MB→Unified 96MB

ダイあたりで言えば合計100.5MBとなり、EPYCは最大8ダイなので100.5MB×8=804MBとなる計算である。

下の画像の3Xは、L3が32MB→96MBになるから3Xという話で、その意味では下の画像にあまり新しい話はない。

3D V-Cacheそのものは連載618回で技術的な要素を説明しているので今回は特に触れない。3D V-Cacheには以下の特性があるので、Milan-Xの動作周波数やTDPなどは、おそらく現行のEPYC 7003シリーズとほぼ変わらないものになるだろう。

- レイテンシーは3D V-Cacheの有無でそれほど大きな差はない(微妙に大きくなる)

- 消費電力も3D V-Cacheの有無でそれほど大きな差はない

- コアの動作周波数そのものには影響がない(内蔵L3と同じ動作周波数で動くため)

ちなみにレイテンシーが微妙に大きくなるというのは、一般論としてキャッシュを増やすと「キャッシュのどこに、どのメモリーアドレスの内容が格納されているか」を記録しているTag RAMのサイズが当然増えることになる。

するとTag RAMの平均的な検索時間が延びることになる。Tag RAMの先頭で目的のアドレスを見つけられれば、Tag RAMのサイズに関係なく最小ですむが、Tag RAMを全部検索して最後で見つけた場合は、Tag RAMのサイズが増えると余分に時間がかかることになるからだ。

もちろんこの検索は最速で行なわれているから、これでレイテンシーが10サイクルも増えたりはしないし、Tag RAMの「どこで」見つけるかにもよるので、必ずレイテンシーが増えるとも限らない。ただ平均的には1~2サイクル程度のレイテンシーの増加が見込まれると思われる。

これによる性能劣化よりも、L3容量を3倍増にしたことによるメモリーアクセス性能改善効果の方が圧倒的に大きいので、おそらく通常のベンチマークではこれによる性能の劣化はまずないだろう。加えて消費電力や動作周波数にはほぼ影響がないため、Milan-Xは純粋に性能が改善したMilanとして扱えるわけだ。

では性能としてはどうか? ということでAMDから示された例が下の画像だ。

16コアのEPYC 73F3では1時間あたり24.4本の検証ジョブを実施できるのに対し、同じ16コアの3D V-Cache搭載EPYCでは40.6本のジョブを実施できたという話で、66%の向上が見られたとしている。

AMDから出された性能評価はこれで終わりだが、まだ公式には製品発表前ということもあるので、おそらく来年のCESあたりでもっと細かな性能評価が出てくるものと思われる。現時点では、いくつかのISVがすでにMilan-XベースのEPYCへの対応を進めていることのみが表明されている。

この連載の記事

-

第794回

デジタル

第5世代EPYCはMRDIMMをサポートしている? AMD CPUロードマップ -

第793回

PC

5nmの限界に早くもたどり着いてしまったWSE-3 Hot Chips 2024で注目を浴びたオモシロCPU -

第792回

PC

大型言語モデルに全振りしたSambaNovaのAIプロセッサーSC40L Hot Chips 2024で注目を浴びたオモシロCPU -

第791回

PC

妙に性能のバランスが悪いマイクロソフトのAI特化型チップMaia 100 Hot Chips 2024で注目を浴びたオモシロCPU -

第790回

PC

AI推論用アクセラレーターを搭載するIBMのTelum II Hot Chips 2024で注目を浴びたオモシロCPU -

第789回

PC

切り捨てられた部門が再始動して作り上げたAmpereOne Hot Chips 2024で注目を浴びたオモシロCPU -

第788回

PC

Meteor Lakeを凌駕する性能のQualcomm「Oryon」 Hot Chips 2024で注目を浴びたオモシロCPU -

第787回

PC

いまだに解決しないRaptor Lake故障問題の現状 インテル CPUロードマップ -

第786回

PC

Xeon 6は倍速通信できるMRDIMMとCXL 2.0をサポート、Gaudi 3は価格が判明 インテル CPUロードマップ -

第785回

PC

Xeon 6のIOチップレットには意地でもDDR5のI/Fを搭載しないインテルの強いこだわり インテル CPUロードマップ -

第784回

PC

Intel 3は300~500MHz動作周波数が向上する インテル CPUロードマップ - この連載の一覧へ