国立情報学研究所、東京大学、ドワンゴなどは9月12日、10億個程度のビッグデータでも高速かつ少ないメモリーでクラスタリングを実行できる新手法を開発したと発表した。

ビッグデータ処理のひとつであるクラスタリングは、似たデータをまとめてグループに分ける処理で、例えばSNSにアップロードされている膨大な画像データに対して「動物」、「風景」といったグループに分類する。基本的な処理ではあるが、膨大なデータでは処理速度・メモリー容量的に個人レベルで使えるパソコンでは実行するのが難しく、多数のサーバーを用いた分散並列処理を必要とした。

国立情報学研究所、ドワンゴ、東京大学などの共同研究グループは、「直積量子化」とよばれる技術を用いてデータを圧縮。さらに圧縮データに対して「似ているデータを集めてグループを作る」、「グループの平均を計算する」という処理を繰り返すことで高速なクラスタリングを可能とする手法を開発した。

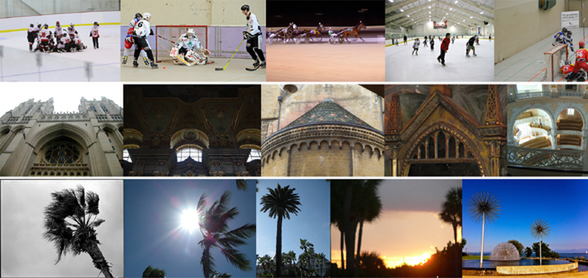

この手法では、既存の手法に比べると非常に高速かつ少ないメモリーで実行できる。1億枚の画像を「氷上のスポーツ試合」や「欧風の教会」、「ヤシの木」といった10万種類のグループに分類する処理を、クアッドコア/メモリー32GBのPCでおよそ1時間で実行できたという(従来方法ではおよそ300台を必要とする)。

既存の高速化手法では元データを不可逆的に変形する必要があり、クラスタリング結果を別の処理に利用することができないなどの難点があったが、データを番号で扱う直積量子化なのでデータの復元が可能なほか、シンプルに高速化できるという。これにより、一般の技術者や研究者でもビッグデータの扱いが容易になるため、AI開発をはじめとする広い分野での活用が期待される。