AIのプロに学ぶ、RTX PRO AIマシンの使いこなし術 第2回

NVIDIA高橋 想氏、津田恵理子氏にインタビュー

いま、NVIDIA RTX AIワークステーションを導入する企業が増えている理由

2025年03月19日 11時00分更新

いま、NVIDIA RTX搭載AIワークステーションが注目される理由

生成AIの進化が加速する中、その可能性をビジネスに取り入れるために重要となるのが、高性能で使いやすい環境の整備だ。

AI開発の現場では、これまでクラウドサーバーに依存していた推論処理を、オンプレミス環境で実行する必要性が高まっている。その背景には、機密性の高いデータを扱う場面が増えていることや、ローカル環境で迅速に試行錯誤できる機動性の重要性が増していることがある。

特に、大規模言語モデル(LLM)の開発ではRAG(Retrieval-Augmented Generation)やファインチューニング、ローカルLLMの構築が本格化しており、データの秘匿性を保ちつつ迅速に開発を進めるためには、クラウドだけに依存しない環境が求められるようになった。こうした流れの中で、注目を集めているのが、NVIDIA RTXを搭載するAIワークステーションだ。

本記事では、NVIDIAの高橋想氏、津田恵理子氏へのインタビューを通じて、NVIDIA RTXを搭載するAIワークステーションの可能性を探る。さらに、AI推論の開発環境を大幅に簡素化し、事業の継続性を高めるマイクロサービス「NVIDIA NIM」についても解説していく。

NVIDIA RTX搭載AIワークステーションの持つポテンシャル

──AI、特に生成AIが実装フェーズに入ってきている中で、強力なGPUを搭載するワークステーションの存在価値も高まってきています。まずは、NVIDIA RTXが、どのようなGPUかという視点から、AIワークステーションの強みを確認していきましょう。

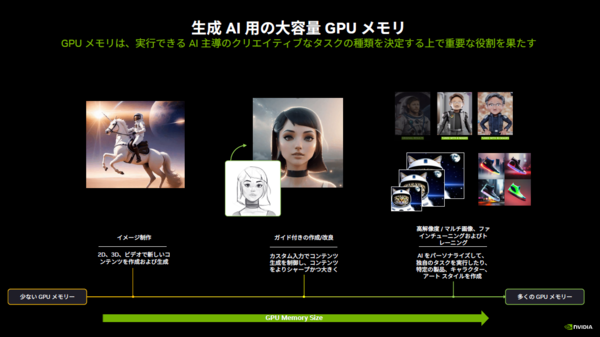

高橋「NVIDIA RTXの持つ強みは、第一に、プロフェッショナル用に性能をチューニングしている点です。GPUの性能を示す指標はいくつかありますが、大きなデータセットに対応できるかどうかは、GPUメモリのサイズで決まります。特にウルトラハイエンドのRTX 6000 Adaでは48GBメモリを搭載しており、コンシューマー向けの製品と比較すると、こうしたチューニングの部分には大きな違いがあります」

──前回の記事では、企業の機密データを秘匿性を保ったまま扱える点や、手元の環境でトライアンドエラーを素早く繰り返せる点など、ローカル環境で生成AIを使うことのメリットをいくつかうかがいましたね。実際に、NVIDIA RTXを搭載したワークステーションをビジネスに導入する場合、どのようなスペックになってくるのでしょうか?

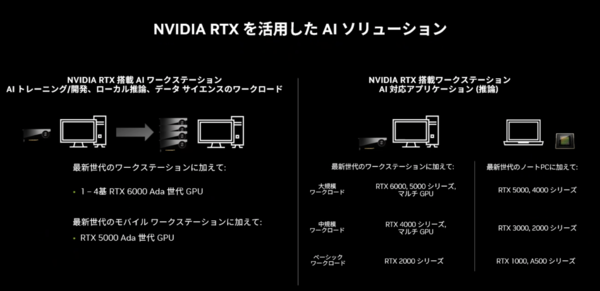

高橋「一例を挙げると、『NVIDIA RTX 6000 Ada(以下、RTX 6000)』を2枚、4枚と挿す構成が、市場でも増えてきている印象です。クラウドに依存せず、ローカル環境で高性能なAI推論を実現しようとすると、それくらいのスペックが求められることが多いですね。

クラウドベースのデータセンターは、利用予約が必要だったり、使いたいときにインスタンスを動かせないことがあります。そのため、ローカルワークステーションでのAI推論は、より柔軟な選択肢として注目されていると考えています」

高橋氏が話すように、NVIDIA RTX搭載AIワークステーションは、RTX GPUを最大4枚まで搭載可能な設計となっている。従来のワークステーションは基本的に1枚のGPUを前提としていたが、計算能力の飛躍的な向上が求められるAI開発においては、マルチGPU構成が標準になりつつあるのだ。

特に、ハイエンドモデルとなるRTX 6000 Adaでは、内蔵GPUメモリーは48GBに達しており、より大規模なAIモデルの推論処理にも対応できる。

──AI推論開発の現場の話に触れると、ライブラリが頻繁にアップデートされて、些細な非互換が原因で「動かない」という事態もありえますよね。サポートを得られるプロ向けモデルなら、その辺りのリスクを低減できるメリットもあるかと思うのですが。

高橋「そこもNVIDIA RTXシリーズ搭載ワークステーションを選択するポイントです。実際にビジネスの現場で使用するとなると、各ソフトウェアが長期間安定して動作することが必要条件です。NVIDIA RTXは、各ソフトウェアの動作認証を取得しているだけでなく、継続的なドライバーの提供や、ロードマップに沿った製品展開が行われています。長期間にわたって使い続けることを想定して開発されているのです」

この連載の記事

-

第5回

sponsored

NVIDIA RTX PRO AIワークステーション、Blackwell世代で迎える新たな進化の現在地 -

第4回

sponsored

「買ってすぐ業務に使える」ローカル完結型のRAGが生まれた背景 -

第3回

sponsored

AIワークステーション “Lenovo ThinkStation”は「効率的で、しかも安い」価値創造の源泉 -

第1回

sponsored

生成AIの次なるステージ:ローカル環境がビジネスの新しい扉を開く理由 - この連載の一覧へ