ウイングアーク1stの「Updata Now 24」基調講演パート2

Teams会議をリードし、手書きメモを説明し、多言語で話す マイクロソフトのAI最新動向

2024年11月11日 09時00分更新

ウイングアーク1stの「Updata Now 24」の基調講演に登壇した日本マイクロソフト CTO 執行役員 常務の野﨑弘倫氏は、同社が注力する生成AIの最新デモを披露。Teams上で会議をリードし、手書きメモを説明し、当人のように多言語で講演する。そんな生成AIの今の到達点を披露し、聴衆を魅了した。

チャットボットからAIエージェント、マルチモーダルへ

ウイングアーク1st代表取締役 社長執行役員CEO 田中潤氏に「生成AIのすごさをみなさんに披露してほしい」と紹介されたゲストは、日本マイクロソフト CTO 執行役員 常務の野﨑弘倫氏。「AI Transformation マイクロソフト生成AI最新動向」と題して、AIに注力するマイクロソフトのテクノロジーを披露した。

経産省の統計によれば、2025年までの生成AIの経済効果は、中小企業だけで11兆円、日本全体では34兆円に上る。これは日本のGDPの約6%にあたるという。こうした生成AIのキートレンドとしての野﨑氏は、「2022年11月30日にChatGPTが登場し、約2年近く。生成AIの素晴らしい成果を見てもらってきたかと思いますが、そうしたチャットボットを使った形が一周し、新しいモデルの使い方になっていく」とコメント。チャットボットからビジネスプロセスへの展開、複雑なタスクと実行を行なうAIエージェント、インプットとアウトプットのマルチモーダル・マルチモデル化を挙げる。

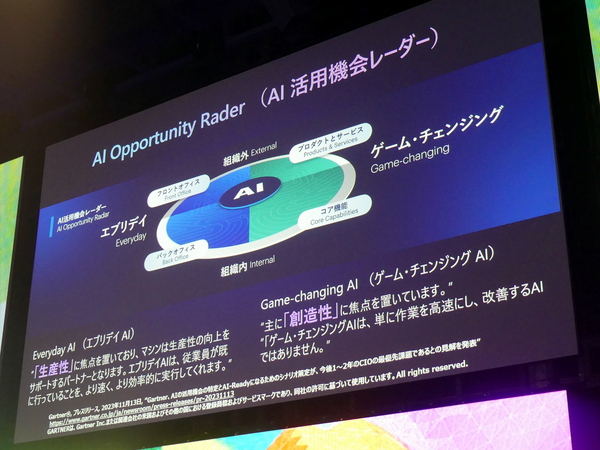

こうした中、AIの活用方法としては、生産性向上に焦点を置いた「エブリデイAI」と、創造性に焦点を置いた「ゲームチェンジングAI」があると説明。従業員が行なっている作業をより速く、より効率的に実行してくれるエブリデイAIに対し、ゲームチェンジングAIは作業の高速化や改善ではなく、イノベーションの創出を実現するものだという。

では、こうしたトレンドの中、マイクロソフトは生成AIに取り組んでいるのか? ご存じの通り、マイクロソフトはWindowsやOfficeなどあらゆる製品にMicrosoft Copilotを搭載。Copilot(副操縦士)として、人間をサポートするAIとして提供してきた。野﨑氏は、Copilotからデータ基盤、インフラまでをレイヤー化した「Copilot Stack」と呼ばれるAIアーキテクチャを元に、基盤モデルの説明からスタートした。

OpenAIから学ぶSLM「Phi-3」 オフラインでの利用が可能に

現在、多くのプレイヤーが覇権を争っている大規模言語モデル(LLM)だが、パラメーター数が膨大で、学習や運用にリソースを消費するという問題点がある。これに対して、マイクロソフトが注力するのは、小規模言語モデル(SLM)のPhi(ファイ)だ。特定領域にフォーカスしたSLMは、パラメーター数も少なくてパワフル。

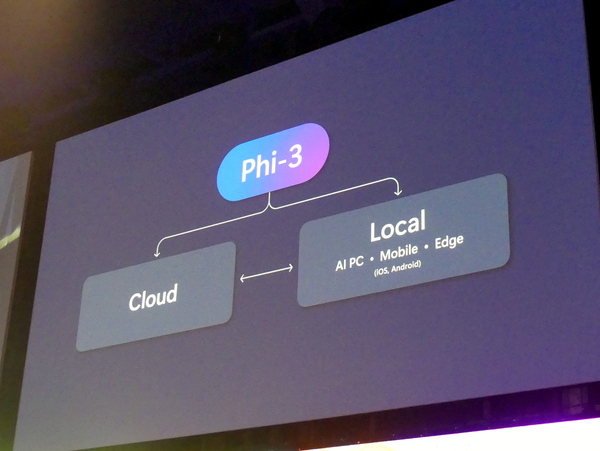

最新版のPhi-3では、3.8Bパラメーターの「Phi-3-mini」、画像認識に特化した4.2Bパラメーターの「Phi-3-vision」、7Bの「Phi-3-small」、14Bパラメーターの「Phi-3-medium」がラインナップ。クラウド前提のLLMに対して、ローカル・モバイルに展開できるという特徴を持ち、実際Copliot PCであれば7GB程度の容量で利用できる。「PC上にモジュールをダウンロードすればオフライン環境で利用でき、製造業などで大きなメリットをもたらす」と野﨑氏はアピールする。

数あるSLMの中で、どこにPhi-3の特徴があるか。これはPhi-3自体がLLMを教師として作られている点だという。「インターネット上にある膨大なデータから、データをセレクトして構築するわけですが、Phi-3はOpenAIを教師として活用し、OpenAIにモデルの選別自体を学んで作られている。コンパクトでありながら、意味のあるデータが含まれている」と野﨑氏は語る。

ユーザーインターフェイスであるCopilotは、ユーザーのフィードバックを受けながら、進化を遂げている。リリース当初は「AIアシスタント」としてユーザーの作業を支援してきたが、機能強化とともに、チームの作業をいっしょに効率化する存在に成長している。具体例で挙げたのは、Teams内での会議をCopilotがリードするという活用。Coplilotがミーティングをリードし、Microsoft Projectにタスクをアサインし、会議後にフォローアップまで行なう。「AIが少しずつ自律的なアシスタントとなり、われわれの作業の生産性を上げてくれる」(野﨑氏)

日本語の講演動画をドラッグ&ドロップで英語版や韓国語版に

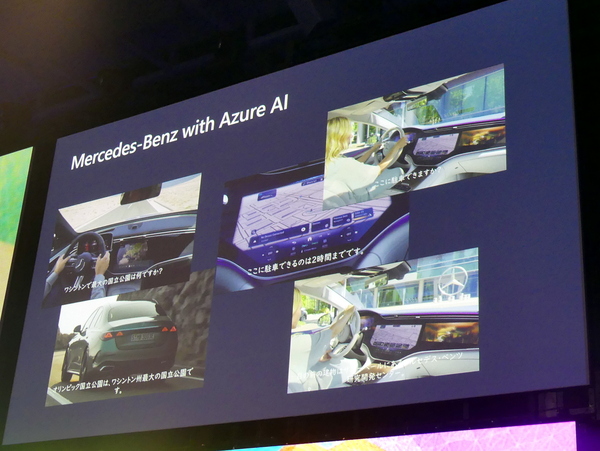

「未来試行」というテーマにあわせたマルチモーダルAI「Copilot Vision」のデモも披露する。ビデオで披露されたたのは、ドライバーと対話するメルセデスの自動車の事例。「ワシントンで最大の国立公園はなんですか?」という質問に答えたり、車載カメラの画像を解析し、車の前にある建物の名前を答えることができる。別のデモビデオでは、写真や手書きのレシピを解析し、自然言語で説明してくれる。

最後に披露されたのは、野﨑氏の過去の登壇を多言語に翻訳するというビデオ。単にテロップが出るだけではなく、野﨑氏の声で英語や韓国語、中国語、タイ語などで講演し始める。野﨑氏は、まるでマルチリンガルな話者のようだ。

これを作るのにかかる時間は5分足らず。Azure上のツールから、動画ファイルをドラッグ&ドロップし、翻訳したい言語を選択すればOK。「同じことをやるためには、発話者が約1時間くらいの音声データを決められたフォーマットで読み、それを学習させるという方法だった。その作業が最新のAIを用いると、ドラッグ&ドロップすれば、何十もの言語に瞬時に翻訳してくれる」と野﨑氏はアピール。「ネイティブの人に聞いても、内容やイントネーションまで含めてほぼ完璧と評価してもらった」という。1年で150の新機能をリリースしているとのことで、ビデオ翻訳も遠からず利用できるようになるという。

最後、野﨑氏は「地球上のすべての個人とすべての組織が、より多くのことを達成できるようにする(「Empower every person and every organization on the planet to achieve more.)」というマイクロソフトのミッションをアピールし、登壇を終えた。