まずは「都内で30分間の自動運転」を目指し、チューリングが開発用計算基盤を構築

生成AIで“ハンドルのない車”に一歩近づく? NTTドコモグループ支援で自動運転AIが始動

2024年11月11日 12時30分更新

既存のルールベースとは異なるアプローチで「完全自動運転」を目指すTuring(チューリング)。将棋AI「ポナンザ(Ponanza)」を開発した山本一成氏が、テスラの登場に刺激され、2021年に立ち上げたベンチャー企業である。

同社は現在、NTTPCコミュニケーションズとNTTドコモ・ベンチャーズの支援を受け、自動運転開発のための専用計算基盤「Gaggle Cluster(ガグルクラスター)」を構築しており、同基盤で開発した自動運転AI「TD-1」の走行試験も開始した。直近の目標は、2025年中に都内で、30分間の自動運転を実現することだ。

自動運転AI「TD-1」のイメージ(YouTubeより)

2024年10月30日に開かれた発表会では、計算基盤や自動運転AIの詳細、今後のチューリングの展望について語られた。

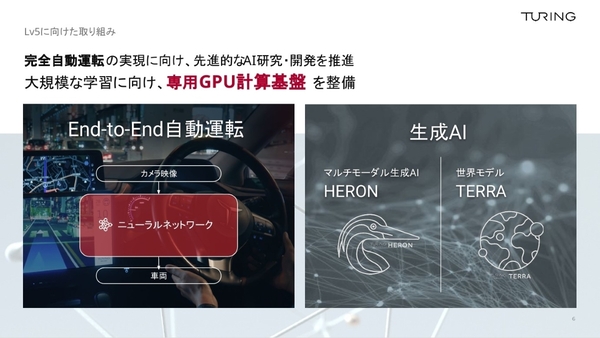

“End-to-End”と“生成AI”で目指す、カメラ映像からすべての運転判断を下せる完全自動運転システム

チューリングの目標は、いまだ人類が到達していない「完全自動運転」の実現である。それは、あらゆる状況下で人の代わりに運転操作をこなすシステムであり、同社の共同創業者 兼 CEOである山本一成氏は、「簡単に言うと“ハンドルのない車を開発すること”」だと語る。

それはもちろん、簡単な道のりではない。技術的なブレイクスルーが必須であり、山本氏は、「今までのセンサーを重視する自動運転では決して実現できず、システムが『人の常識や言語、人がどう動くか』を理解できるようにならなければいけない」と主張する。そのために同社が進めるのが“強力なAI”の開発だ。

このAIに求められる要素は2つあり、ひとつは「End-to-End」。これまで自動運転では、たくさんのモジュールやセンサーで情報を取得して、人が定義したルールベースの手法で、複雑な道路状況に対応してきた。一方、チューリングが取り組むEnd-to-Endな手法では、カメラ映像と車両を単一のニューラルネットワークでつなぎ、カメラ映像を基に、周辺状況の把握から判断、車両の制御までをすべてAIが担う。

もうひとつの要素が「生成AI」だ。あらゆる道路状況に対応するには、人と同様に状況を把握しながら、現実社会のルールに照らし合わせて判断を下す必要がある。自動運転に柔軟な判断力を与える役割を持つのが生成AIになる。

これまでチューリングでは、マルチモーダル生成AI「Heron」や、リアルな運転シーンを動画として出力できる生成世界モデル「Terra」などを開発してきた。

これらのAI開発を加速させるべく、チューリングでは、完全自動運転の開発専用のGPU計算基盤であるGaggle Clusterを構築した。

Gaggle Clusterは、分散学習における性能を最大化するよう設計され、「NVIDIA H100 GPU」を96基搭載。「NVIDIA InfiniBand/NDR400」を用いたネットワークで、GPU同時使用時のサーバー間の通信速度の制約を最小化している。

「大規模なAIを作るためには、1個のGPUだけではなく大量のGPUを協調させる必要があり、そのための足回りも整えた」と山本氏。この計算基盤で、大容量の走行データを高速に学習させていく。

基盤自体のデザインにもこだわりをみせ、「都市から計算基盤にデータを集約して、AIモデルとして実体化して、再び都市に還元する」という自動運転専用の計算基盤としてのコンセプトに合わせて、装飾物が作り込まれている。このコンセプト通り、今まさに東京中をチューリングの車両が走り、AI学習に必要な走行データを収集している最中であり、Gaggle Clusterも1か月半ほど前から稼働している。

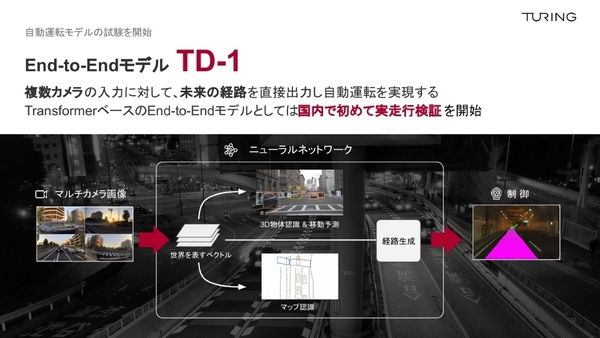

Gaggle Clusterは既に成果をもたらしており、同基盤によって開発されたのが、独自の自動運転AI「TD-1」だ。複数のカメラ画像から未来の経路を直接出力する、自動運転のためのEnd-to-EndなAIであり、既に走行試験も開始されているという。

具体的には、周りの車や歩行者などを認識して、それらの移動を予測するタスクと、これから進む道路などのマップを予測するタスクを実行、それらをもとに経路を生成する仕組みをとっている。

チューリングは、こうした自動運転のためのAIモデルの試験を進めながら、東京の複雑な道路を“30分間以上、人の介入なし”で運転する実証実験(プロジェクト名「Tokyo30」)を、2025年末までに実施することを直近の目標としている。