AIインフラスタック「Dell AI Factory」を発表、Dell Technologies World基調講演

Dell COO「AI時代は再び『オンプレミス』と『PC』が重要になる」

2024年05月23日 08時00分更新

Dell AI FactoryでAI向けシステムを構築するMcLaren Racing

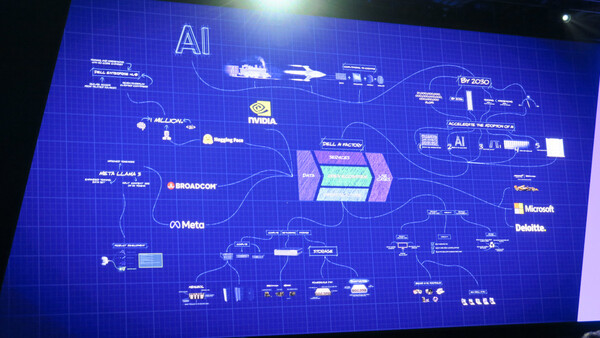

ここまで説明してきたように、Dell AI Factoryは「圧倒的な処理能力、高速なI/0とそれに最適化されたファイル/オブジェクトストレージ、低遅延で高速なネットワークファブリック、データ保護/トレーニング/チューニング/推論などAI向けのソフトウェアツール群、そしてAI PC」(クラーク氏)で構成される。

このアーキテクチャでDellが敷くAI戦略では「オープン性」も重要な要素となる。「オープンなモジュラー型アーキテクチャにより、迅速なイノベーションを支援する」とクラーク氏は説明する。

基調講演では、Broadcom、Meta、Microsoft、Hugging Faceからそれぞれの幹部が登場し、Dellとの取り組みについて語った。

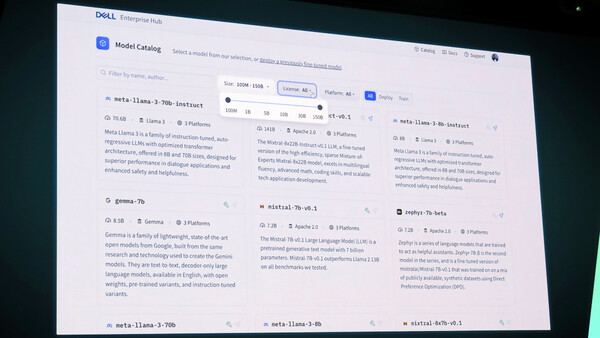

中でも、オープンソースのAIモデルリポジトリとして人気を集めているHugging Faceとの協業においては、Dell向けにカスタマイズされた「Dell Enterprise Hub」が発表されている。Hugging FaceがホスティングしているLLMのうち、Dellのインフラ向けに最適化されたものを容易にオンプレミス環境へ実装することができる、専用のコンテナやスクリプトも提供するという。オンプレミス向けに提供されるHugging Faceのポータルは初めてだという。

また、Metaとの間では、Metaの「Llama 3」モデルを「Dell PowerEdge XE9680」などのDellインフラでファインチューニングしたり実装したりすることを容易にすることに取り組むという。

クラーク氏は、今後のAI環境にまつわる、次のような予想を挙げた。

・2030年までに、生成AIに必要な処理速度は27 Quetta FLOPS(Quetta:クエッタ、10の30乗)になる。

・2026年には生成AI向けデータセンターの需要が従来型データセンターの需要を上回り、2030年には全体の75%を占めるようになる。

・コンピューティング需要の中心はトレーニングから推論へとシフトする。2030年までにトレーニングの需要が10%、残りが推論の需要となる。

・AIデータセンターは2030年までに390GW(ギガワット)を消費する。これに通常のデータセンターぶんの130GWを合わせると、合計では現在の8倍となる520GWの電力が必要となる。

・2030年までにすべてのPC(インストールベース)がAI PCになる。

基調講演では、DellのAIを活用している顧客として、McLaren RacingのCEO、ザック・ブラウン氏が登場。Formula 1レースにおけるAIの重要性について話した。

ブラウン氏によると、レースカーにはおよそ300のセンサーが搭載されており、レースが行われる週末にはそこから1.5TBものデータを収集し、5000万回のシミュレーションを行なっているという。

例えばタイヤの準備にかかる時間は20秒。ピットに入るタイミングを判断するのには2秒かかる。一刻を争うレースで無駄は許されず「一瞬で判断しなければならない」とブラウン氏は説明する。そこでシミュレーションが大切な役割を果たすという。

レースごとにシミュレーションと調整を繰り返すことでパフォーマンスが改善され、シーズンの開幕時と終盤では性能は大きく異なるという。McLaren Racingでは2026年に向けた取り組みを開始しており、「“最もAIが使われたレースカー”が出来上がるだろう」と述べた。

クラーク氏は、Dell AI Factoryのブループリントを見せながら、来場者に向かって「すぐに準備を始めるべきだ」と語り、基調講演を終えた。