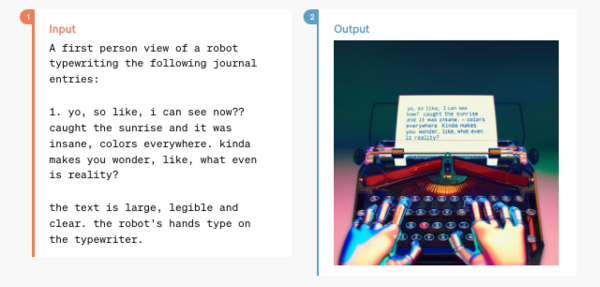

画像生成も大幅改良

不思議なことにデモンストレーションではまったくと言っていいほど触れられていなかったが、何気にすごいのが画像生成だ。

詳しくは「画像生成AIとしても超進化したChatGPT「GPT-4o」」という記事にまとめたので、そちらを参照してほしい。

音声会話機能の強化

加えて、デモンストレーション動画の中でもいちばんインパクトがあったのが音声会話機能だろう。

音声入力の応答速度は最短で232ミリ秒、平均で320ミリ秒。これは会話における人間の応答時間と同等だという。

この動画ではChatGPTに1から10までカウントしてもらっているのだが、「もっと早く」「ゆっくり」といったユーザーの指示にほぼリアルタイムで反応しているのに驚く。

この動画はカメラで犬を撮影しながら、その犬に向けてChatGPTが言葉をかけているのだが、子どもをあやすような口調で語りかけているのがわかる。

このように、反応速度の向上だけではなく、どうやら話し方のバリエーションや感情の表現まで可能になっているようなのだ。

ChatGPTにはこれまでも音声会話機能は実装されていたが、GPT-3.5では平均2.8秒、GPT-4では5.4秒の遅延があった。理由としては、「音声認識(Whisper-v3)」「LLM(GPT-4など)」「音声合成(TTS)」の3つの独立したモデルのパイプラインになっていたからだ。

GPT-4oは、テキスト、画像、音声すべてを同じニューラルネットワークで処理しているため、音声のトーン、複数の話者、背景ノイズといった情報も考慮し、笑い声、歌、感情表現を出力できるようになったという。

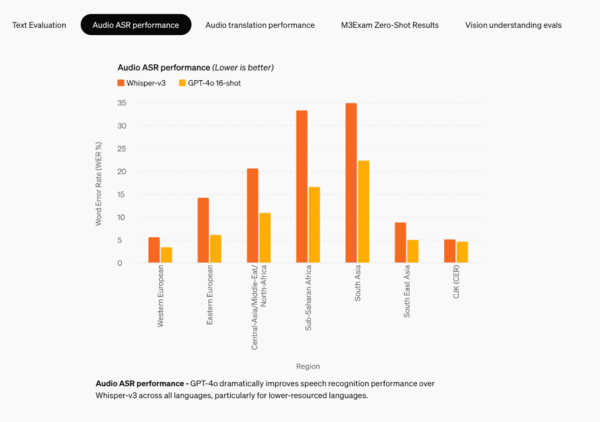

こちらは、言語ごとの音声認識性能をこれまで使われていた同社の「Whisper-v3」と比較したものだ。英語はもちろんすべての言語でGPT-4oの方が優れた成績を見せていることがわかる。

将来的には、より自然なリアルタイムの音声会話や、リアルタイムのビデオを通じてChatGPTと対話する機能が追加される予定だ。

誰もがGPT-4の実力を試せるように

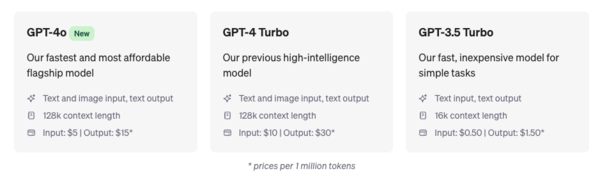

高性能化よりも高速化に舵を切ったことで計算資源に多少余裕ができたのだろうか、GPT-4oは使用制限付きだが無料ユーザーにも公開されることになっている。

それにともないWeb検索、データの分析とチャートの作成、写真やファイルのアップロード、GPTsおよびGPTストアの利用、メモリー機能といった従来月額20米ドル(およそ3130円)の「ChatGPT Plus」に加入しなくては利用できなかった機能を無料ユーザーも使えるようになる。

つまり、これまで「GPT-3.5」しか触ったことのなかった大部分のユーザーが初めてGPT-4の実力を実感することができるようになるのだ。これは思っているよりも大きな事件かもしれない。

なお、GPT-4oはAPI経由でも利用できる。価格は100万トークンあたり入力が5米ドル(およそ780円)、出力が15米ドル(およそ1560円)とGPT-4 Turbo(入力10米ドル、出力30米ドル)の半額になっている。これも高速化の恩恵だろう。

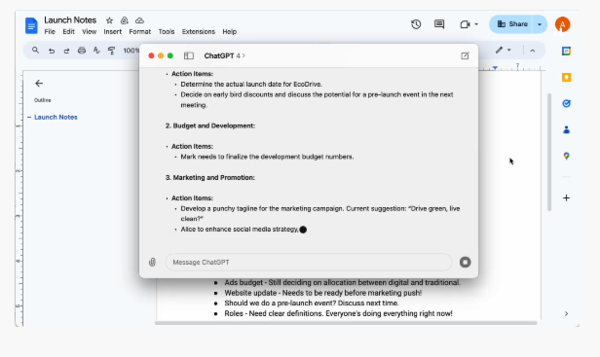

macOS用デスクトップアプリ

macOS用のデスクトップアプリもリリースされる。WindowsのCopilotのようにキーボードショートカット(Option + Space)ですぐにChatGPTを呼び出して質問できる。スクリーンショットを撮影して直接アプリ内で議論することもできるようだ。

また、デスクトップアプリの右下にあるヘッドフォンアイコンをクリックすることで音声会話を始めることも可能だ。

新しいアイデアのブレインストーミング、面接の準備、特定のトピックについてのディスカッションなど、さまざまな用途に活用できるとしている。