Tenstorrentは2021年1月、連載599回で解説した。ここから2年ほど経過し、順調に進んでいる部分もあるのだが、謎な方向への展開も見えてきた部分もあるので、今回はTenstorrentのアップデートをお送りしたい。

推論向けのJawbridgeとGrayskull

学習向けのWormholeとBlackhole

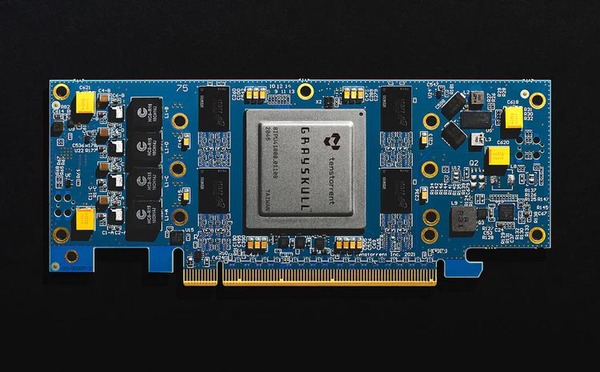

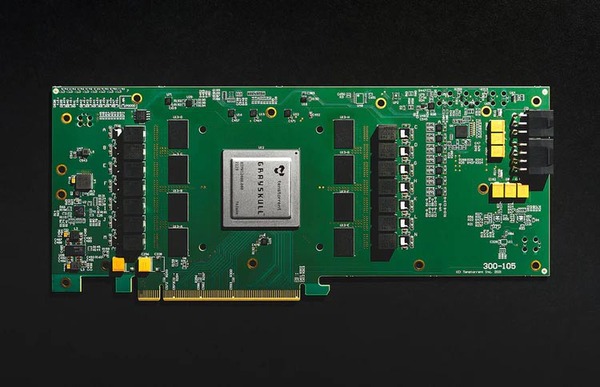

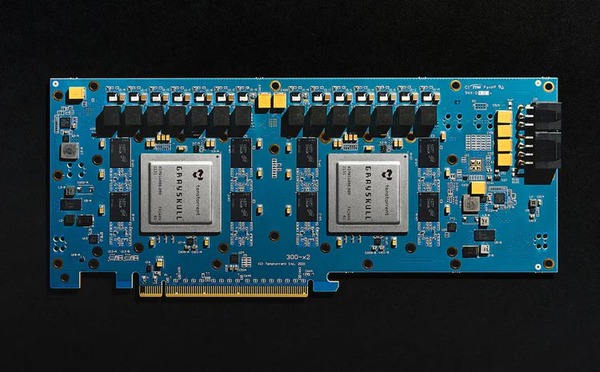

連載599回ではGrayskullについて説明したが、こちらはすでに量産に入っており広範に出荷されている。ボードにしても、ハーフサイズのe75と、長さ4分3のe150、e150と同じサイズのカードにGrayskullを2つ搭載したe300の3製品がラインナップされている。

もともとGlayskullが1.3GHzで368TOPSといった数字だったことを考えると、e75が900MHz動作、e150が1.3GHz動作、e300が1.1GHz動作×2といったあたりになっているのであろうと想像される。

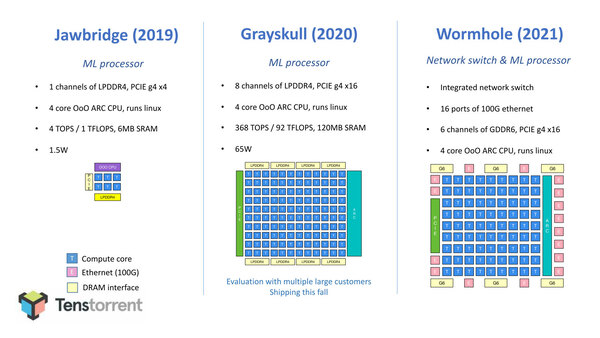

さて、これに続く話であるがGrayskull(とこれに先立つJawbridge)はAI推論向けであるが、その次のWormholeと、さらにその後に投入予定のBlackholeはAI学習向けとなっている。そのWormholeの詳細をまずは説明する。

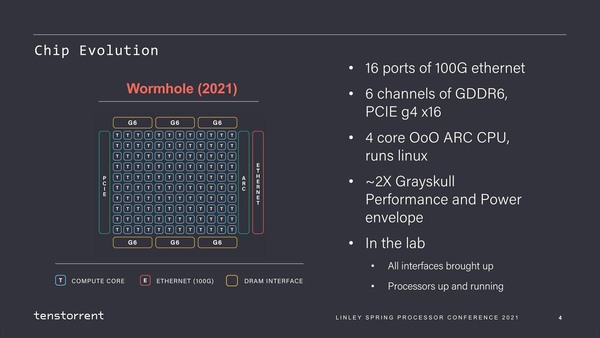

WormholeもGrayskull同様、TenstorrentのTensixコアをベースとした構成になっている。異なるのは全体の構成で、Grayskullは120個(12×10)のTensixコアに8chのLPDDR4 I/Fを組み合わせた構成だったのに対し、Whormholeは80個のTensixコアに6chのGDDR6を組み合わせ、さらに100GbE×16を搭載という、かなりI/O性能を高めた構成になっていることだ。

つまりチップ単体で言えば、WormholeはGrayskullよりも演算性能が低いことになる。これはどういうことか? というと、Wormholeは1チップでソリューションを構成するつもりが最初からない。

マルチチップ構成でAI学習に必要な演算性能を実現することを前提に、メモリーやインターコネクトのバランスを考えた結果が、Tensixコアの数をむしろ抑えるという結論である。

Wormholeは動作周波数も下がっているようで、性能/消費電力比がGrayskullの2倍になったとしている。ピーク性能を稼ぐ必要が薄いので、これは賢明な策だろう。ちなみにこの図ではTensixコアが120個になっているが実際は80個である

詳しい諸元はまだ公開されていないが、2021年当時だからGDDR6は16Gbpsあたりと想定すると、x32構成でチップ1個あたり64GB/秒ほど。6chで384GB/秒となり、Tensixコア1個あたり4.8GB/秒となる。Grayskullは120コアに対して100GB/秒だから、コアあたり1GB/秒未満の帯域でしかない。このあたりが、AI推論向けと学習向けの性格の違いを物語っている。

さて上の画像は2021年のLinley Spring Processor Conferenceのものだが、もう少し詳細な情報が2022年のISSCCで出てきている。以降の話はこれをベースに説明したい。

この連載の記事

-

第794回

デジタル

第5世代EPYCはMRDIMMをサポートしている? AMD CPUロードマップ -

第793回

PC

5nmの限界に早くもたどり着いてしまったWSE-3 Hot Chips 2024で注目を浴びたオモシロCPU -

第792回

PC

大型言語モデルに全振りしたSambaNovaのAIプロセッサーSC40L Hot Chips 2024で注目を浴びたオモシロCPU -

第791回

PC

妙に性能のバランスが悪いマイクロソフトのAI特化型チップMaia 100 Hot Chips 2024で注目を浴びたオモシロCPU -

第790回

PC

AI推論用アクセラレーターを搭載するIBMのTelum II Hot Chips 2024で注目を浴びたオモシロCPU -

第789回

PC

切り捨てられた部門が再始動して作り上げたAmpereOne Hot Chips 2024で注目を浴びたオモシロCPU -

第788回

PC

Meteor Lakeを凌駕する性能のQualcomm「Oryon」 Hot Chips 2024で注目を浴びたオモシロCPU -

第787回

PC

いまだに解決しないRaptor Lake故障問題の現状 インテル CPUロードマップ -

第786回

PC

Xeon 6は倍速通信できるMRDIMMとCXL 2.0をサポート、Gaudi 3は価格が判明 インテル CPUロードマップ -

第785回

PC

Xeon 6のIOチップレットには意地でもDDR5のI/Fを搭載しないインテルの強いこだわり インテル CPUロードマップ -

第784回

PC

Intel 3は300~500MHz動作周波数が向上する インテル CPUロードマップ - この連載の一覧へ