遠隔触診を実現するAI。デジタル空間を介する遠隔触診ならではの利点とは

【2月16日、17日開催】NEDO「AI NEXT FORUM 2023」で展示される最新AI技術(7)

本特集では、2月16日・17日に開催されるNEDO「AI NEXT FORUM 2023」でも展示される、社会実装に向けた最前線のAI技術を、全10回にわたって紹介する。第7回は遠隔診療、それも遠隔での「触診」に向けたAI技術開発だ。

NEDO「人工知能活用による革新的リモート技術開発」プロジェクト

「Contact Realityの実現による遠隔触診システム開発」

医師は触診で自らの記憶を想起させる

理研の下田真吾氏らは「Contact Realityの実現による遠隔触診システムの開発」に取り組んでいる。以前、下田氏らは5G/IoT時代を見据えて「遠隔リハビリ」研究に取り組んでいた。リハビリや健診は医師と患者のコミュニケーションでもある。「そのため、最初は遠隔には向かないかもしれないとも考えていましたが、そこそこできそうだなというところまで作ることができました」(下田氏)

遠隔リハビリでの課題は、触れないことにある。つまり、「触診ができない」ことだ。これは、医師の診断にとっては一定の障壁なのだという。医師は触診をすることで、自分のなかで患者の状態について確信を得るからだ。ならば、「遠隔触診」を実現できないか? 下田氏らは実現を検討するために、医師が触診で実際には何をしているのかを調べることから取り組み始めた。

医師は触診で、単に硬さや熱などを見ているわけではないと下田氏は語る。「それよりも医師は触りながらコミュニケーションしたり、触ることで自分の過去の記憶を想起させたりするんですね。それが、触診の重要な役割だということがわかってきました」

検査結果や問診などから、患者の状態のおおよそ8割程度は推測がつく。医師は残りの2割を触診で埋める。自分のなかで確信を得るために触る、そういうイメージだという。「過去の記憶を引き出して内面的な確信を持つために触る」、つまり触ることで最終確認をしているのだ。

いっぽう患者側は、医師に触られることで、医師との信頼関係が生まれることがよく知られている。医師が触診した場合としない場合で患者の信頼度が違うのだ。しかし、これがどういうプロセスによるのかはよくわかっていなかった。

下田氏は遠隔触診するシステムをつくる上で「単にリアルな物理量をそのまま伝えるのではなく、患者との信頼関係を実現できるシステムを作っていかないといけないということが最初の目標にありました」と語る。そこで「リアルではなくリアリティ」を伝えるべきではないかと考えたという。

「あたかも『患者がそこにいる』という感覚そのものを医師に伝えるというリアルを追求すると、(通信による)時間の遅延もあるので、逆に絶対にリアルには届かない。それよりも信頼や確信がうまく築けるシステム、『リアリティ』が得られる触診システムを作ろうということが出発点でした」(下田氏)

触診の認知経路

下田氏らは、「触覚」が人にとってどんなセンサなのかを理解することが第一だと考えた。なぜ医師は触診によって過去の記憶を整理でき、患者は医師に対して信頼を持つことができるのか。まずそこからスタートした。

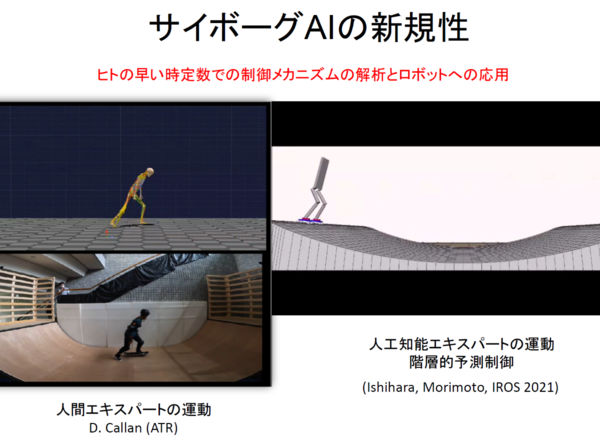

医師は自分のペースで触り、患者は触られる。自分から触ることを「アクティブタッチ」という。触覚においては、自分で触りにいく自らの動きと触覚が一致すると過去の体験の想起に繋がる。つまり「自分がそこにいて触っている」という感覚が非常に重要な感覚を生み出している。

いっぽう、患者は触られることで情動が活性化する。医師に触ってもらいながら診察を受けると情動変化が起きるのだ。「医師との会話のなかで『こういう病状だよ』と言われることで強い信頼関係が生まれる。触診の認知経路は、そういうプロセスで成り立っているのだろうと考えました」(下田氏)

デジタル空間を介する遠隔触診ならではの利点

では必要なものは何か。違和感なく患者に触れた感覚を得ながら適切にコミュニケーションを取れることだ。触った情報量が多少正確でなくても、患者に触れている違和感を生まないほうが、正しい診断に貢献する可能性が高い。

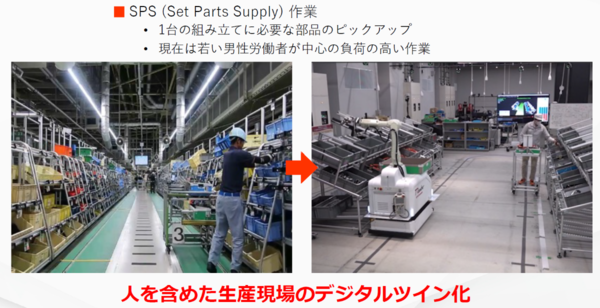

さらにデジタル空間を介す利点も加えた。「触るだけで、超音波エコーで見ているように内部状態が見えてしまえば、より直感的に理解できるようになって触診の利点は増える。身体全体の温度分布は診察室でも見られるが、サーモグラフィで腕全体の温度がわかると、もしかしたら新しい発見もあるかもしれない」。また神経麻痺が起きている状態は経験を積んだ医師でないとわからない。ロボットを介することでそこを強調提示できれば、経験が浅い医師でもわかるようになるかもしれない。

患者側は、医師に触ってもらいながら「きちんと診察されている」という感覚を得ることが重要だ。そのためには錯覚を利用して医師が自分を触っているという感覚が得られるようにする。

たとえば手首が痛いとき、一般の患者は正確にどこが痛いのかはわからない。いっぽう医師は経験と解剖学的知識があるので、炎症を起こしている部位を推測できる。また、医師が「ここを押してこう曲げると痛いでしょ?」と伝えられれば「この医師は自分のことをわかってくれた」というプロセスを経ることができる。

また「この腱が炎症を起こしている」と言っても普通の人にはわかりにくい。そこでモーションキャプチャーを使って仮想空間に腕を再現。仮想空間で腕の皮を剥がして中身を見せて「ここが痛んでいるので、こういうふうにストレッチして炎症を抑えましょう」というコミュニケーションをとることができれば、患者の理解度も上げられる。

遠隔触診のシステム

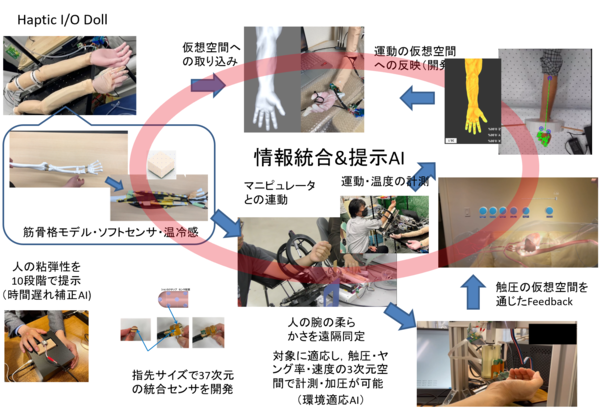

では、どうやって触診の流れを作るか。何もない空間を触って感覚を得ることは不可能なので、医師は「ハプティック I/O ドール」と名付けられたダミーを触る。遠隔地ではロボットが医師の感覚を伝える。

触覚は時間のズレに敏感だ。0.1秒でも遅れると違和感がある。しかし、取得した物理量を感覚として遠隔地からフィードバックさせるのは難しい。そこで実際には、触る感覚をある程度予測して提示することにした。いっぽう視聴覚はアクションに対する時間遅れにロバストなので、そのままの情報を提示する。それによって医師は状況を的確に把握できるという。患者側では、患者にうまく合わせつつ医師の意図を反映できるようにロボットが動作する。かつ、VRも使って直感的理解を促す。

人の認知にAIでインターフェースを取る

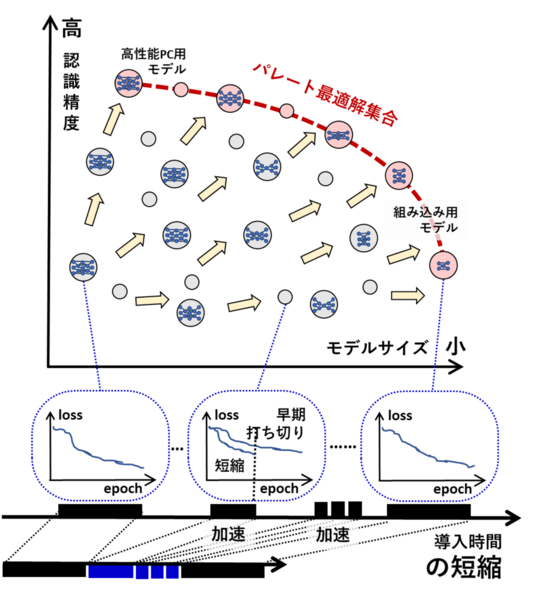

時間遅れの補正にはAIを用いる。肌の「かさかさ感」や「しっとり感」は主に振動の提示で伝達する。例えば「触る0.05秒前に100kHzの振動を与えると粘性の高い物体と感じる」といった情報が学習の対象になる。

情報の組み合わせ方を決める「情報統合提示AI」も開発する。医師にとってどういう組み合わせで情報が提示されるとわかりやすいかを学習させている。「環境適応AI」は患者に合わせるためのAIで、医師の意図を患者の状態に合わせて適応的に実行する。

「人の認知機能はどうなっているのか。それを前提にAIを組まないといけません。今までの機械学習は『こういう画像はガン』といったかたちで事実と事実を組み合わせている。それが基本です。その先に人の認知、知覚を入れていくというのが非常にチャレンジングな課題で、これまでにない部分です。人は、自分がどう感じるかは自分でもよくわかっていませんから」(下田氏)

医師たちも、自分たち自身が触診で実際に何を感じているのかはわかっていない。だが触ると「こういう病気だとわかる」。「人の認知にAIでインターフェースを取ることは大いなるチャレンジ」だという。

「ハプティック I/O ドール」

そのほか、ダミーの「ハプティック I/O ドール」の開発、提示システム、患者に触るロボット、さらに医師の脳波を計測することで実際に触診できているのか、気づきがあるのかを計測・評価するためのシステムなども開発している。

「ハプティック I/O ドール」は、まずは前腕に絞って開発している。前腕の骨の特性を再現できるよう、腕を動かしたときに骨が回旋する動きが実際の腕と同じになるように作っており、そこに実際の筋肉と同等のアクチュエータ、温冷感のセンシングができるようにしたものを作り込んだ。「人の腕っぽいものを実現できた」という。

特徴は豊田合成が開発したアクチュエータ機能とセンサ機能を兼ね備えた「e-Rubber(イー・ラバー)」を採用している点。人の肌感に近い柔らかさと特性をもったアクチュエータで、粘弾性を10段階で提示できる。これにより「高齢者とスポーツマンの体の違いを提示できる」という。「人の肌を触った感覚」が得られるのだ。

さらに、動きを仮想空間上に取り込んで、医者が触ると仮想空間のアバターの腕が凹み、同時に遠隔地のロボットが動いて同じ部分を触るといったことも実現できている。医師に返る情報は触覚だけではなく、「グニュ」という音を出したり、見た目の変化も合わせる。ゲームのような演出を行うことでリアリティを伝える。

通信変動にも対応

また通信量に応じて送るべき情報をうまく取捨選択することも重要だという。ただ人の感覚はそれほど分解能が高いわけではないし、あくまで理解して判断する助けになれば良いので、通信量自体はそれほどはいらないと考えている。「そのままの情報が伝わってこなくても、ポイントさえ押さえれば、うまく判断できる特性が人にはある。速さよりもアイデアで作り込む部分が大きいのかなと思います」(下田氏)。

さらに37次元の計測が可能なセンサを開発。それで人の腕を触ると柔らかさがわかるシステム構成とした。患者側にリアリティを持たせるために患者自身の動きも取り込んで仮想空間でも動かせるようにしようとしている。仮想空間の腕が自分の腕と同じように動けば「触られた」という感覚を得ることができる。そこにさらに温度変化情報などを載せられれば、医師もより深い情報がわかる。

触覚は「認知の活性化」に繋がる

今後の応用については、手の関節の炎症の一つ「手根管症候群」を対象に進める。手根管症候群の初期は痺れている程度で介入も容易だが、軽症では病院に行かない人がほとんどだ。しかし、ある程度進行してしまうと治すのが大変になる。そこで気軽に診察を受けることができるようになれば早期介入が容易になり、医療費の削減にも繋げられる可能性がある。

神経麻痺の同定も目指す。手のひらの一部に麻痺が起きると、そこだけ汗をかかなくなる。医師は丁寧に触ることで、どこからどこまで汗をかいているか、かいてないか境目を見つける。これには経験が必要だ。実際の情報をデジタルで残せば有用だ。指先統合センサを使うことで正確な同定も可能なのではないかという。

また、この考え方の延長で、オンラインでのやりとりをしているときに臨場感を伝えるために国際会議で風船を介して心拍を触覚で与えると、面白いことがわかったという。「心拍云々という感想ではなく、『この人は緊張していたことがよくわかった』とか、触覚そのものではない感想が出てきました」。

触覚は認知そのものよりも「認知の活性化」に繋がる、今後のリモート技術の基盤として活用できるのではないか、そういう方向に応用範囲が広げられればいいのではないかと考えているという。たとえばアイドルファン向けにライブDVDを心拍情報付きで販売して再生できるようになれば、ファンはとても楽しい感覚を得られるのかもしれない。

人の認知・感覚をうまく利用する

遠隔触診のシステムはほぼ組み上がってきた。今後は患者を対象に実証試験を行なっていく。遠隔触診に求められるものは大きい。ただ、まだ技術的には確立していない。医療は保守的な分野だ。確立しないものは広くは使われない。

いっぽう、世界には日本以上に医師が物理的にいない環境は多い。海外などでも使われる可能性はある。ただ、手だけならまだ小型システムですむが、全身となるとシステム全体が大きくなる。対象部位を広げると、遠隔のロボットも含めて、どうやって遠隔の診察デバイスを作るのかは課題だ。

人はおそらく無意識のうちに様々な情報を感じている。重要なことは「人の認知をうまく利用する」ことだと下田氏は語る。「受容感覚には外受容感覚と内受容感覚があって、肌の下には内部の状態を受容するセンサが埋めこまれています。それを適切に刺激すれば、うまく状況をとらえることができるのです」

開催概要

名称:AI NEXT FORUM 2023-ビジネスとAI最新技術が出会う、新たなイノベーションが芽生える-

日時:2023年2月16日(木)、17日(金)10時00分~17時00分

場所:ベルサール御成門タワー「4Fホール」(〒105-0011 東京都港区芝公園1-1-1 住友不動産御成門タワー4F)

アクセス:都営三田線 御成門駅 A3b出口直結、都営大江戸線・浅草線 大門駅 A6出口徒歩6分、JR浜松町駅 北口徒歩10分、東京モノレール 浜松町駅 北口徒歩11分

参加:無料(事前登録制)

内容:AI技術に関する研究成果を実機やポスター展示などにより対面形式で解説(出展数:最大44件)、各種講演やトークセッションを実施(会場参加とオンライン配信のハイブリッド形式)

主催:国立研究開発法人新エネルギー・産業技術総合開発機構

運営委託先:株式会社角川アスキー総合研究所