Yahoo! JAPANと慶應義塾大学、東京工科大学が連携し、スマートフォンの持ち方などをカメラで推定する手法を開発

ヤフー株式会社

~ 角膜反射像を機械学習で分類することで、スマートフォンをどの手で持ち、どの指で操作しているかを推定 ~~ アプリの操作性向上や、長時間同じ姿勢で操作することに起因する疾患の予防に応用できる可能性も ~

ヤフー株式会社と慶應義塾大学、東京工科大学は、スマートフォンのフロントカメラ(インカメラ)で撮影された顔写真を使用し、角膜反射像(※1)を機械学習で分類することで、スマートフォンの持ち方などを推定する新しい手法(以下、本手法)を開発しました。

本手法は、ヤフー株式会社 Yahoo! JAPAN研究所 池松香 上席研究員、慶應義塾大学 理工学部 杉浦裕太 准教授、慶應義塾大学大学院 理工学研究科大学院生 張翔、東京工科大学 メディア学部 加藤邦拓 助教の研究グループ(以下、「本グループ」)により開発されました。

多くのスマートフォン用アプリでは、右手親指での操作を前提に画面表示が設計されており、スマートフォンの大画面化が進む昨今においては操作しづらい場合があります。また、既存の「把持姿勢(※2)」を推定した研究では、新たにセンサーを用意する必要があったり、スマートフォンの機種の違いによって結果に影響が出たりするといった課題がありました。

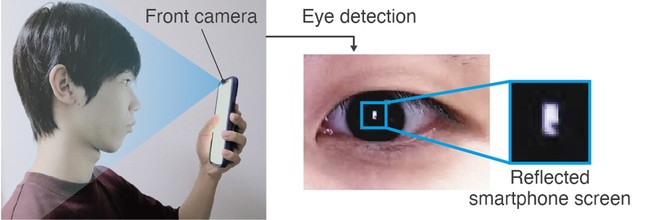

本グループは、スマートフォンを操作する際に画面の光が角膜に反射することで画面の形をした角膜反射像が映り、それが「把持姿勢」に応じて異なることに着目しました。そこで、スマートフォンのフロントカメラで顔写真を撮影し、顔写真から角膜反射像を切り取り、機械学習を使って角膜反射像を分類することで「把持姿勢」を推定する本手法を開発しました。

さらに、本手法は、スマートフォンに内蔵されたフロントカメラを使用するため、さまざまな機種のスマートフォンに適用でき、容易にアプリに組み込むことができます。アプリ内で「把持姿勢」を推定することで、ユーザーの利用状況に合わせた画面表示の最適化や、操作ボタンやキーボード位置の自動切り替えが可能になり、操作性の向上につながります。また、スマートフォンを長時間同じ姿勢で操作している際にアラートを表示することで、それに起因する疾患の予防に応用できる可能性があります。

今後は、より大規模かつ実環境に近い状態での実験を行うほか、スマートフォンに内蔵されているカメラ以外のセンサーを併用したり、推定アルゴリズムを改善したりすることで、より高い精度で安定して「把持姿勢」を推定することを目指します。

※1:角膜の表面に外部の光が反射して映る像

※2:人が物体をつかむ際の手の位置・姿勢

【研究内容 詳細】

スマートフォンの画面は光を発するため、顔の正面の位置にスマートフォンを持つと画面の形をした角膜反射像(図1)が映りますが、画面上に指を置いている部分は影となり、その部分のみ角膜反射像が欠けます。「把持姿勢」に応じて角膜反射像の欠け方が異なるため、スマートフォンのフロントカメラで顔写真を撮影し、顔写真から瞳に映る角膜反射像を切り取り、機械学習を使って角膜反射像を分類することで「把持姿勢」を推定することが可能であると考えました。スマートフォンに内蔵されているフロントカメラを使用するため、新たにセンサーなどを外付けする必要が無く、スマートフォンの機種が変わってもより正確に「把持姿勢」を推定できるというメリットがあります。

今回は、実験協力者13名を対象に、6種類の「把持姿勢」(図2)で、それぞれスマートフォンを持った状態でフロントカメラを使って顔写真を撮影し、その画像を使用して「把持姿勢」の識別が可能か検証しました。深層学習を用いて検証を行った結果、85%の精度で「把持姿勢」を識別することができました。

本研究成果は2022年5月4日(米国東部夏時間)、国際学会「CHI'22: ACM CHI Conference on Human Factors in Computing Systems」にて発表されます。

図1 瞳に映る角膜反射像

スマートフォンを顔の正面の位置で持った際、「把持姿勢」に応じた角膜反射像が瞳に映ります

図2 6種類の「把持姿勢」

本研究では、6種類の典型的なスマートフォンの「把持姿勢」を対象にして実験を行いました。

<原論文情報>

Xiang Zhang, Kaori Ikematsu, Kunihiro Kato, and Yuta Sugiura. ReflecTouch: Detecting Grasp Posture of Smartphone Using Corneal Reflection Images (角膜反射像を利用したスマートフォンの把持姿勢推定). In Proceedings of the 2022 CHI Conference on Human Factors in Computing Systems (CHI 2022).

doi: 10.1145/3491102.3517440