さっそく生成してみよう

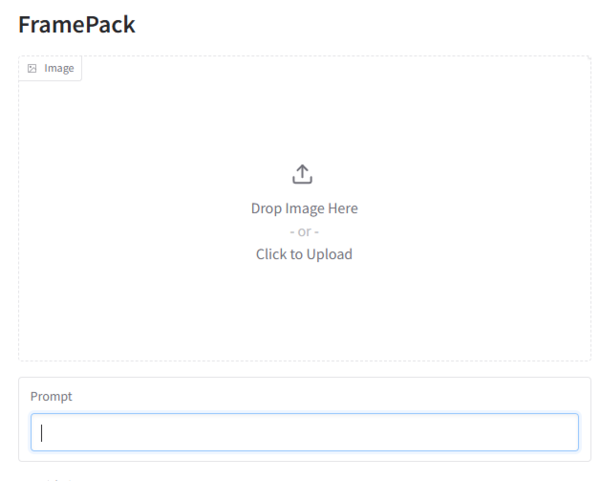

インストールだけではなく使い方も実に簡単だ。基本は画面左上の「Image」エリアに開始フレームとなる画像を配置し、動きを指示するプロンプトを記述するだけだ。

なお、現在は「image 2 video」のみ対応しており「text 2 video」には対応していないので必ず開始画像が必要となる。

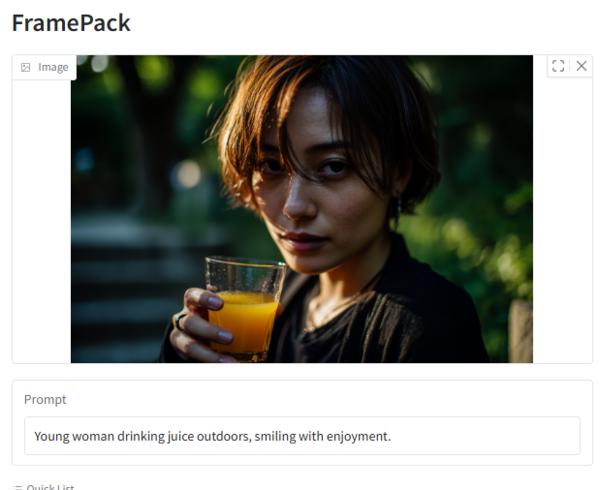

開始フレームにMidjourneyで作成した画像を配置。プロンプトは以下にしてみた。

プロンプト:Young woman drinking juice outdoors, smiling with enjoyment.

設定項目がいろいろ用意されているが今回はすべてデフォルトで試した。なお「Total Video Length(Second)」で動画の秒数(デフォルト5秒、最大120秒!)を変更できる。

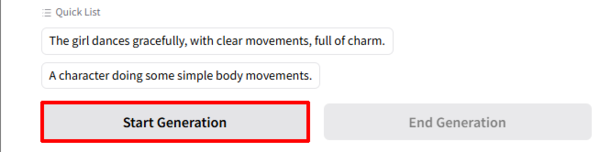

「Start Generation」ボタンをクリックすると生成がスタートする。

なお、「Quick List」にはサンプルのプロンプトが表示されており、クリックすることで使用できる。

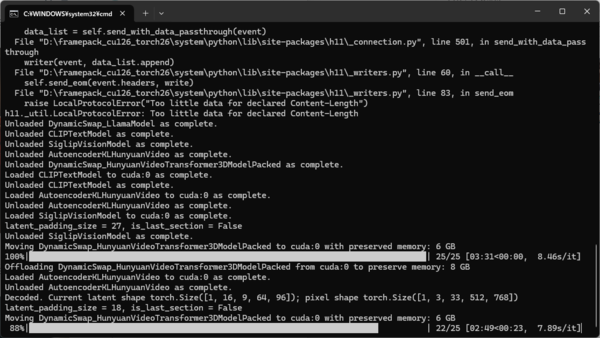

初回生成時には約30GBの推論に使うAIモデルをダウンロードするためスタートするまで少し時間がかかる。

生成中はこのように完成したところまでの動画がループ再生される。動画の後半(最後のフレーム)から逆算して生成しているのがよくわかる。

— kazuhiro taguchi (@tagkaz) April 21, 2025

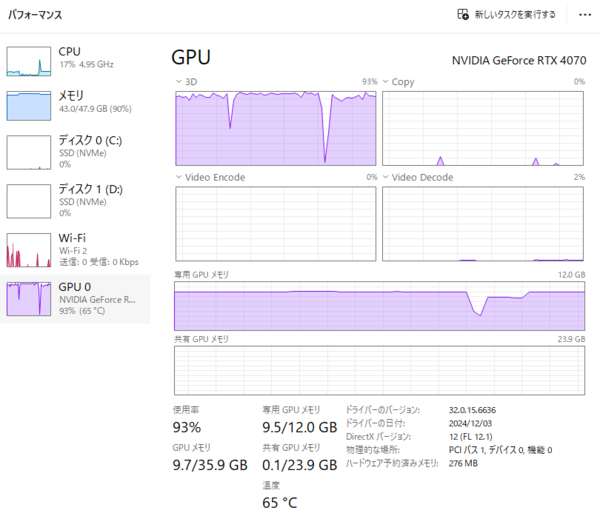

パフォーマンスモニターを見ると、メインメモリー、ビデオメモリー共にかなりの消費だが問題なく動いてはいる。

約19分後、最初の動画が完成した。かなりいい感じではないだろうか。

FramePack pic.twitter.com/g5uxlY6Kch

— kazuhiro taguchi (@tagkaz) April 20, 2025

別の開始フレームでも試してみよう。なお、今回の画像はことわりがない場合すべて最近アップデートされたMidjourney V7で生成している。

プロンプト:Young woman notices us and waves her hand.

約12分で完成。こちらもかなりいい出来だ。手指も破綻していない。

Framepack pic.twitter.com/sA8A0Xcgz7

— kazuhiro taguchi (@tagkaz) April 21, 2025

アニメ風イラストでも試してみよう。こちらは「Total Video Length(Second)」を「10秒」に設定している。

プロンプト:The girl dances gracefully, with clear movements, full of charm.

カバンが両肩にかかっているのはご愛嬌。後半帳尻合わせのためか動きが早くなるのが少し気になる。

— kazuhiro taguchi (@tagkaz) April 21, 2025

この連載の記事

-

第40回

AI

Suno級がローカルで? 音楽生成AI「ACE-Step 1.5」を本気で検証 -

第39回

AI

欲しい映像素材が簡単に作れる! グーグル動画生成AI「Veo 3.1」の使い方 -

第38回

AI

最新の画像生成AIは“編集”がすごい! Nano Banana、Adobe、Canva、ローカルAIの違いを比べた -

第37回

AI

画像生成AIで比較!ChatGPT、Gemini、Grokどれを選ぶ?得意分野と使い分け【作例大量・2025年最新版】 -

第36回

AI

【無料で軽くて高品質】画像生成AI「Z-Image Turbo」が話題。SDXLとの違いは? -

第35回

AI

ここがヤバい!「Nano Banana Pro」画像編集AIのステージを引き上げた6つの進化点 -

第34回

AI

無料で始める画像生成AI 人気モデルとツールまとめ【2025年11月最新版】 -

第33回

AI

初心者でも簡単!「Sora 2」で“プロ級動画”を作るコツ -

第32回

AI

【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ -

第31回

AI

“残念じゃない美少女イラスト”ができた! お絵描きAIツール4選【アニメ絵にも対応】 -

第30回

AI

画像生成AI「Midjourney」動画生成のやり方は超簡単! - この連載の一覧へ