数学推論とマルチタスクに特化した超小型LLM「QwQ-32B-Distill-Qwen-1.5B-Alpha」をオープンモデルで公開

Axcxept株式会社

~バークレー大発「DeepScaler」、アリババクラウド「QwQ-32B」から着想を得て小型モデルのさらなる特化性能向上に成功~

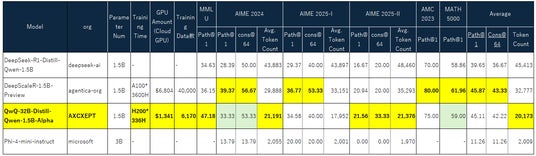

Axcxept株式会社は本日、Multitask 性能と数学推論性能を、わずか2日間の強化学習で、飽和状態だった性能をさらに向上させた超小型言語モデル(LLM)『QwQ-32B-Distill-Qwen-1.5B-Alpha』をオープンソースで公開しました。本モデルは、deepseek-aiの長考モデル、DeepSeek-R1、米国バークレー大学発の研究DeepScalerプロジェクトおよび、アリババクラウドのQwQ-32Bからインスピレーションを得ており、コストを抑えつつ高い推論性能を実現しています。

QwQ-32B-Distill-Qwen-1.5B-Alpha Image

Axcxept株式会社はこれまで、日本語特化型および金融・セキュリティ分野に特化したLLM開発を進め、オープンモデルの公開及び、多くの企業・研究機関とともに、研究支援提供してきました。このたび新たに開発した『QwQ-32B-Distill-Qwen-1.5B-Alpha』は、長考型の最先端LLM『DeepSeek』の知見を取り入れ、バークレー大学の高性能モデル『DeepScaler』、およびアリババクラウドの大規模推論モデル『QwQ-32B』から着想を得つつ、1.5Bという超小型サイズに蒸留した革新的なモデルです。これらは、素晴らしい先行のベースモデルや蒸留元モデル、先行研究の存在があり、そのうえで、弊社の小型かつ、低コストで、性能向上を実現するというアイデアを、実現することに成功いたしました。