「自己回帰モデル」の採用で描写が正確に

なぜこんなことができるようになったのか。それは4o Image Generatorが採用した「自己回帰モデル(Autoregressive model)」によって構築されているためのようです。

自己回帰モデルとは、LLMなどに使われる技術で画像を生成するアプローチです。テキスト情報を受け取り、翻訳するように画像トークンを組み立てていく。LLMは、生成途中のテキストを、次にどうなるかを1つずつ確率的に予測していくことで、連続した文章を生み出します。この方法論を、画像生成AIに応用したモデルです。

画像生成AI「Stable Diffusion」に代表される「拡散モデル」は、画像にノイズを加えていき、そのノイズを逆のプロセスで戻すことで画像を生成するというものでした。反復的にノイズを取り除くことで、精緻な画像を生み出していくという方式です。

2021年にOpenAIが開発した「DALL·E (初代)」も、自己回帰モデルを採用していました。32x32に分割されて生成されるイメージを統合し、252x252ピクセルのイメージを生成するという仕組みでした。しかし、細部の画質や高精細さが後発モデルに及ばなかったこともあり、その後の開発は拡散モデルに切り替えたようです。それから4年が経ち、OpenAIは、再び、自己回帰モデルを組み込んできた格好です。

自己回帰モデルの弱点は、拡張モデルのようにノイズから一気に全体を生成するというアプローチではなく、逐次処理であるため、生成時間がかかるという弱点があります。OpenAIからは技術的な仕組みを公開していませんが、断片的な情報から、AI企業のグレッグ・ロビンソン氏は、2段階による処理で、速度の問題に対応していると推測しています(Tokens Not Noise: How GPT-4o’s Approach Changes Everything About AI Art)。

具体的には、画像生成時、前半を自己回帰モデルによって抽象レベルで表現して、生成に必要なデータを数百〜数千分の1に縮小。後半に拡散モデルを利用することで、生成速度を上げるというアプローチではないかとみています。また、この仕組みは「LLMの開発を通じて洗練されたスケーリング技術(大量のパラメーター、特殊なアテンションメカニズム、多様で高品質なデータセットのトレーニング)の恩恵を受けています。これらはすべて複雑な視覚的関係をとらえるのに役立ちます」(ロビンソン氏)。

一気に画像全体を生成する拡散モデルにとって、「画像の中にテキストを書く」といったタスクは難題だったのですが、自己回帰モデルは逐次処理であり、LLMの学習効果もあるため、この問題を乗り越えていると考えられています。

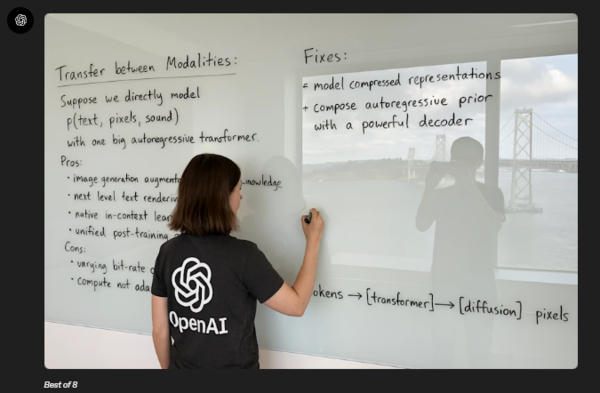

GTP-4oのコンセプトをホワイトボードに書き出しているところ。この画像自体がプロンプトによって4oにより生成されたもの。プロンプトは公開されている(OpenAIのページより)

OpenAIはGPT-4oのコンセプトを、「テキスト、画像、音声など複数モーダルを1つの大きな自己回帰トランスフォーマーで直接モデル化する」ことだと挙げています。

モーダルとは情報の種類や感覚の形式のことを指し、従来はチャットでは1モーダル(テキスト)のみしか扱えなかったものが、入力情報を区別なく受け取れて、出力もまたテキスト、画像、音声やその組み合わせを自由に出力できるマルチモーダル化を実現しているというわけです。これは、ユーザーにとっては、普段のチャット同じように画像も扱うことができて、柔軟な描写も実現しやすくなることを意味します。

この連載の記事

-

第145回

AI

ComfyUI、画像生成AI「Anima」共同開発 アニメ系モデルで“SDXL超え”狙う -

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る -

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 - この連載の一覧へ