動画生成AIはさらに爆発的な発展へ

Wan 2.1は応用の範囲が非常に広いことを示し始めています。2023年7月に発表された「AnimateDiff」は、16コマ2秒の動画を、わずかにしか動かすことができない技術でした(参考:アニメの常識、画像生成AIが変える可能性「AnimateDiff」のすごい進化)。しかし、それから20ヵ月で、現実のアニメーション制作の動画過程を補える可能性が出てきています。VRAMの容量内に収めるためには、生成できる動画は5秒と限界を抱えてはいるのですが、着実に課題を乗り越えています。

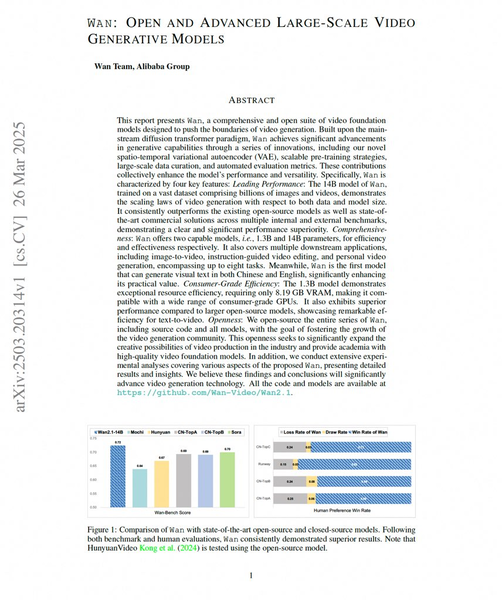

Wanの技術レポート(arxivのリンク)

3月28日に公開されたWan 2.1のテクニカルレポートでは、開発の背景として3つの課題が挙げられています。1つ目は、商用モデルに比べて性能が不十分であること。2つ目は、多くのオープンモデルがt2v(テキストから動画生成)にとどまり、ビデオ制作のニーズに十分応えられていないという機能面の制約。3つ目は、大規模なモデルがあまりに重く、限られた計算リソースしか持たない制作チームには扱いが難しいという効率面の課題です。Wan 2.1は、これらの課題を解決することを目指して開発されたといいます。

Wan 2.1は、Stable Diffusionの登場以来使われてきた「拡散モデル」を拡張して、時間軸の情報も含めて学習させる方法論を発展させてきたと説明されています。その中核となるテクノロジーは、オープンソースコミュニティから登場してきたものであるとしています。

そして、何十億もの動画と画像を収集し、そこから様々な評価をして、高品質で多様性のある数百万種からなるデータセットを作成し、学習をしたようです。一方で、結論として、「大きな動きがあるシーンでの細部の制御が難しい」ことを課題としてあげています。また、14Bモデルのサイズでは生成に時間がかかるという課題もあげており、「動画生成を民主化し、高度なAIツールをより幅広く利用可能にするためには、最新かつ最適化された実装をオープンソース化するなどして、この制約に対処する取り組みが欠かせません」とも述べており、オープン化を通じた技術開発の加速化は必須としています。

コミュニティーが技術革新を引っ張るようになると、企業単独のサービスでは思いつかなかったような使われ方が発見されることもあります。Stable Diffusionが爆発したたように、動画AIの世界でも、Wan 2.1の登場により、予想もされなかったような技術発展の登場が期待できます。

この連載の記事

-

第147回

AI

ゲーム開発開始から3年、AIは“必須”になった──Steam新作「Exelio」の舞台裏 -

第146回

AI

ローカル音楽生成AIの新定番? ACE-Step 1.5はSuno連携で化ける -

第145回

AI

ComfyUI、画像生成AI「Anima」共同開発 アニメ系モデルで“SDXL超え”狙う -

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” - この連載の一覧へ