Stable Diffusion入門 from Thailand 第24回

インストール方法、使い方も解説

SD3.0の汚名返上なるか?!画像生成AI「Stable Diffusion 3.5」を試してみた

2024年11月06日 13時00分更新

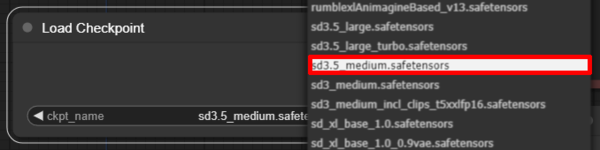

Stable Diffusion 3.5 Medium

次に10月29日に公開された最新モデル「Stable Diffusion 3.5 Medium」を試してみよう。Largeで使用したワークフローをそのまま利用できるので、やることは「Load Checkpoint」ノードでモデルをLargeからMediumに変更するだけだ。

初回は16秒、2回目以降は11秒程度で生成される。生成された画像に関しては書き込み密度が少し減ってはいるものの質感やクオリティに遜色はない。

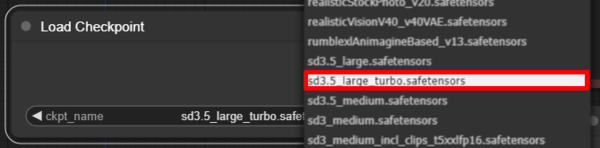

Stable Diffusion 3.5 Large Turbo

最後に高速モデルの「Stable Diffusion 3.5 Large Turbo」を試してみよう。こちらも同じワークフローを利用、モデルをMediumからLarge Turboに変更しよう。

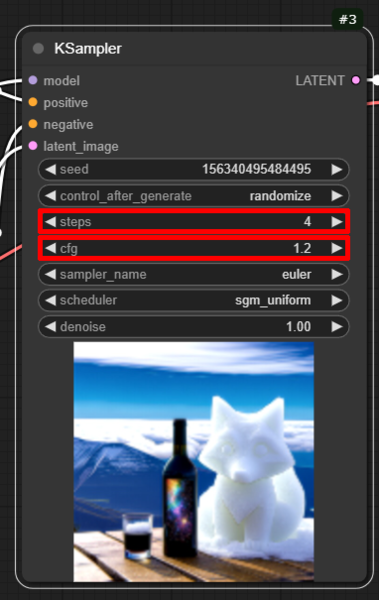

ただしLarge Turboの場合「KSampler」ノードで、「steps」を「20」から「4」へ、「cfg」を「5.5」から「1.2」にそれぞれ変更する必要がある。

生成された画像。初回は30秒かかったが、2回目以降は10秒以下で生成された。

この連載の記事

-

第40回

AI

Suno級がローカルで? 音楽生成AI「ACE-Step 1.5」を本気で検証 -

第39回

AI

欲しい映像素材が簡単に作れる! グーグル動画生成AI「Veo 3.1」の使い方 -

第38回

AI

最新の画像生成AIは“編集”がすごい! Nano Banana、Adobe、Canva、ローカルAIの違いを比べた -

第37回

AI

画像生成AIで比較!ChatGPT、Gemini、Grokどれを選ぶ?得意分野と使い分け【作例大量・2025年最新版】 -

第36回

AI

【無料で軽くて高品質】画像生成AI「Z-Image Turbo」が話題。SDXLとの違いは? -

第35回

AI

ここがヤバい!「Nano Banana Pro」画像編集AIのステージを引き上げた6つの進化点 -

第34回

AI

無料で始める画像生成AI 人気モデルとツールまとめ【2025年11月最新版】 -

第33回

AI

初心者でも簡単!「Sora 2」で“プロ級動画”を作るコツ -

第32回

AI

【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ -

第31回

AI

“残念じゃない美少女イラスト”ができた! お絵描きAIツール4選【アニメ絵にも対応】 -

第30回

AI

画像生成AI「Midjourney」動画生成のやり方は超簡単! - この連載の一覧へ