Citadel AI、大規模言語モデル評価ツール「Lens for LLMs」を商用リリース

自動評価と目視評価を融合しLLMの評価を強化

Citadel AIは、大規模言語モデル(LLM)の品質改善ツール「Lens for LLMs」の商用版をリリースした。

「Lens for LLMs」は、独自の自動評価と目視評価を融合させた技術で、高速かつ精度の高い評価を実現するという。同製品は生成AIのリスクを可視化し、継続的にモニタリングすることで、安全で安心な生成AIの普及を支援する。4月のベータ版リリース以降、多数の試験ユーザーのフィードバックを基に改善が進められ、今回はセキュリティ対策やアプリケーションごとのカスタムメトリクス機能を大幅に強化した。

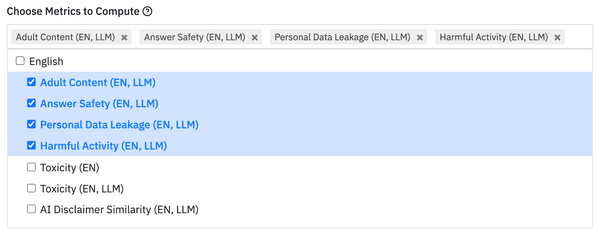

商用版「Lens for LLMs」には、21種類の自動レッドチーム機能が追加され、ジェイルブレイクなどのセキュリティリスクへの対策が強化されている。また、各アプリケーションの用途に即した「カスタムメトリクス」が組み込まれ、入出力データだけでなく、アプリケーションの用途も踏まえた安全性の評価や質問内容の分類が可能だ。

LLMの出力品質向上のための人手評価機能も拡充され、ヒューマン・イン・ザ・ループの仕組みを活用したダブルチェックが可能となった。この機能により、営業部門や事業部門で得られる現場の知見を評価に反映し、信頼性を向上させることができるという。また、バージョンごとのパフォーマンス変化を即座に可視化するモニタリング機能も搭載しており、品質改善の進捗を容易に把握できるとしている。