AI戦略と製品展開、NVIDIAとの提携関係強化……

会社の看板を“AIデータクラウド”に掛け替えたSnowflakeの現在地、AI部門責任者に聞く

2024年08月30日 07時00分更新

Snowflakeは2024年に入り、CEOにスリダー・ラマスワミー(Sridhar Ramaswamy)氏を迎えた。ラマスワミー氏はSnowflakeが買収したNeevaの共同創業者兼CEOで、「AIを理解している人物。Snowflakeが次のステージに進むために必要な人事」(Snowflake共同創業者)と評される。

そのラマスワミー氏が注力するAI部門を率いるのが、バリス・グルテキン(Baris Gultekin)氏。グルテキン氏に、SnowflakeのAI戦略について聞いた。

“AIデータクラウド”カンパニーを標榜するSnowflakeのAI戦略・製品展開

ーーSnowflakeは今年になって、これまでの「Data Cloudカンパニー」から「AI Data Cloudカンパニー」へとメッセージを変えています。AI Data Cloudという言葉に込めた意味を教えてください。

グルテキン氏:データ戦略なしにAI戦略はない。AIにはデータが必要だからだ。したがって、 Data Cloudを提供するSnowflakeは独自かつ有利なポジションにあると見ている。

AI Data Cloudで我々が大切にしているのは、簡単、効率、信頼だ。

「簡単」から説明しよう。Snowflakeではデータのすぐ隣にAIがある感覚で設計しているため、AIのために複雑なデータパイプラインを作ったり、インフラを管理したりする必要はない。高度な専門知識がなくても、AIチャットボットの構築などが簡単にできる。

2つ目の「効率」では、高品質かつ低コストでモデルを利用できるようにしている。例えばSnowflakeのLLM「Arctic-TILT」は、独自のトランスフォーマーアーキテクチャによってドキュメントからデータを抽出するのに特化したLLMだ。GPT-4と比べてはるかにコンパクトでありつつ、文書の理解力では高いベンチマークを達成している。同様に「Arctic embed」モデルは、OpenAIのエンべディングモデルよりも小規模だが、高品質だ。

最後に「信頼性」。顧客は自社の重要なデータをSnowflakeに置いている。我々は、AIをSnowflakeのセキュリティパラメーター内で動かすことで信頼性を確保する。ガバナンスと責任性のための機能も備えており、例えばチャットボットであれば、ユーザーがアクセスすべきではない情報は回答の対象にならないし、ヘイトスピーチ対策となる“ガードレール”を設けることもできる。

このように、AI Data Cloudは、AIとデータを自然な方法で活用できる環境を目指している。

ーーGoogle時代からの同僚で、nxyzを共同で立ち上げた現CEOのスリダー・ラマスワミー氏からSnowfakeのAI事業部を引き継いだ形となります。目標はありますか?

グルテキン氏:nxyzでは検索インデックスインフラなどでスリダーと一緒に仕事をした。だが、私の専門はAIで、nxyzの前はGoogleで「Google Assistant」を担当し、早期バージョンを構築した。そのため、Snowflakeで、エンタープライズ分野のAIに関わることができて光栄に思っている。

AIは一生に一度巡り会うかどうかの重要な技術であり、産業や企業を変革すると信じている。Snowflakeも例外ではなく、スリダーの下で、AIを中核に据える戦略に舵を切った。

Googleで長年スリダーと仕事を共にしたが、彼は素晴らしいリーダーだ。技術の専門知識はもちろんだが、経営者とも話ができる。

ーーAI関連での最新の動きを教えてください。

グルテキン氏:5月にAIアプリケーションの開発環境である「Snowflake Cortex」において「LLM関数」の一般提供を開始した。さらに「ファインチューニング機能」のパブリックプレビューも始めている。これにより、顧客はLLMを直接使うこともできるし、自分たちのドメインに合わせてカスタマイズすることも可能だ。

「Snowflake Cortex Search」と「Snowflake Cortex Analyst」も発表した。Cortex Searchはドキュメントなどの非構造化データ向けで、数千ページもあるようなマニュアルについての質問回答ができるチャットボットの生成などが可能になる。Cortex Analystは構造化データ向けで、「○○地域の売上はどうなっているのか」など、自然言語を使った分析を実現する。

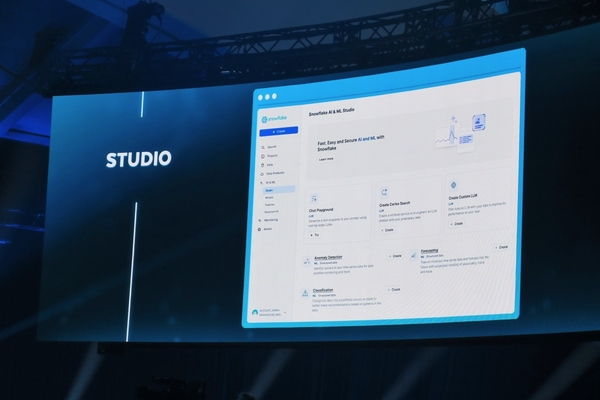

これらを試したり、カスタムアプリケーションをノーコードで開発できる「Snowflake AI & ML Studio」も発表した(機械学習モデル向けはパブリックプレビュー、LLM向けはプライベートプレビュー)。

コーディング支援の「Snowflake Copilot」や文書処理の「Document AI」も一般提供を開始している。

ーー2023年に発表したNVIDIAとの提携が、今回さらに強化されました。AI戦略におけるNVIDIAとの関係を教えてください。他のチップベンダーもAIチップ開発を進めていますが、提携の可能性はあるのでしょうか?

グルテキン氏:2023年の提携では、Snowflake内でNVIDIAのGPUを機能として提供するものだった。今回はこの提携を拡大し、研究レベルで協業している。NVIDIAの高品質なエンべディングモデルをCortexに直接取り込んだり、NVIDIAの推論技術を使ってSnowflakeのLLM「Snowflake Arctic」をより強化していく。

このように、われわれはAI領域でNVIDIAと密な関係を構築している。NVIDIAにはソフトウェア資産(「NVIDIA AI Enterprise」など)があり、さまざまなAI企業が提供するあらゆるモデルがNVIDIAに対応しているといった状況から、現時点ではNVIDIAとの関係は特別なものだと考えている。

ーー企業や組織は、生成AIを受け入れるにあたってどのような課題があると認識していますか?

グルテキン氏:2023年は生成AIのPoC(実証)の年だったが、2024年は本番に向けた動きが現れつつある。実際にSnowflakeのユーザーでも、社内の業務効率化やコスト削減を目的とした生成AIの活用が始まっている。今後は、顧客向けの製品にも適用範囲を拡大していくだろう。

課題は企業により異なるが、共通する懸念点として“ハルシネーション”がある。どのようにしてガードレールを置くか、セキュリティ対策を講じるかと検討する段階にいる企業が多い。

このような課題があるものの、AIへの需要は目を見張るものがある。どこにAIを活用するのか、どこから始めるかなど各社は探っている。生成AIはまだまだこれからだ。

顧客の1社であるBayer(バイエル)は、Cortex Analystを使ってダッシュボード作成やBIの自動化を進めている。中核はデータであり、それを利用できるようにすること。そのためのデータのモデリングにおける技術や知識をBayerは求めている。

Snowflakeは、このような声に応える“データの民主化”、そして“AIの民主化”として、前述した簡単、効率、信頼の3つを確実にしていく。

ーーCortexのマルチモーダル対応計画はありますか? 今後のロードマップについて教えてください。

グルテキン氏:SnowflakeはRekaと提携し、Rekaのマルチモーダル技術を利用できるようにする。Rekaのモデルは高性能であり、GPT-4と遜色ないレベルだ。すでに社内ではRekaのマルチモーダルを利用できるようになっており、今後は顧客に対しても利用できるようにしていく。

基盤であるCortexやLLMのArcticは、今後も品質を向上させていく。Cortexを使ってAI製品を構築するための技術を発表したが、将来的には“エージェント”が大きなトレンドになるとみている。

モデルがアクションをとれるようになることで、複数の異なるシステムを利用できる。企業にはたくさんの資産があり、AIがそれを活用できるようになる。2025年にはエージェントについてもっと話ができるだろう。期待してほしい。