Androidの存在こそがグーグルの強み

グーグルには強みも多数ある。1つは、いかにOpenAI・マイクロソフト連合が存在感を増しているとはいえ、ネット検索の大半をグーグルが握っている事実は(まだ)変わっていない。

そして、同様に大きいのが「Androidを持っている」ことだ。スマホの大半はAndroidで動いており、Geminiと連動していくことの影響は計り知れない。

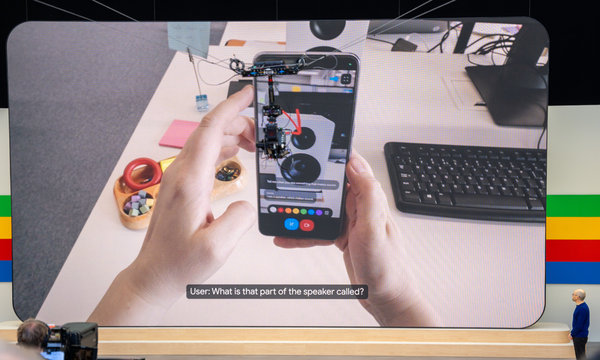

今回の発表で特に注目されたのは「Project Astra」だ。

画像・音声などを認識するマルチモーダル性に加え、即応性と論理的理解力も強化されており、人間との対話に近いものを実現できる。グーグルは「将来のAIアシスタントを目指した技術として開発中」としている。デモ内でスマートグラスが使われたことが話題だが、1つの本質は、「カメラとマイクと通信機能を備えたデバイス」、すなわちスマートフォンを前提にした技術でもある、ということだ。

Project Astraデモ動画

会場で実際に体験してみたが、確かに今までのAIアシスタントとは一味違う。現状はオンデバイスAIで動いているわけではなくクラウドでの動作、とのことだが、こうしたものがスマホに組み込まれ、動作が次第にオンデバイス化されていくのは想像に難くない。

そう考えると、オンデバイス版のGeminiである「Gemini Nano」の価値は特に大きい。

質問がパーソナルなものになっていき、AIアシスタントとの対話が多くなっていくほど、「それを広告で使われたくない」「自分の情報をネットに出したくない」と考えるはず。そのためには、デバイス内だけで処理を完結し、クラウドにはアップロードしないオンデバイス版のAIが必須になっていく。クラウド版Geminiの進化はGemini Nanoの進化にも紐づいており、「即応性と属人性が必要なものはオンデバイスで処理」という流れになっていく可能性は高い。

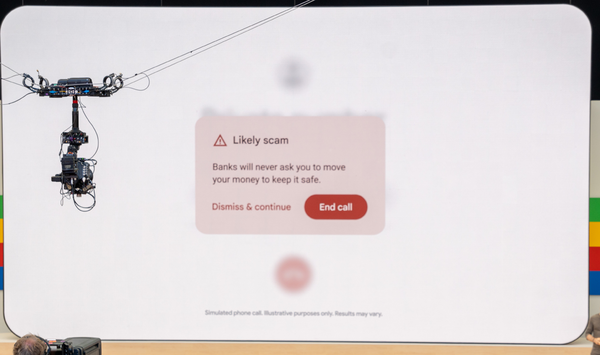

Androidの次期バージョンである「15」とPixelの組み合わせでは、通話中の内容をオンデバイスAIでリアルタイムに解析して「詐欺的な電話である可能性が高い」ことを通知する機能が登場する。当然ながら、通話は極めてプライベートな内容なので、内容をクラウドに頼るわけにはいかず、オンデバイスAIが必須のものでもある。

現状、Gemini Nanoを動かすにはPixelのようなハイエンドスマホが必要だ。次第にプロセッサーパフォーマンスを必要としなくなっていくだろうが、しばらくはハイエンドスマホに撮っての差別化要素となるだろう。

そこではおそらく、「機械とのコミュニケーションによる、より簡易で楽な操作」と「安心・安全のためにAIが人を助ける要素」が重要となるだろう。

そうした要素はスマホOSに紐づいたAIを持つところほど作りやすい。OpenAIと同じようなことをやっていても、グーグルが(ある意味で)有利な状況と言えるだろう。

次に来るのはもう1つのスマホOS大手であるアップルがどう動くのか、という疑問だ。おそらくその答えの一端は、6月に開かれる開発者会議「WWDC」で明かされることになる。