グーグルの本丸”検索”にもAIを

●AI Overviews

AIと検索のミックス、これももう必然的な流れかと思います。Google検索の対抗馬であるBingにCopilotというAIが搭載され、実質的に今のGoogleより良質な回答を返すようになってきていて、検索するとまずスポンサードリンク(検索連動型広告)をトップに表示するGoogle検索がユーザー離れを起こすのは時間の問題です。Copilotのほかにも、Perplexityのような、既存のAIを利用した検索サービスも登場していますし、ある意味グーグルの提供するサービスの母体であり本丸でもある検索にテコ入れがされるのは当然でしょう。

さて、このAI Overviewsですが、検索×AIで先行するBingやPerplexityとは少しアプローチの仕方が違うようです。先行組が、検索結果から有用だと思われる情報を抜粋してまとめを作って提示し、その参照元の情報リンクを添えて回答の信憑性を担保するものであるのに対し、AI Overviewsでは、ユーザーの調べたいことを先回りして提示してくれる検索になるとのこと。

具体的な例を挙げると、

「エアコンの掃除の仕方」を聞く

→具体的な掃除の手順

→便利なTIPS

→掃除の際にあるといい道具

→道具の買える場所と値段

→業者に頼む際の価格と評判のいい業者の連絡先

というように、検索内容に付帯して検索されるであろう情報を先回りして出す、という方式を取っているようです。同様の仕組みはCopilotやPerplexityにもありますが、こちらは先回りして提示するのではなく、「こんなことも知りたくないですか?」と別の質問としてプロンプトを提示するという方式になっています。

●Ask Photos

また、AI Overviewsの応用として、Google Photosに新たに「Ask Photos」という検索サービスが追加されるという発表もありました。これは、Google Photosにアップされた写真から必要な情報を聞き出せるサービスです。たとえば、駐車場で料金精算する際、自分の車のナンバーを忘れてしまっても、写真に写った情報からそれを聞き出すことができたり、とある日に行われた会合に出席していた人を、そのとき撮影された写真を総点検してリストアップする、また、娘の水泳の記録写真だけを抽出して、いつ何ができるようになったかという成長記録を作るといったことが可能になります。

GmailなどGoogle Appsと連携するAI

Google Workspceに追加されるGemini

●Gemini for Workspace

グーグルの強みと言えば、やはりすでに広く利用されているオフィススイートを持っていて、そこにAI機能を盛り込める点でしょう。「Gemini for Workspace」は、どちらかと言えばマイクロソフトの「Copilot 365」の対抗馬というポジションになるもので、Googleスプレッドシート、ドキュメント、スライド、カレンダー、ドライブといったツール類からもGeminiを利用できるようになることが示されました。

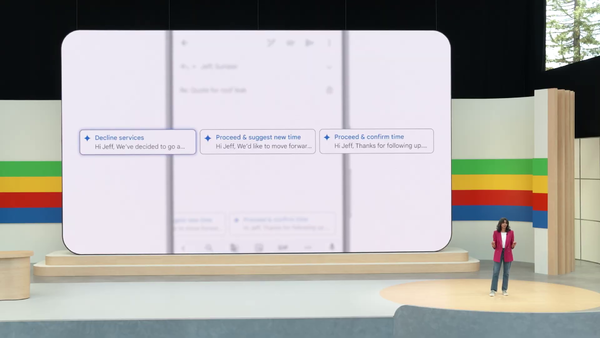

特に、メーラーとしてかなりのシェアを獲得しているGmailにAI機能を提供できるという点は大きなアドバンテージです。Google I/Oのデモンストレーションでは、スレッドになったメールのやりとりの要点をまとめて箇条書きにしたり、複数の業者で相見積もりを取った結果のメールから比較表を作ってみせたり、その結果1社に決めた際の返信も、これまでのやり取りと、カレンダーに入力された予定から推察して「候補日はこの日で、このように返信しては?」という例文候補を複数提示してくれるという、現実になればかなり便利そうだと思えるデモをみせてくれました。

今後は、メールそのものを探し出してその添付ファイルを開く必要はなく、Gmailに「注文した靴が届くのはいつ?」「チケットを取ったバスケの試合は何時から?」と問いかけるだけで、答えを返してくれるようになります。

さらに、他のGoogle Appsとも連携し、送られてきた領収書をGoogleドライブの領収書フォルダに格納する、格納された領収書のデータを抽出してあらかじめ決めておいたGoogleスプレッドシートに記録する、といったことが、Gmail上のGeminiに指示するだけで可能になるようです。

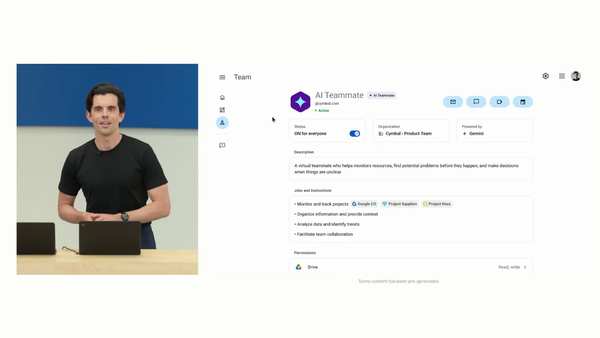

● AI Teammate

今回発表されたGemini for Workspaceの機能のなかでも特に注目したいのが「AI Teammate」です。これは、オフィス内で組んだプロジェクトチームにGeminiを架空のメンバーとして加え、いろいろ雑用をやってもらえるというもの。

プロジェクトチームのメールスレッドやチャットルーム、チームに共有される資料、定期的に開催されるオンラインミーティングの内容、そのすべてに参加して正確に内容を把握しているGeminiは、担当者の代わりに細かい問い合わせに答えたり、プロジェクトの進捗をまとめてくれたり、スケジュールの遅れにアラートを出してくれるなど、プロジェクトチームの秘書的な役割を一手に担ってくれるものになるそうです。プロジェクトごとに、参加するGeminiに名前を付けることもできるそうですよ。

パソコンのローカル環境で動くAI「Gemma」

●Gemma 2

パソコンのローカル環境での利用を想定した軽量型のオープンソースモデルのAI、それが「Gemma」です。パソコン1台あれば動作するので(それなりのGPU環境などは必要ですが)、個人が自由にカスタマイズしたり周辺ツールをつくれたりします。ツールを提供する側にとってオープンソースプロダクトは、一度ダウンロードされてしまえば無料で使えてしまうのでコスト回収もできず、好き勝手に弄り回される代わりに、市井のユーザーの集合知によって思わぬ発展を見せたり、技術的な発見があるのが大きなメリット。そこからまた新たな着想を得られれば、その知見を本家のGeminiにも応用できるというわけです。

GemmaはGeminiと同系統の技術を使って作られていますが、より軽量・低コストで動作し、Gemma 2では、さらにパフォーマンスアップとコストダウンが図られ、特定目的にターゲティングした企業内ソリューション開発やLoRA(Low-Rank Adaptation:特定のジャンルやタスクに特化した追加学習)によるチュー二ング(微調整)が可能になっています。

●PaliGemma

Gemmaは基本的に言語モデルであり、マルチモーダル対応ではないのですが、Gemma 2からは、画像認識にも対応したビジョン言語モデル(VLM)「PaliGemma」が仲間に加わりました。ビデオやオーディオを入力トークンに利用することはできませんが、写真や絵であれば理解できます。

ここで引っかかるのは「Pali」って何なのよ、ってことでしょうが、これは「PaLI-3」という元からあるVLM技術を応用して作られたことから名付けられただけで、決してパリジェンヌのもじりとかそういったことではないようです。

カスタムAIチャットボット「Gems」

●Gems

こちらはChatGPTにおけるGPTsのような仕組み。つまり、あらかじめプロンプトを組んでおいて、特定のタスクに何度も繰り返し使えるAIチャットボットフローに名前を付けて保存しておける機能です。例えば、献立メニューを考えるGems、毎日ヨガポーズを提示してくれるGems、ブログ記事の見出しを10個考えてくれるGems、といった感じです。このGemsは、Google OneのAIが使える有料プラン「Gemini Advanced」のユーザーが使えるようになるそうです。

ビジネスだけじゃなく、子供の学習に特化したモデルも用意

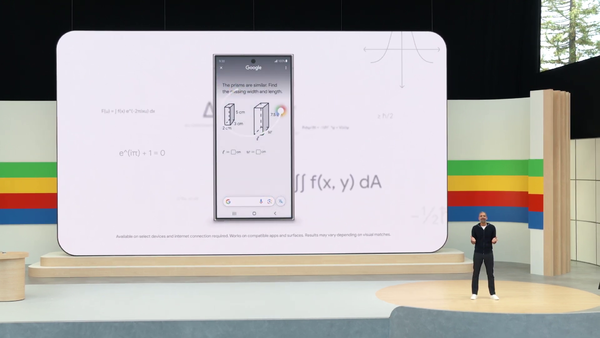

●LearnLM

最後に紹介するのは学習用に特化した言語モデルAI。質問に対し、回答そのものではなく、ステップバイステップでその考え方から提示して、最終的に答えに導くというチャットが可能(Learning coach)になるそうで、すでに一部のAndroid機で提供されている「かこって検索」を使い、ここが分からない、というところを囲って指示すると、その解法を教えてくれるデモが行われました。

Google I/Oから見る今後のAI開発が目指すもの

さて、ここまで大雑把にではありますが、できるだけ一般の人にも分かりやすく、今回グーグルから発表されたAIプロダクトやサービスを紹介してきましたが、これらを総括すると、今回のGoogle I/Oが示したものの根底にあったは、すべてのAIがマルチモーダル化していく、という流れであったように思います。

これには大きく2つの意味があって、ひとつには人間のように、言葉だけでなく、目で見たものや音で聞いたものからも学習し、そのインプットに対して人間がどう反応するのかをAIに学ばせるというタームに入っているということ。より人間が違和感を感じない返答とはどういうものなのか、こんなとき人間だったらどう反応するのかをAIが学ぶことによって、より身近な存在としてのAIを目指すことに繋げるのだと思います。

そしてもうひとつは、ちょっと穿った見方になりますが、今後AIは、人が見聞きしたものを共有し、人との対話を通して学習していくことになるということ。というのも、現在のウェブソースを中心とした世界には、AIに学習させるためのテキストがもうほぼ残されていないと言われているためです。今以上に賢いAIを生み出すためには、現実世界を人間と同じように見聞きして物理世界をより正確に理解させ、他者との対話を通して人間の精神世界を深く理解させるための競争に入っていくのだと思います。

まあ、このあたりは私の個人的な見解なので本職のAIエンジニアの人からしたらてんで的はずれなことを言っているように聞こえるのかもしれませんが。

なんにせよ、AIの進化はまだまだとどまるところを知らず、日々新しい情報や驚きの新技術が発表されて、私的にはずっとワクワクしっぱなしで楽しくて仕方ありません。もちろん、それによって生じる不都合がいっぱいあるのも承知していますが、いちテクノロジー好きとしては、できるだけそこから得られる恩恵のほうに目を向けて、読者のみなさんには、こんな明るい未来が待ってるんだよ!という情報をお届けできればなと思います。