Citadel AI、大規模言語モデルの評価ツール「Lens for LLMs」を発表

株式会社Citadel AI

評価精度の向上と評価作業の高速化を同時に実現

「信頼できるAI」を社会実装する株式会社Citadel AI(本社:東京都渋谷区、代表取締役:小林裕宜、以下「Citadel AI」)は、大規模言語モデル(LLM)アプリケーションの品質を比較評価し、その信頼性を向上するツール「Lens for LLMs」の提供を開始します。

Lens for LLMsは、大量の自動評価に、人間による少量の目視評価を組み合わせ、両者の強みをインテグレートする新たな技術を実装、評価精度の向上と評価作業の高速化を同時に実現します。目視によるラベル付けを効率的に進めることができる、言語モデル用のアノテーションツールも搭載しています。

日本政府は「AI事業者ガイドライン」の中で、人間中心のAI社会原則を掲げていますが、Lens for LLMsは、AIシステムの検証可能性を確保することで、安全安心で信頼できるAIの実現を目指すものです。

Lens for LLMsの特徴:人手評価と自動評価の両者の強みをインテグレート

生成AIがもたらす新たな社会的リスク

生成AIを使ったChatbotのようなLLMアプリケーションの導入が、さまざまな企業で開始されている一方、AIがもたらす新たな社会的リスクも増大しています。LLMのような自然言語処理モデルの場合、絶対的な評価軸を定義することが難しく、こうしたリスクを的確に評価し、安全安心なAIの活用を実現することは容易ではありません。

人間による目視評価が最適と言えるものの、多くの時間とコストを要し、膨大な数のLLMの入出力を、継続して人手で確認することは現実的に困難です。一方で、複数のメトリクス(測定指標)を使った評価は、高速で大量のデータを自動評価することが可能であるものの、人間による評価軸とは必ずしも一致しないケースが発生します。

人手評価と自動評価の両者の強みをインテグレート

Lens for LLMsは、大量の網羅的な自動評価に、人間による少量の目視評価を組み合わせ、両者の強みをインテグレートする新たな技術的仕組みを導入することで、評価精度の信頼性向上と評価作業の高速化を同時に実現します。

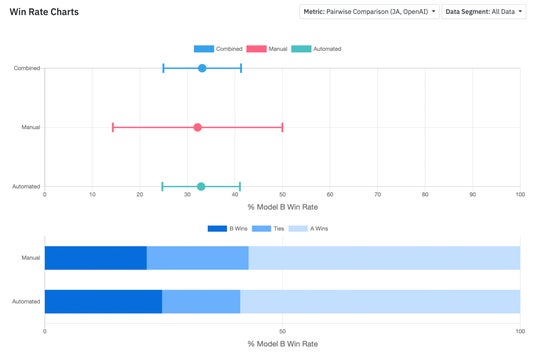

Lens for LLMsの比較評価レポート画面の一例

LLMアプリケーションの単体評価、異なるバーションの比較評価や経年評価等が可能であり、昨年10月にGitHub上でオープンソースライブラリとして公開し、既に世界で1万件以上ダウンロードされているLangCheckの機能も盛り込まれています。Lens for LLMsの詳細については、こちらの弊社ブログ記事をご覧ください。

Lens for LLMsの発表に際し、βトライアルを無償でお試しいただくことができるお客様を限定募集します。ご興味を持っていただけるお客様は、是非こちらからサインアップの上、お申し込みください。

【株式会社Citadel AIについて】

Citadel AIは「信頼できるAI」の社会実装を実現する、日本発のグローバルスタートアップです。ハイリスクAIの課題と正に実戦で闘って来た世界のエンジニアが結集し、開発をリードしています。弊社製品は、AIのモデルやアプリケーションに依存することなく、統一化されたテストを、汎用的に適用することが可能です。国際標準業界を代表するBSI等に採用され、グローバル市場で高い評価をいただいています。

代表取締役 小林裕宜

設立 2020年12月10日

企業URL https://www.citadel.co.jp

X(旧Twitter) https://twitter.com/CitadelAI

お問合せ info@citadel.co.jp