通信状態が悪くてもクリアな音声/ビデオを届ける革新的な技術、LLMにとっても重要な基盤に

LLMではなく「RMM」? シスコWebexの生成AI技術について詳しく聞いた

2024年02月08日 10時00分更新

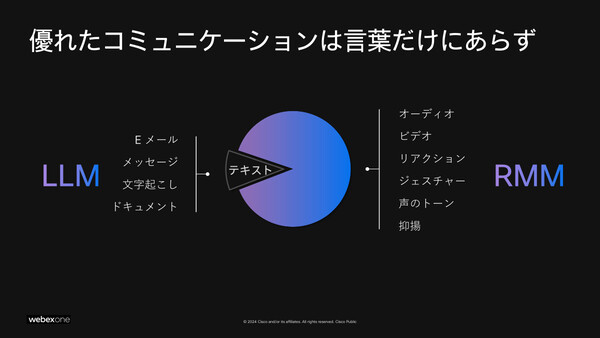

シスコが昨年(2023年)10月に米国で開催した「WebexOne 2023」において、「Webex」に搭載予定の3つのAI新技術/機能が発表された。Webexの音声/ビデオに高度な処理を適用するための生成AIモデル「Real-Time Media Model(RMM)」、生成AIでパケットロスによる音声の途切れ/劣化を防ぐ音声コーデック「Webex AI Codec」、LLM(大規模言語モデル)を使った自然言語によるAIアシスタント「Webex AI Assistant」だ。

AIアシスタント機能は他社のツールでも多く見られるが、音声/ビデオ処理に生成AI技術を適用するのは“シスコならでは”のアプローチでありユニークだ。そして実は、LLMの能力を引き出すうえでも、その基盤としてクリアな音声/ビデオが重要だという。

これらの最新技術がどんなものなのか、何を実現するのかについて、WebexのAI技術エンジニアリング担当VPであるクリス・ローウェン氏に解説してもらった。その内容をわかりやすくまとめる。

LLM/AIアシスタントが働く「基盤」として、なぜRMMが必要なのか?

3つの新発表のうち、まず具体的にイメージしやすいのはAIアシスタントのWebex AI Assistantだろう。

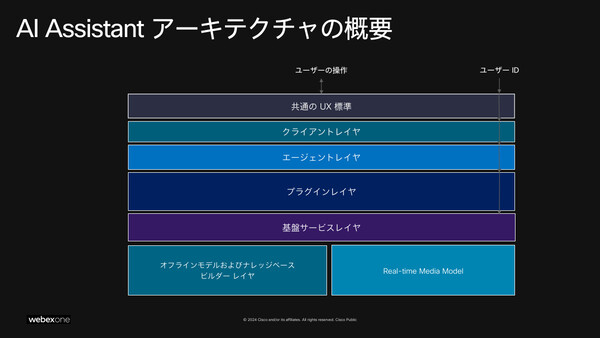

AI Assistantは、LLMを使ったさまざまなテキスト(自然言語)ベースの処理をWebex上で実行する。Webミーティングやコンタクトセンターにおける会話のトランスクリプト(文字起こし)、議事録や通話記録としてのサマライズ(要約)といった機能はもちろん、会議に途中参加した場合に「これまでの議論の概要を教えて」と質問したり、コンタクトセンターで顧客に応答するメッセージのトーンを調整(「柔らかな言葉づかいに」など)してもらったりすることも可能だ。

AI Assistantのバックエンドでは、サードパーティが開発する商用LLM、オープンソースで公開されているLLM、さらにシスコ独自開発のLLMを、タスクそれぞれの要件(正確性や精度、レイテンシなど)に応じて適材適所で使用しているという。

もっとも、こうしたAIアシスタントの機能は、たとえば「Microsoft Teams」「Zoom」といった他社のコミュニケーションツールでもすでに実現されている。使用するLLMについても、サードパーティ/オープンソースのLLMならばたいてい同じものになり、品質や性能に大きな差は出ないはずだ。

そこでシスコが目を付けたのが「音声やビデオそのもの」だった。

たとえば会話相手の通信状態が悪く、何を話しているのか聞き取りづらければ、人間だけでなくLLMも話の内容を正確に理解できない。また、テキストにすれば同じ発言だとしても、発話者が身振り手振りを含めて熱弁したのか、淡々と話したのかで、意味合いが違ってくるケースもある。音声/ビデオを処理する新たなAIを追加することで、LLMはより多くの情報を手にすることができるはずだ。

「Webex上でLLMによる処理品質を向上させるためには、『会議や会話の中で何が起きている』のかをより正確に抽出できなければならない。LLMの処理よりも前の段階で、メディアのキャプチャ(音声/ビデオの取り込み)品質を改善し、会話のコンテクストのような、より豊富な情報を抽出できるようにする必要がある。そこでわれわれは、AI Assistantアーキテクチャの基盤となるレイヤーにRMMを組み込むことにした」

RMM:音声/ビデオの品質を向上させ、より多くの情報を抽出する生成AI

LLMはテキスト(自然言語)を処理するためのAIモデルだが、RMMは音声/ビデオのリアルタイム処理を行うためにトレーニングされたシスコ独自のAIモデルだ※注。

※注:RMMはマルチモーダルAIではない。自然言語の処理は別途、LLMが行う。またシスコの発表では「RMMs」という表記もあり、以下で紹介するようなRMMの機能群は、複数の単一機能モデル(シングルモーダルAI)の組み合わせで実現していると考えられる。

RMMはどんな処理ができるのか。現状で発表されているものをまとめると、以下のようになる(将来予定も含む)。大まかに分類すれば「音声/ビデオの品質向上」と「音声/ビデオからの(テキスト以外の)情報抽出」の2つと言えるだろう。

●音声/ビデオの品質向上:

・高度なバックグラウンドノイズ除去

・スピーカーフォーカス(音声:特定話者の声だけを強調、ビデオ:話者を切り取り表示)

・シネマティックミーティング(ビデオ:複数のカメラ映像から最良のものを自動選択)

・スマートリライティング(ビデオ:明るさの自動補正)

・Webex AI Codec(後述)による低ビットレート音声の高品質化

・ビデオの高品質な超解像処理(アップスケール)

●音声/ビデオからの(テキスト以外の)情報抽出:

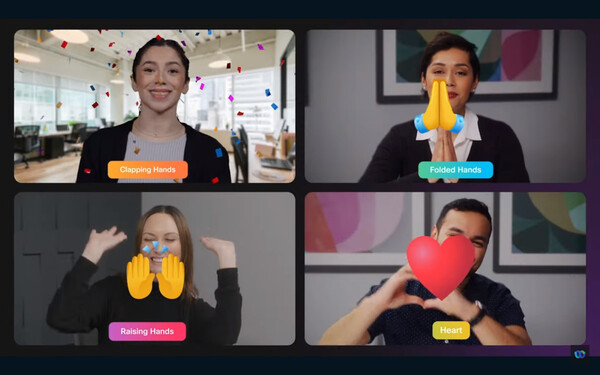

・映像からのジェスチャーの読み取り

・参加者の離席判定

……など

Webex AI Codec:生成AIによる補完処理でパケットロスや狭帯域に強い

もうひとつの新発表であるWebex AI Codecは、通信環境の悪い相手とのWeb会議や通話であっても、非常にクリアな音声で聞こえるようにする新しいコーデックだ。名前に「AI」と入っているが、ここにもRMM、つまり生成AI技術が使われる。

シスコがデモビデオを公開しているので、まずは実際に再生して聞き比べてみてほしい。通常のコーデックを使った前半部は声がブツブツと途切れて聞き取りづらいが、AI Codecを適用した後半になるとなめらかに聞こえる。

Web会議中に相手の音声が途切れて聞き取れないといった状況は、多くの人が体験しているのではないだろうか。こうした音声の途切れはパケットロスによって発生する。ローウェン氏は、広帯域のネットワークがどこでも利用できるようになってはいるものの、パケットロスが頻発する環境はまだ多いと説明する。「一番の問題はパケットロスだ」(ローウェン氏)。

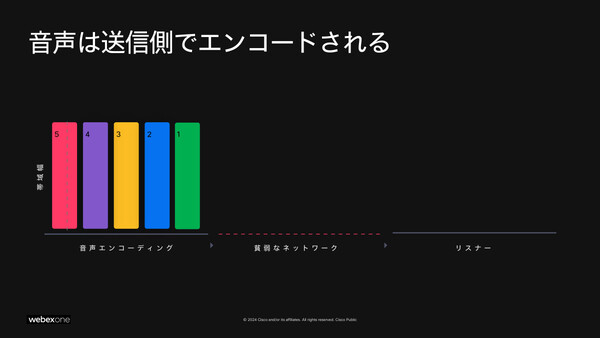

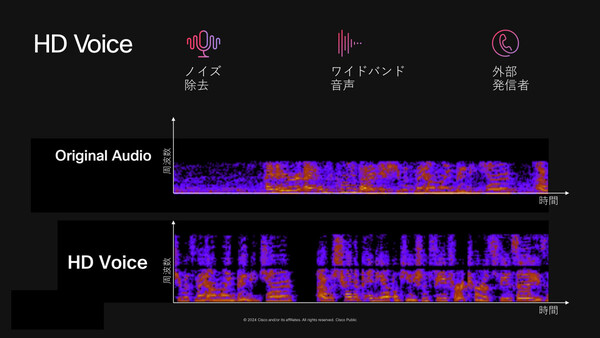

Webex AI Codecは大きく2つの技術、「音声データを冗長化して伝送する手法」と「RMMによる音声の高品質化(HD Voice)」によって、パケットロスが頻発する環境であっても、聞き取りやすいクリアな音声を実現する。

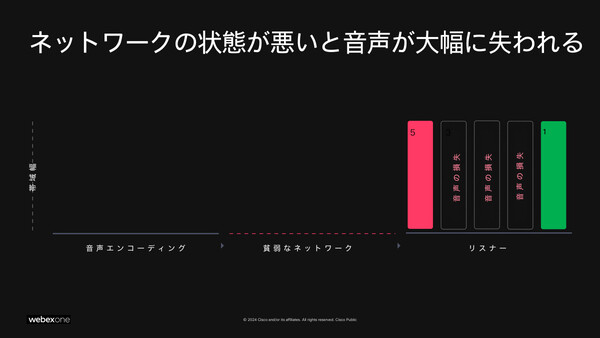

1つめの技術から説明しよう。従来型の音声コーデックでは、音声のデジタルデータをごく短い時間(音声フレーム)単位で区切り、それを順にパケットとして送出する。そのため、通信経路上でパケットロスが発生するとその部分の音声フレームは相手に届かず、再生できない。その結果、音がブツブツと途切れる状態になってしまう。

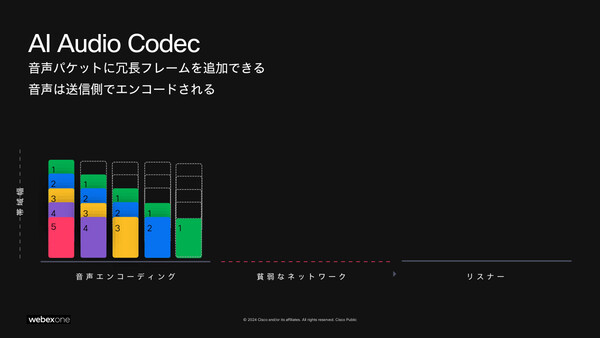

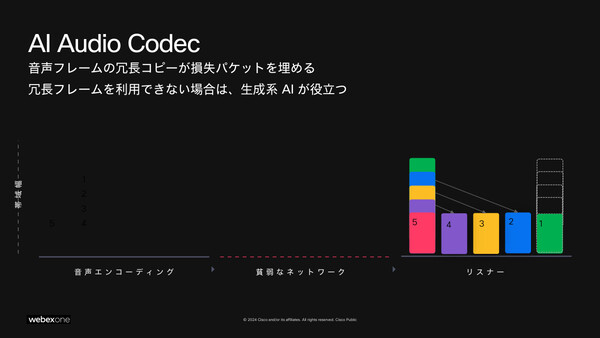

この問題をどう解決するか? Webex AI Codecでは、1つの音声フレームを冗長化(コピー)して複数のパケットに収めることにした。あるパケットが欠落しても、別のパケットから音声フレームが復元できるわけだ。これにより、多少のパケットロスが発生しても※注音声は途切れず再生できる。

※注:さらに、より大量のパケットロスが発生して冗長フレームも取得できない場合は、生成AI技術で欠落した音声フレームを補完し、途切れを防ぐという。

ただし、1つのパケットに複数フレームの音声データを収めるためには、従来型よりも個々のフレームのサイズ(データ量)を小さくしなければならない(上の図と比べると、下の図の1~5のフレームサイズは小さくなっているのがわかる)。音声のビットレートを下げればデータ量は減らせるが、今度は音声品質が劣化して聞き取りづらくなる。

ここで、もう1つの技術である「RMMによる音声の高品質化(HD Voice)」が活躍する。これは低ビットレート化された音声を、生成AI処理によって高品質な音声に「復元」する技術だ。実際には元の音声の正確な復元ではなく、生成AIが“それらしく”補完した音声ではあるが、低ビットレート化で失われやすい高音域が補完されることにより、確実に聞き取りやすくなる。

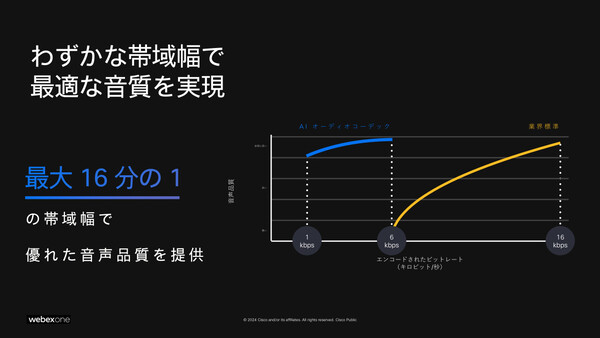

ローウェン氏は、Webex AI Codecによって、業界標準コーデック(Opus)と同等品質の音声を「最大16分の1の帯域幅」で実現できると紹介した。

「Opusコーデックが16kbpsのビットレートで実現するのと同じ音声品質を、Webex AI Codecならば6kbpsで実現できる。さらには1kbpsまで下げても音質の劣化は少なく、十分に実用可能だ。このコーデックは生成AI技術のもたらした革新的な技術、ブレイクスルーと言えるだろう」

ちなみにこのHD Voiceの技術は、AI Codecと切り離して単体でも活用できる。狭帯域のネットワークや公衆電話網を介した通話を聞き取りやすくすることができるほか、音声記録(録音)を保存しなければならないコールセンターなどにおいても、低ビットレートの(データ量の少ない)音声だけを保存すればよくなり、ストレージコストの削減にもつながる。

「シスコではこのAI Codecの技術に多大な投資を行っている。Webexの中で、さまざまな用途に適用を拡大していきたいと考えており、今年(2024年)の夏から順次提供を開始する予定だ」

RMMはビデオの超解像処理にも対応、狭帯域でも高精細な映像を届ける

上述の音声と同じように、RMMでは低解像度のビデオを補完処理して、高解像度のビデオとして出力する「超解像処理」も可能だ。これにより、Web会議に狭帯域のネットワークから参加しても、相手側では鮮明なビデオを映し出すことができる。

具体的には、送信元のデバイス内蔵カメラで撮影したビデオをいったんダウンスケール(低解像度化)、データ量を少なくしたうえで送信し、受信したデバイスでRMMを使って再度アップスケール(高解像度化)するという仕組みだ。

ローウェン氏は、手元にあるPCでデモを見せてくれた。720pのPC内蔵カメラで撮影したビデオを一度180pにダウンスケールし、再度720pにアップスケールして表示するというデモで、単純にアップスケールだけした場合は輪郭がぼやけていたが、RMMで補完処理を施したビデオは輪郭がくっきりと表示された。

「720pから180pへのダウンスケールで、ピクセル数(≒データ量)としては96%を捨てたことになる。ただし、ここにRMMを適用することで、元の720pのビデオとかなり近い品質のものが復元できる。RMMは人間の顔や姿を大量にトレーニングしているので、とても精度の高い補完処理ができる」

こちらの技術も音声と同様に、狭帯域のネットワーク経由でも鮮明なビデオ表示を可能にするほか、録画データ量の削減によってストレージコストを低減できる。

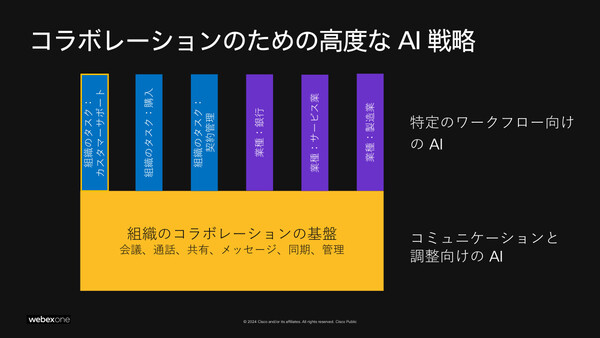

さまざまな業種/タスクへのAI適用の共通基盤となる技術

ローウェン氏は、こうした技術開発への投資は「より良いコラボレーション、コミュニケーションの基盤を作るためのもの」だと強調した。さまざまな業種やタスクで、共通して使える基盤となる。

なお今回紹介した技術については、今後、段階的にWebexの機能として実装していく予定だと述べた。これらの機能を利用するために追加コスト(オプション料金)はかかるか、という質問には「現在のところ追加コストにする計画はない」と答えた。

AI/生成AI技術に関しては、あらゆるITベンダーが技術開発の取り組みを急ピッチで進めている。他社と比較した場合に、シスコWebexのAI技術にはどんな優位性があるかと尋ねたところ、ローウェン氏は「大きく2点ある」と答え、次のように語った。

「まず、音声とビデオの幅広い領域(機能)を包括的に、完全にカバーしているという点。そしてもうひとつは、他社よりもクオリティが高いという点だ。一部の機能は他社も実現していたり、開発を進めていたりするが、その“幅”と“深さ”の両面で、シスコは他社を先行していると考えている」