システムでアドビはどう対策するのか

ここで問題になるのは、そうした機能を使った場合、「なにかに似せた画像」がより作りやすくなる、ということだ。生成AIにありがちな課題だが、「オリジナルのクリエイターの権利を侵害するのでは?」という点だ。

懸念はもっともであり、アドビも対策はしている。

まずModelのカスタマイズについて。これは基本的に「企業側が使う」ものなので、どういうコンテンツを学習するかは、最終的なアウトプットをする企業が責任を負う。

一方で企業向けのFireflyを使う場合、その生成コンテンツについての訴訟には「アドビが全額補償する」というルールが存在するので、この2つを組み合わせれば課題は起きないだろう……という考え方だ。

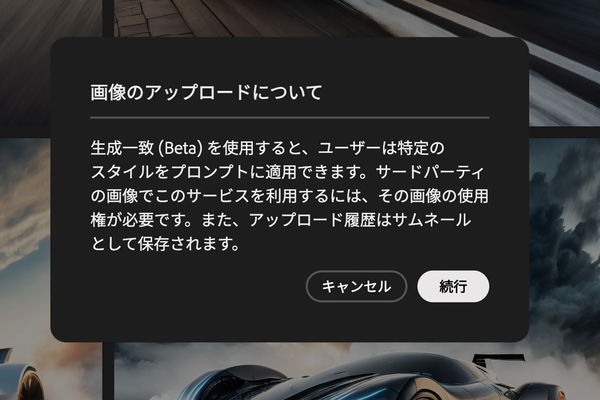

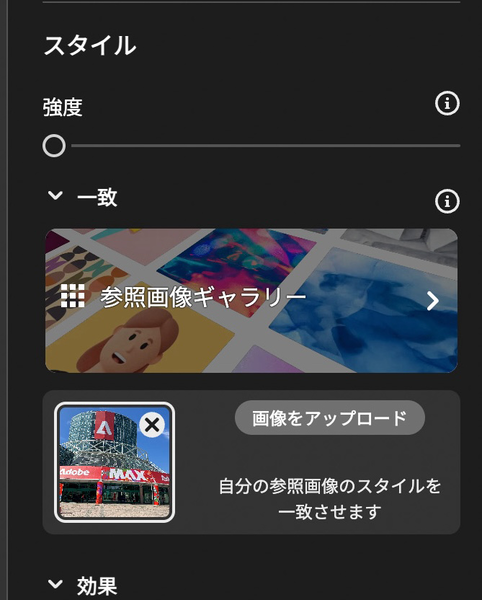

では、個人も使える「生成Match」の場合はどうだろう? ここでは2つの方策が採られている。1つは「コンテンツ認証」の利用。

コンテンツの来歴を記録した技術だが、この中には「do not train(学習拒否)」タグがある。これが生きている場合、生成Matchの対象にならない。許諾上も、利用権があって問題ない画像を使うよう定められている。

次に「記録」。氏によれば、生成Matchに使われた画像は、システム内にサムネイルが記録される。そして、画像についてクレームなどの問題が発生した場合、状況がさかのぼって確認され、その後は同じ画像は生成Matchに利用されないようになるという。

もちろんこれらは、「権利侵害を100%防止する」ものではない。やろうと思えば回避方法はいくらもある。だが、意図的に回避することをアドビは100%防ごうともしていない。

結局のところ、画像を生成することそのものは罪ではない。生成画像を世に出たあと、それが権利侵害や迷惑行為につながった場合、そこで初めて問題になるのだ。

本質的には生成画像を「使う人」に委ねつつ、その前段階で「利用者が判断できない形で侵害が起きること」を防ぎ、「利用者が求める形のコンテンツを作る」ことに合わせた運用が考えられている、という形と理解できる。

アドビのような企業のツールを使う場合、自前で学習した画像生成AIモデルを使う場合と違い、100%の自由はない。

しかし、土台としての安心を作っておき、その上で「利用を望まないクリエイターはその旨意思を示してほしい」ということなのだ。企業が仕事に使うなら、そちらの方が良い。