久しぶりに今週はNVIDIAの話だ。前回のロードマップアップデートが連載581回なので半年ぶりである。なぜこんなに空いたかと言えば、新製品がまったく出てこないのが理由である。今年1月に発表になったGeForce RTX 3080 12GBは新製品と言えば新製品だが、基本的にはGeForce RTX 3080 Tiのダウングレード版ということを考えると、バリエーションチェンジの範疇と言えよう。

そんなNVIDIAであるが、3月23日からオンライン開催となったGTC 2022の基調講演で、次世代GPUであるHopperが発表になった。実際にはHopperだけでなく、ものすごく盛り沢山の発表があり、これを全部カバーするのは1本の記事では到底不可能なのだが、現状ではまだ詳細が明らかにされないGraceなどは後回しにして、一番の目玉とでもいうべきHopperことNVIDIA H100 GPUについて今回は説明しよう。

NVIDIAが次世代GPUの“Hopper”こと「GH100」を発表

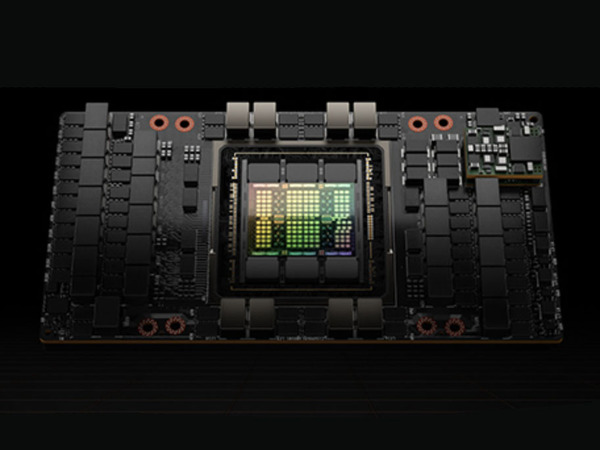

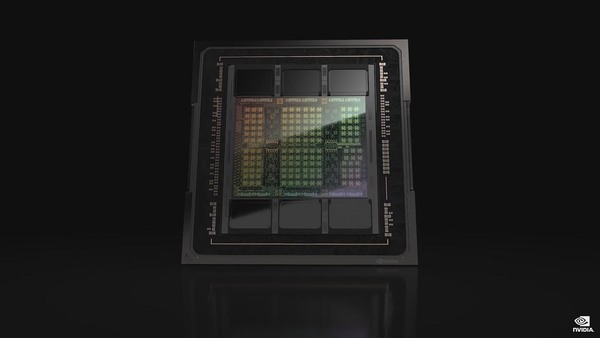

まずはJensen Huang CEOの基調講演から、Hopperに話を絞って説明しよう。Hopperというコード名で開発されたGH100は、HBM3を6つ搭載するやはりお化けチップであった。

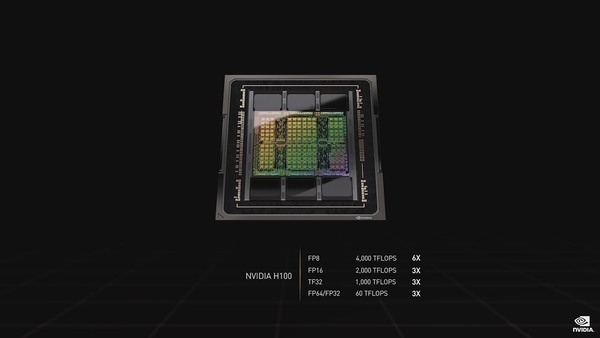

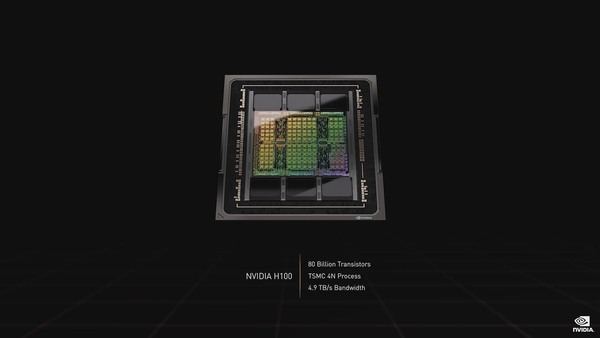

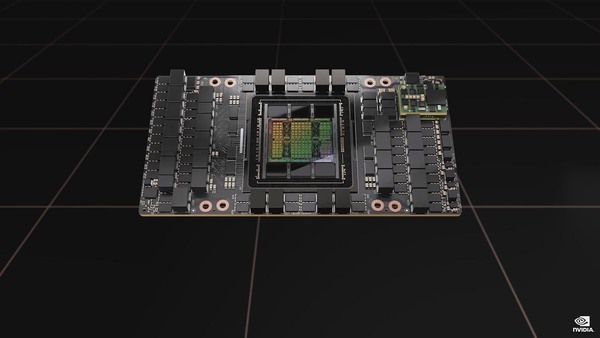

性能はFP32/FP64で60TFlops、AI向けのFP8では4000TFlopsに達する(FP8の話は後述)。TSMCのN4をベースとした、カスタム版の4Nプロセスで製造され、トランジスタ数は800億個に達する。ちなみにダイサイズは814mm2で、おそらくEUVステッパーのReticle Limit(露光できる寸法の限界)ギリギリなのだと思われる。

またこのスライドではNVIDIA H100となっているが、正式にはチップの名称がGH100、これを搭載したモジュールがH100である(わりとこのあたりがNVIDIAの資料を見ているといい加減なのがアレだが)。

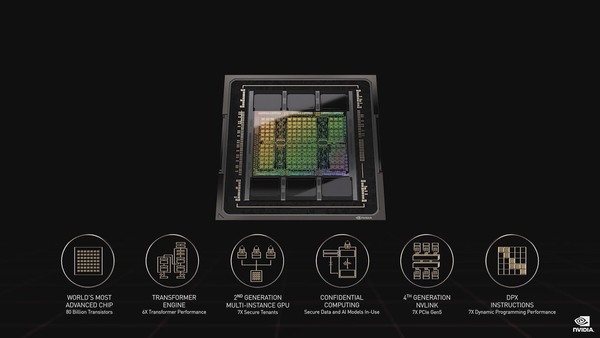

新機能として挙げられているのはTransformer Engine、第2世代のMulti-Instance、Confidential Computing、第4世代NVILink、DPX命令セットなどであるが、これはこの後もう少し詳細な説明があるのでそちらで説明したい。

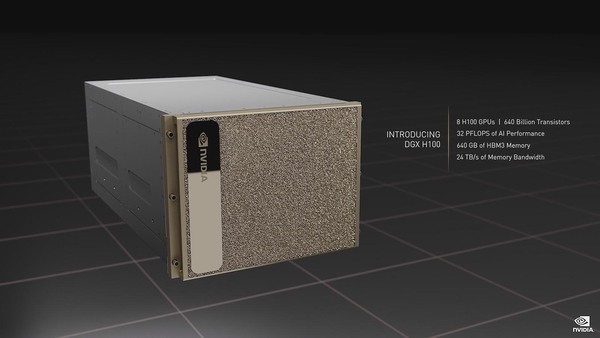

このGH100を搭載したSXMモジュールであるH100は1個あたり700Wの消費電力とされる。このH100を8つ搭載したのがHGX H100となる。そのHGX H100にCPUやNetwork、Storageなどを追加したのがDGX H100である。

Radeon Instinct MI250で採用されたOAMと似たサイズであるが、Radeon Instinct MI250は2ダイで700W。一方こちらは1ダイで700Wである。いろいろな意味ですさまじい

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ