メモリー帯域は1TB/秒と

NVIDIAを凌駕する

次がメモリーまわり。Vega 10に比べて倍の4096bit(つまり1024bitのHBM 2が4 Stack)になったことで、メモリー帯域は倍の1TB/秒に達した。

Tesla V100は同じく4 StackのHBM2ながら帯域は900GB/秒で、TuringアーキテクチャーのGeForce RTX 2080 TiはGDDR6ベースで帯域は616GB/秒程度でしかないため、こちらは明確にNVIDIAを凌駕していることになる。

32GBのメモリー容量は少しゲーミングGPUには大きすぎる気もするが、Radeon Instinct MI50は4 StackながらそれぞれのStack容量を4GBにすることで、帯域を変えずに16GBのメモリー容量にしている。

メモリーメーカー側のオプションとしては、他に1GB/2GBが用意されており、これを利用すれば4GB/8GBの構成も取れるから、このあたりは比較的選択肢が広いことになる。先に演算性能はあまり変わらないという話をしたが、このメモリー帯域の広さによる性能改善は多少期待できるだろう。

ちなみにメモリーコントローラー周りで言えば、HBCCはVega 20にもそのまま搭載される(ここの機能は変わらない)という話であった。またそのHBCCは、HBM2以外のメモリーはサポートしていない。

つまりHBM2の代わりにGDDR6を使ったり、HBM2のさらに外にDDR4をつなぐことは一切考慮していないということで、このあたりはVega 10から一切変更がないことが確認された。

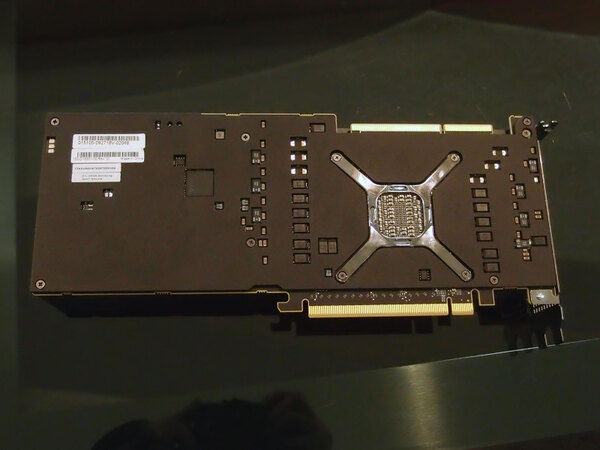

ところでそのRadeon Instinct、見た目には普通のGPUカードと変わらない、というよりパッケージ表側だけ見るとRadeon Instinct MI25とほとんど差がわからないのだが、謎なのはバックパネル側で、Mini Displayportと(おそらくはUSB Type-Cポート)が用意されているのが従来と違うところだ。

ただそもそもVega 20も映像出力機能は本来搭載されている(それがなしだと、今後のRadeon Proへの展開が出来なくなる)から出すことそのものは可能だが、用途が不明である。おそらくは管理用だろう。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ