Infinity Fabricの

信号速度は50Gbps

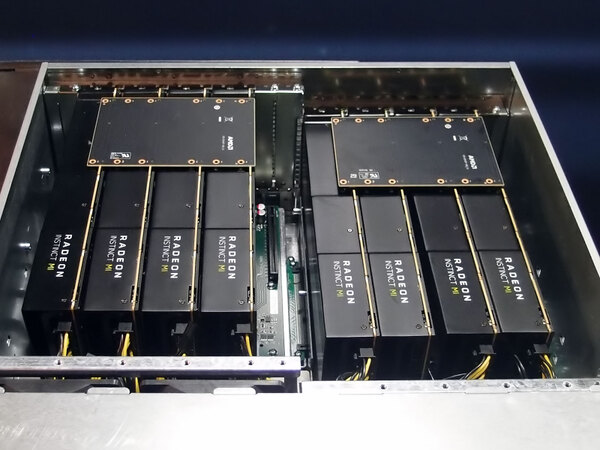

次にInfinity Fabricの話をしよう。上の画像はサーバーシャーシにRadeon Instinct MI60を8枚装着した構成だが、4枚のRadeon Instinct MI60の上に結構大きな板が載っているのがわかる。その板は下の画像のような感じだ。

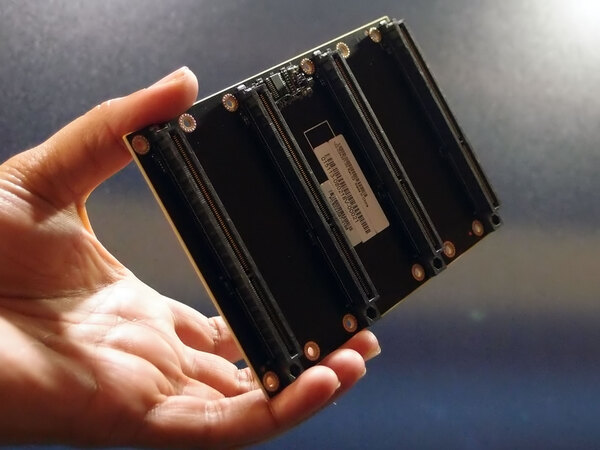

説明によれば信号はx16構成ということなので、信号速度は50Gbpsという計算になる。下の画像が妙に頑丈なシールド構成になっており、しかも途中にバッファらしきものが入っているのは、50Gbpsで信号を通すためだとすれば納得がいく。

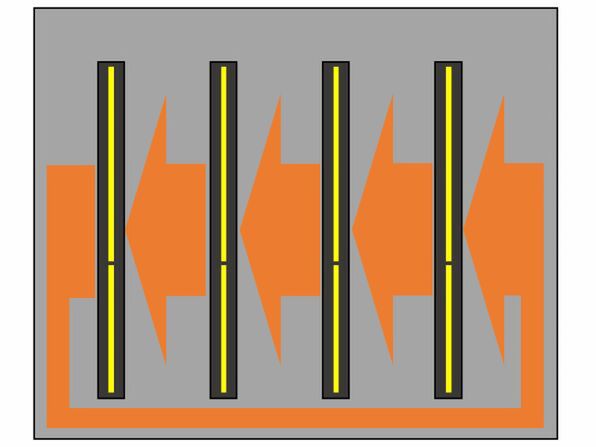

このInfinity Fabricであるが、説明によれば双方向ではあるが、構成はRing Busになっているという話であった。要するに上の画像のコネクターは、内部的には図のような配線になっている模様だ。

Radeon Instinct MI 50/60側は送信/受信ともに100GB/秒(50Gbps×16)で行なう格好である。この構成の場合、隣接するノードに最短だと1hop、最長だと3hopで通信することになるあたり、二重リングになっている可能性もある(そのあたりまで突っ込んでは教えてくれなかった)が、逆に最大でも4枚に限っているから、レイテンシはあまり気にしなくても良いと判断した可能性がある。

ところでInfinity Fabricで接続するということは、逆に言えばキャッシュコヒーレンシが保たれるという意味でもあり、さらに言えば4枚のRadeon Instinct MI50/60に搭載される16/32GBのメモリーが、それぞれ別のアドレス空間にマッピングされることになる。

ということは、このInfinity Fabricを経由して、あるRadeon Instinct MI50/60に搭載されたVega 20コアが、別のRadeon Instinct MI50/60に搭載されたメモリーにアクセスすることも可能になるはずである。実際確認したところ、これは可能という話であった。NVIDIAもUnified Memoryという形でNVLink経由でのメモリー共有をサポートしているが、この点でも並んだことになる。

GPU同士をInfinity Fabricで接続するなら、CPU⇔GPU間もInfinity FabricあるいはCCIXでつないでしまえば、もっと帯域が上がるうえにキャッシュコヒーレンシが取れるのに、という気もするのだが、確認したところ「ROCmが対応してないから無理」という話であった。デバイスドライバーの構造も大幅に変わらざるを得ないため、そうそう簡単には話が進まないのだろう。

この連載の記事

-

第768回

PC

AIアクセラレーター「Gaudi 3」の性能は前世代の2~4倍 インテル CPUロードマップ -

第767回

PC

Lunar LakeはWindows 12の要件である40TOPSを超えるNPU性能 インテル CPUロードマップ -

第766回

デジタル

Instinct MI300のI/OダイはXCDとCCDのどちらにも搭載できる驚きの構造 AMD GPUロードマップ -

第765回

PC

GB200 Grace Blackwell SuperchipのTDPは1200W NVIDIA GPUロードマップ -

第764回

PC

B100は1ダイあたりの性能がH100を下回るがAI性能はH100の5倍 NVIDIA GPUロードマップ -

第763回

PC

FDD/HDDをつなぐため急速に普及したSASI 消え去ったI/F史 -

第762回

PC

測定器やFDDなどどんな機器も接続できたGPIB 消え去ったI/F史 -

第761回

PC

Intel 14Aの量産は2年遅れの2028年? 半導体生産2位を目指すインテル インテル CPUロードマップ -

第760回

PC

14nmを再構築したIntel 12が2027年に登場すればおもしろいことになりそう インテル CPUロードマップ -

第759回

PC

プリンター接続で業界標準になったセントロニクスI/F 消え去ったI/F史 -

第758回

PC

モデムをつなぐのに必要だったRS-232-CというシリアルI/F 消え去ったI/F史 - この連載の一覧へ