GPU/HPCサーバー新製品、オーケストレーションSW、AIコンサルティング協業など発表

レノボ、HPC/AI向けソリューションを“エンドトゥエンド”に拡充

2018年03月08日 07時00分更新

レノボ・エンタープライズ・ソリューションズは2018年3月6日、HPC/AI向けソリューションの拡充に関する記者発表会を開催した。水冷高密度サーバー、ビッグデータ向けストレージなどのハードウェア新製品だけでなく、GPU搭載サーバーパッケージ、HPC/AI環境構築やジョブ実行の自動化(オーケストレーション)ソフトウェア、構造計画研究所やGDEPソリューションズとの協業による機械学習コンサルティングなど、“エンドトゥエンドのHPC/AIソリューション”を日本市場に提供していく方針。

ハードウェア新製品に加え“らくらくパック”やオーケストレーションSWも

まずは同日発表された新製品、機能強化などをまとめておく。

●新製品:HPC向け水冷高密度サーバー「ThinkSystem SD650」

同社“第3世代”となる水冷サーバーThinkSystem SD650は、6Uサイズの「NeXtScale n1200エンクロージャー」に最大12ノードを格納できる高密度サーバー。本体内に冷却水を循環させるパイプが通っており、CPUやメモリ、ドライブなどを直接冷却することで、同社製品で過去最高となる90%の冷却効率(熱除去効率)を実現している。

同サーバーは「インテル Xeon スケーラブル・ファミリー・プロセッサー(Xeon-SP)」を搭載するが、上述のとおり高い冷却効率を実現しているため、最大コア数(28コア)のCPUをサポートするほか、Xeonが備える「ターボ・ブースト」モードでの連続稼働も可能で、最大パフォーマンスを引き出すことができる。

また最高50℃の冷却水でも十分に冷却できるよう設計されており、寒冷地以外のデータセンターでも自然冷却が可能。空冷方式のサーバーと比較して、データセンター全体の冷却に関わるエネルギーコストを35~40%削減できるとしている。なお同サーバーの導入には、サーバールーム内設置型の熱交換器/冷却水供給装置(CDU)が必要となるため、国内では東亜電気工業との協業により提供する。

ThinkSystem SD650の参考構成価格(税抜、以下同様)は、3576万円から(1エンクロージャー/12ノード)。

●機能強化:「NVIDIA Tesla V100」GPUに2Uサーバー2機種が対応

既存モデルの2U/2ノードの高密度サーバー「ThinkSystem SD530」および2Uサーバー「ThinkSystem SR650」において、新たにエヌビディアのハイエンドGPU「Tesla V100」をサポートした。SD530は合計4GPU(1ノードあたり2GPU)、SR650は2GPUを搭載できる。これにより、ディープラーニング処理にかかる時間を短縮できる。

ThinkSystem SD530の参考構成価格は、701万4000円から(1ノード、V100アダプター×2搭載)。

●新製品:AI/GPU“かんたん導入パック”

さらに、上述のSR650サーバーをベースとした「ThinkSystem SR650 GPU Readyモデル」が新たに発売された。これは、GPU活用のための高性能CPUと大容量電源をあらかじめ搭載したモデルで、用途に応じてTesla V100を含む6種類のGPUから選択できる。

ThinkSystem SR650 GPU Readyモデルの参考構成価格は、224万8000円から。

●発表予定:ビッグデータ向けのスケーラブルなSDS

ビッグデータに適したスケーラブルなSDS(Software-Defined Storage)、「IBM Spectrum Scale向け Lenovo分散型ストレージ・ソリューション 2.0」も発表された。1構成あたり最大で504台のハードディスク、約5PBの大容量ストレージを提供する。

IBM Spectrum ScaleソフトウェアとThinkSystem SR650サーバー、Red Hat Enterprise Linuxをベースとした同ソリューションは、構成済み(ラッキング/ケーブリング/ソフトウェアインストール済み)の状態で顧客に提供される。インタフェースは顧客要件に合わせ、10G/25G/100G Ethernet、FDR/EDR InfiniBand、Intel Omni-Pathが選択可能。なお、同ストレージソリューションは2018年3月中の正式発表を予定している。

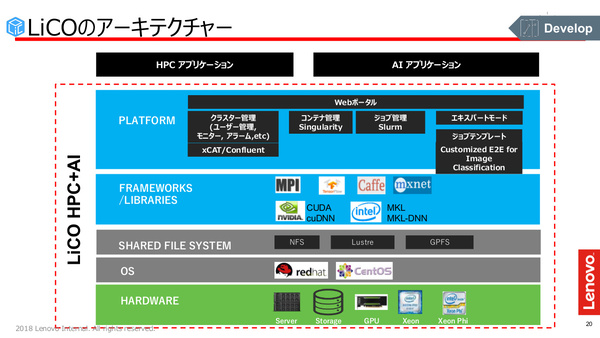

●発表予定:HPC/AI環境のオーケストレーション「LiCO」

HPC/AI環境のオーケストレーションソフトウェアである「Lenovo Intelligent Computing Orchestration(LiCO)」の国内提供予定も発表された。LiCOはジョブスケジューラ、課金、クラスタ管理、リソース監視/通知、コンテナベースのフレームワーク/ライブラリ配布といった機能を備えており、AIエンジニアやITエンジニアが容易にAI/HPC向け環境を構築、運用する手助けを行う。

フレームワークをコンテナイメージベースで管理するため、たとえばAIワークロードごとに異なるフレームワーク(TensorFlow、Caffeなど)を必要とする場合でも、学習実行時のジョブごとにフレームワークを生成/回収するようなワークフローが可能となる。また、スクリプト不要でブラウザから画像認識ジョブが実行できるなど、簡単で理解しやすいGUIも備えるとしている。

LiCOの正式発表は2018年4月の予定。レノボによると、LiCOはオープンソースソフトウェア(OSS)として無償で提供される(サポート契約は有償)。

●新規協業:GDEPソリューションズ/構造計画研究所との協業

レノボが提供するHPC/AIソリューションスタックやLiCOを用いたシステム構築を支援するコンサルティングを、GPU製品のエキスパート企業であるGDEPソリューションズとの協業に基づき展開する。さらにGDEPの主要株主の1社である構造計画研究所から、AI/機械学習のビジネス活用に関するコンサルティングも提供される。

GDEPソリューションズ/構造計画研究所と協業、AI構築/活用コンサルも

発表会ではまず、レノボ・エンタープライズ・ソリューション 代表取締役社長のロバート・スチーブンソン氏が挨拶に立ち、ハードウェア、ソフトウェア(LiCO)、そしてエコシステムパートナーという3つが揃った形でのHPC/AIソリューションの発表は、グローバルのレノボで初めての発表だと語った。

「HPCにかかるコストを下げることで、これまで利用したくてもできなかった顧客にも、HPCのすそ野を広げていこうと考えている」(スチーブンソン氏)

続いて登壇した同社 執行役員 パートナービジネス管掌 製品・パートナー営業統括本部長の橘一徳氏は、レノボでは昨年、AI領域に12億ドル規模の投資をすると発表しており、AI関連の研究開発、今回発表のような企業向けAIソリューション開発、さらに新たなAI活用領域の発見に注力していると語った。

「レノボでは、AIが人間の知能/知性を拡張するという『Augmented Intelligence』というビジョンを掲げている。それにより、日本社会における労働人口減少=労働力不足の解消や、労働の高付加価値化を支えるといったビジネスにしたいと考えている」(橘氏)

一方で橘氏は、AI市場の課題として“コミュニティの分断”を挙げた。AIにかかわる主なプレイヤーとしては、AIアプリケーション開発や機械学習用のデータを整備する「データサイエンティスト」と、AI基盤構築や運用を行う「プラットフォームベンダー」がいる。しかし、この両者間で緊密な連携が取れておらず、それぞれの意識に「距離」があり、効率的なAIアプリケーション開発につながっていないという。おそらくこれは、一企業内のデータサイエンティストとIT担当者でも同じことが言えるだろう。

橘氏は、「今回レノボが発表するAIソリューションスタック、あるいはLiCOなどを通じて、両者間の距離を縮めていきたい」と、AIアプリケーション基盤の状況を分かりやすく可視化すること、基盤のプロビジョニングを容易化/自動化することのメリットを説明した。

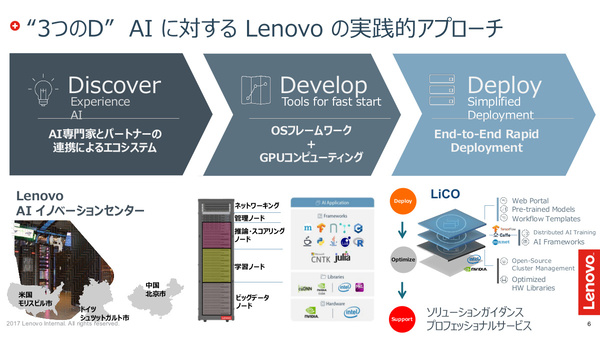

また、AIのビジネス活用について「レノボでは3つのフェーズがあると考えている」と橘氏は述べた。自社ビジネスの中でAIを適用することで効率化/高付加価値化が実現する領域を「発見(Discover)」するフェーズ、それを実装するためのAI基盤を用意しアプリケーションを「開発(Develop)」するフェーズ、それを本番稼働/運用する「展開(Deploy)」のフェーズだ。現実には、前半の発見フェーズや開発フェーズにかなりの時間がかかるという。この部分を、GDEPソリューションズおよび構造計画研究所とのアライアンスによりカバーしていく。

「パートナー2社と共に、いろいろなビジネス活用領域を見つけていきたい」(橘氏)

ゲスト出席したGDEPソリューションズ 代表取締役の長﨑敦司氏は、同社がNVIDIAの国内最上位パートナー(NPNエリートソリューションパートナー)として活動していることを説明した。GDEPがハードウェアやフレームワーク、Dockerコンテナなどの導入コンサルティングを手がけると同時に、同社の出資元(親会社)である構造計画研究所では顧客企業のデータをどうビジネス価値に結びつけるかのコンサルティングを行っているという。

GDEPではこれまで「NVIDIA GDX-1」や「IBM PowerAI」といった、ディープラーニング処理に最適化されたハードウェアを扱ってきたが、「今回(の発表で)うれしいのは、レノボが(x86アーキテクチャの)ふつうのサーバーで4GPUを使える製品を出してくれたこと」と説明。加えて、LiCOによって短時間で環境構築ができる点も評価した。

「(ディープラーニング)フレームワークのバージョンが非常にたくさんあり、どれが良いのか、どれに脆弱性がないのか探すのが面倒だ、という顧客も多い。また高価なサーバーを導入した場合、どう(社内で)配分するのかという問題も出てくるが(LiCOには)課金システムも備わっている。レノボがすべてをパッケージして用意してくれているので非常に楽だと思う。(ソフトウェア的な展開/準備にかかる時間については、感覚値で)3分の1くらいに短縮できるのでは」(長﨑氏)