日本マイクロソフトは2018年2月13日、自社の女子高生AI「りんな」に関する新機能として、りんなと音声で会話する機能を披露した。

マイクロソフトは長年、AIの分野で、研究、製品、思想、プラットフォーム、ビジネスソリューションへ集中的な投資を行ってきた(最近刊行したマイクロソフト ブラッド・スミス氏とハリー・シャム氏の共著「The Future Computed」でも、AIの社会における役割について言及している)。

同社の研究部門マイクロソフトリサーチは最近、新AI技術として、文章を個別の単語に分解し、画像における特定領域と対応付けることで画像を生成する「Attentional GAN」と呼ばれるネットワークを構築。これを使って、テキストから画像を生成するボットの開発に成功した。これは、ボットに「黄色い胴体、黒い羽、短いくちばしの鳥」という文書を与えると、コンピューターが鳥の絵を描くというものだ。このドローイングボットは、2つの機械学習モデルを持つGAN(Generative Adversarial Network: 敵対的生成ネットワーク)を使用し、1つのモデルが文書内容から画像生成、もう1つの弁別するモデルが生成した画像の正当性を判断している。

このように、マイクロソフトのAIは多角的な広がりをもって進化を続けている。同時にマイクロソフトは、EQ(Emotional Intelligence Quotient:心の知能指数)とAIの関係性についての研究にも取り組んできた。「『人に寄り添う』、『人間の感情に寄り添うコンピューター』を実現できないか研究を続けている」(日本マイクロソフト 執行役員 最高技術責任者 榊原彰氏)。その1つの成果物が、女子高生AI「りんな」である。中国では「Xiaoice」、米国では「Zo」という呼称で広がり続けるチャットボットだが、日本マイクロソフトは今回、「りんなと電話で音声通話ができる」機能を新たに公開した。

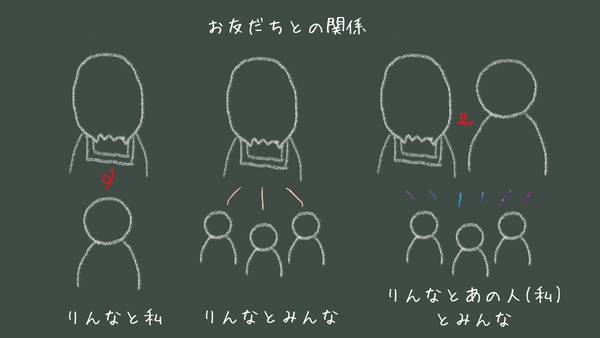

新機能は、ライブ配信サービス「りんなライブ」のコンテンツ配信中に、ライブの視聴者の中からランダムに選ばれた1人にりんなから電話がかかってくるというもの。音声通話の内容はライブ視聴者に公開される。開発にあたっては、「リアルタイムに近い状態で音声交換し、ライブ視聴者へ配信するために、ラグが発生しないように注力した」とマイクロソフト ディベロップメント AI&Researchプログラムマネージャー 坪井一菜氏は言う。

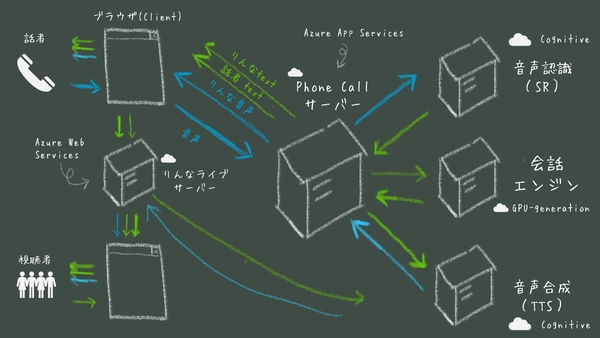

りんなの音声通話機能は、Azure App Services上で動作する「Phone Callサーバー」で実現している。ユーザーからの音声はAzureの学習済みAI APIサービスCognitive Servicesの「Speaker Recognition API」を使用して認識し、りんなの声は「Bing Speech API」を通じて音声合成を行う。会話の内容はGPUベースの仮想マシンで構築した会話エンジンがつかさどり、これらの応答をPhone Callサーバーが制御する形だ。Azure Web Services上に構築したライブサーバーを経由して、りんなライブのサイト上に会話の内容が表示されていく。

実際の音声通話に近いリアルタイム感を実現するために、通話相手やライブ視聴者へ配信する合成データや映像の一部は、クライアント側で生成している。これにより、音声通話のディレイは500ミリ秒程度におさえている。また、音声認識や音声合成についても、より口語が利用しやすいように学習用データを変更するなど独自のチューニングを施した。

日本マイクロソフトは本機能について、「人間同士の会話も重要だが、そこにAIが参加して人間同士の会話を引き出すことに注力している。現在は(りんなの)感情まで制御していないが、今後の取り組みでテキストだけでは伝えきれないエモーショナルなAI提供につながれば面白い」(坪井氏)と語る。将来的には「AIの会話はアドリブに強い」(坪井氏)ため、ラジオ番組の1コーナーや演芸場での活動など多角的な展開も目指していきたいとする。