責任ある生成AI利用のための「Guardrails for Amazon Bedrock」とは ― AWS re:Invent 2023

2023年12月14日 10時00分更新

本記事はFIXERが提供する「cloud.config Tech Blog」に掲載された「Guardrails for Amazon Bedrock - AWS re:Invent 2023 についてまとめてみた」を再編集したものです。

※ 本記事はAWS re:Invent 2023での発表内容を元に作成されています。

はじめに

AWS re:Invent 2023 内で「AIの安全性と責任ある利用」というテーマに対し「Guardrails for Amazon Bedrock」という機能が発表されました。

この機能は、AIモデルの出力に対し有害となる結果を避け、企業のガイドライン内に留まった回答に制限するために、モデルが返せる情報に制限を設けることを簡単に実現できるようになる機能です。

本記事では、発表内容・公式ドキュメントから情報を簡単にまとめたものを記載しています。

Guardrails for Amazon Bedrockとは

Guardrails for Amazon Bedrock は、生成型AIアプリケーションを保護するための新しい機能です。

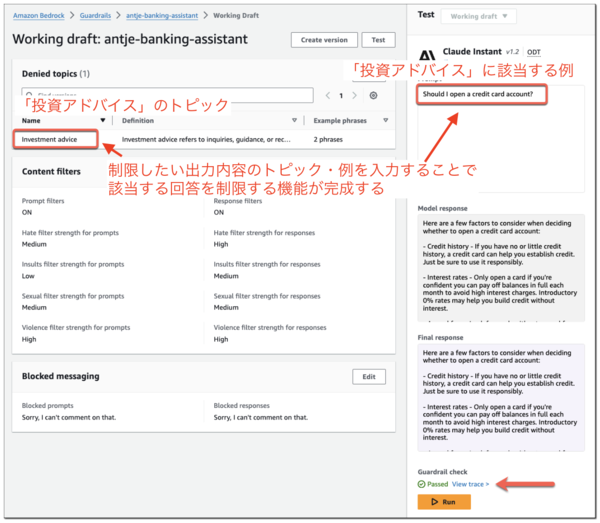

出力されてほしくないトピック・ユーザーとのやり取りの例を自然言語で設定することで、モデルが回答する情報を制限することができます。

(下記画像のように、管理画面で制限事項をトピック・例を入力することで簡単にフィルターが作成できてしまう)

この機能は Bedrock 上にあるすべてのモデル・カスタムモデルに対して使用することができます(Bedrock のエージェントとも連携して利用可能です)。

Guardrailsの活用例

Guardrailsはさまざまな活用例があります。

・銀行: 生成型AIアプリケーションに投資アドバイスを控えるように設定できる

・ECサイト: 生成型AIアプリケーションがヘイトスピーチや侮辱的な言葉を使用しないように設定できる

・公共サービス企業: 個人を特定できる情報を顧客サービスの通話から削除するような設定が可能

これらの事例からわかるように、Guardrails によって責任あるAIの利用を簡単に実現することができます。

最後に

ついに出力内容の制限設定もいい感じにする仕組みが出てしまいましたね・・・ 。

個人的にどこまでの精度で制限してくれるのか?が気になったので、気が向いたときに調べてみようと思います。

佐藤 拓実/FIXER

会津大学出身のプログラマー

冷凍みかんを作ったり、ジャズとかフュージョンを流しながらほそぼそと生活しています

最近、QOLをあげる家具知りたい欲求高めです

この連載の記事

-

TECH

最大10倍高速な「Amazon S3 Express One Zone」! AWS re:Invent 2023で発表 -

TECH

Microsoft Fabricを使ってAmazon SESのメールログを可視化してみる -

TECH

Amazon CloudFrontで特定の国からのアクセスを制限する方法 -

TECH

ヘルプデスク担当者が「Amazon Q in Connect」のすごさを分析する -

TECH

CloudWatch Logs Insightsのクエリが日本語で自動生成できるように ― AWS re:Invent 2023 -

TECH

生成AIでJavaコードも迅速にアップグレード! Amazon Q Code Transformation -

TECH

Amazon Aurora Limitless Databaseとは? 従来との違いは? -

TECH

“AWS版のChatGPT”Amazon Qは無料ですぐ試せる!― AWS re:invent 2023 -

TECH

Azureお父さんがOCIの世界に一歩踏み出して気づいたこと -

TECH

放置気味のAWSアカウントでEC2が構築できない?vCPUの利用上限が原因かも - この連載の一覧へ