Microsoft Build Japan基調講演レポート GitHubもNVIDIAも登壇

生成AIと大規模言語モデルで激変した開発現場にマイクロソフトはなにを提供できるのか?

2023年06月30日 11時00分更新

6月27日・28日に開催されたマイクロソフトの開発者向けイベント「Microsoft Build Japan」。2日目のキーノートはマイクロソフト、ギットハブ、NVIDIAが登壇し、AIとソフトウェア開発をテーマに最新の取り組みを披露。生成AIのマルチモーダル化、CopilotとPluginsという新しいソフトウェアの開発、LLMの学習で大きな課題となるAIワークロードの高速化など、開発者やエンジニアにとって刺激的なトピックが飛び交った。

生成AIのトレンドはマルチモーダル化、そして量から質へのシフト

「Microsoft Build Japan」はマイクロソフト最大の開発者向けイベント「Microsoft Build」の日本版にあたる(関連目次:Microsoft Build 2022 Spotlight on Japan完全レポート)。今年は日本マイクロソフトの品川オフィスでの会場開催とオンラインのハイブリッドで開催され、今年大きな注目を集めているAIを中心に、開発ツール、DevOps、セキュリティ、SRE、ノーコードなど幅広いテーマでセッションが披露された。

冒頭、マイクロソフトが提供するAIインフラについて説明したのは、日本マイクロソフトのCTOに就任した野崎弘倫氏になる。野崎氏は金融システムのシステムエンジニアとしてキャリアをスタートさせ、その後北米でいくつもの開発プロジェクトに従事してきた。アメリカのシリコンバレーでトータル24年間、開発業務に携わり、今年の1月にマイクロソフトのCTOに着任した。

野崎氏は、「日本のテック業界は、クラウドやDX化への移行、大規模システム障害、そして第4次AIブームなど、さまざまなチャレンジや課題に直面しています。それらのソリューションを、幅広い製品ポートフォリオを持つマイクロソフトの製品を通じて支援するCTOとして尽力していきたい」と抱負を語った。

続いてAIについての説明。野崎氏はAIとプログラムの違いについて、「AIは明示的にプログラムされるのではなく、データや経験から学習する能力を持っている。いわば増幅器となり、人や組織の能力を拡張したり、推論する能力を持っている」と説明。そして、莫大な計算資源とデータを持つことで、AIの精度は今一気に向上している。また、プログラムを介したコンピューターとのインターフェイスが、対話型AIによる自然言語でのやりとりに進化したことで、多くのユーザーが利用できるようになったという。

AIモデルや開発にも大きな変化が現れている。従来のAIモデル開発は特定のサービスやアプリごとに異なるデータセットやトレーニングを行なっていたため、コストと時間がかかっていた。しかし、AI基盤モデル(Foundation Model)をベースにした生成AIの登場以降、1つのモデルでさまざまなタスクに順応できるようになった。

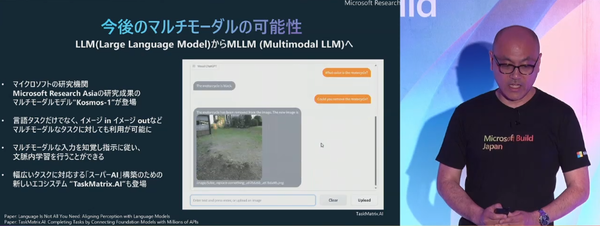

そして、今後はLLM(Large Language Model)は、言語タスクだけではなく、画像や音声もこなせるマルチモーダル化へ進む。さまざまな入力を知覚し、人間のようなハイコンテキストな内容を学習できる。マイクロソフトの研究機関であるMicrosoft Research Asiaではマルチモーダルモデル「Kosmos-1」や、物理まで含めた幅広いタスクに対応できる「TaskMatrix.AI」も発表している。

ひたすら量を追い求めてきたLLMも質の時代に突入している。Microsoft Researchは、TransformerベースのLLM「phi-1」を6月に発表。phi-1はわずか13億のパラメーターしかないにも関わらず、1750億パラメーターのGPT-3.5を大幅に凌駕するベンチマークスコアを達成したという。

長らくLLMと向き合ってきたマイクロソフト Azure OpenAI Serviceも急成長

マイクロソフトのCEOであるサティア・ナデラ氏は、年頭に「AIの黄金時代が到来し、われわれの把握している仕事を再定義するだろう」と語っている。つまり、AIが仕事を奪うという議論を超え、仕事そのものと役割の再定義が行なわれるということだ。野崎氏は5つのポイントで、マイクロソフトのAIへの投資について説明した。

まずAIのイノベーションに対する研究・開発体制。マイクロソフトはグローバルで8箇所のMicrosoft Researchラボを持ち、AIに特化した6000以上の論文を有している。1000人以上もの研究者がコンピュータービジョンや自然言語、音声処理、インタラクションなどの研究を進めており、人間の読解能力を超えるAIなど、世界初となるAIのブレイクスルーも多いという。

また、セキュリティや責任あるAIの原則。「AIは比較的人間の知性に近く、データセットにおけるデータの有害性、悪意ある使い手によっては、本来想定しないリアクションがあります」と野崎氏は指摘。これに対してマイクロソフトでは、「プライバシーとセキュリティ」「包括性」「アカウンタビリティ」「透明性」「公平性」「信頼性と安全性」という6つの原則を「責任あるAIの原則」として定義。ガイドラインを作成した上で、製品への実装を行なっているという。

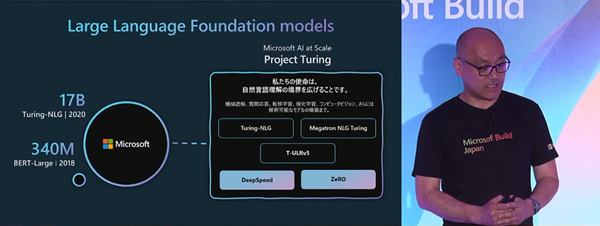

マイクロソフトは以前から大規模な言語モデルの開発に着手しており、2018年のBERT-Largeからスタートし、2020年のTuling-NLGモデルは170億という当時としては過去最大のパラメーターを誇っていた。2021年の後半、マイクロソフトはNVIDIAとの提携により、5300億のパラメーターを持つモノリシック自然言語生成モデルのMegatoron-Tuning NLGの提供に至る。NVIDIAのほか、METAやTaggingFaceとの協業を進めてきたが、今年大きな話題になったのはChatGPTを提供するOpenAIとの提携だ。

サービス開始からわずか2ヶ月で1億ユーザーを獲得したChatGPTは、マイクロソフトのエコシステムで構成されている。プライマリクラウドにMicrosoft Azure、開発にGitHubを用いており、AzureのCosmos DBが爆発的なユーザー増を支えている。セキュアな環境でOpen AIを活用できるAzure OpenAI Serviceのユーザーはすでに4500社に上っており、「これはAzureというサービスの中で、もっとも急速に成長しているサービス」と野崎氏は語る。