グーグルは3月14日(現地時間)、大規模言語モデル(LLM)「PaLM」のAPIを発表。当面はプライベート・プレビューを通じて一部の開発者のみに提供されるが、近日中にウェイティングリストも公開されるという。

パラメーター数は最大5400億

PaLM(Scaling Language Modeling with Pathways)はグーグルの研究機関Google Researchが2022年4月に発表したLLM。開発者は「PaLM API」を呼び出すことで、学習済みのPaLMが持つ文章生成、会話、要約、分類といった様々な機能を利用することができるようになる。

グーグルの代表的なLLMには2021年に発表された「LaMDA(Language Model for Dialogue Applications)」もあるが、こちらは会話に特化したモデルであり、PaLMはLLM本来のもっと幅広い用途での利用を想定している。

PaLMのニューラルネットワークの規模は最大5400億パラメーターとなっており、Meta「LLaMA」の最大650億パラメーター、OpenAI「GPT-3」の最大1750億パラメーターを大きく上回っている。(同日発表されたOpenAIの「GPT-4」はパラメーター数を明らかにしていない)。

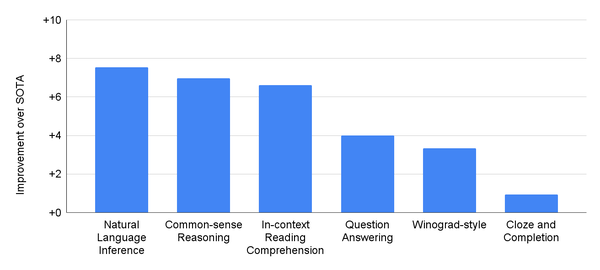

PaLMの能力を質疑応答、文脈内読解、文章完成、常識推論といった29の英語自然言語処理(NLP)タスクで評価したところ、28タスクでGPT-3、LaMDAといった先行LLMの性能を上回ったという。

巨大言語モデルはパラメーターの数が多いほど性能が向上するとされておりグーグルはそのメリットを強調するが、そのぶん必要とされる処理能力も跳ね上がりマシンコストが増大するというデメリットもある。

対称的に、Metaが提供するLLaMAはパラメーター数を減らすことによって単体GPUでも動作することをメリットにしている。

当初APIで公開されるのは「サイズと機能の面で効率的なモデル」とされており、5400億パラメーターよりもスリムなモデルになるようだ。

また、PaLMにプロンプトの反復、合成データによるデータセットの増強、カスタムモデルのチューニングといった特定のタスクを実行させるための「MakerSuite」と呼ばれる新しいプロトタイピングツールも発表している。

Google CloudでPaLMを利用する

さらに、Google CloudでPaLMを利用できるようにするために、機械学習モデルやAIアプリを構築・デプロイするためのAI開発プラットフォーム「Vertex AI」の大規模アップデートも行なわれた。現在はテキストや画像を生成する基礎モデルを提供しているが、将来的には音声や動画にも対応するという。

また、企業や研究者が独自のデータを使い、生成AIを搭載したチャットインターフェイスやデジタルアシスタントを構築するためのサービス「Generative AI App Builder」の提供も開始した。

Google Workspaceにも生成AI機能を追加

グーグルは同日、同社のクラウドサービス「Google Workspace」のGmailやGoogleドキュメントに生成AIを使った以下のような新機能を追加することも発表した。

・Gmail の下書き、返信、要約、優先順位づけ

・ドキュメントでのブレインストーミング、校正、執筆、書き直し

・スライドで自動生成された画像、オーディオ、ビデオを使って、クリエイティブなビジョンを作成する

・スプレッドシートの自動補完、数式生成、文脈に応じた分類により、元データから洞察や分析につなげる

・Meet で新しい背景を生成し、会議のメモを作成する

・Chat で物事を進めるためのワークフローを実現する

サイトでは、プロンプトを入力するだけで文章のドラフトが自動的に作成される様子を公開している。作成されたドラフトに情報を追加したり、文章のトーンを変更したりすることも可能だ。

まずは米国の英語版を「信頼できる一部のテスター」に提供し、年内には一般公開する計画だ。