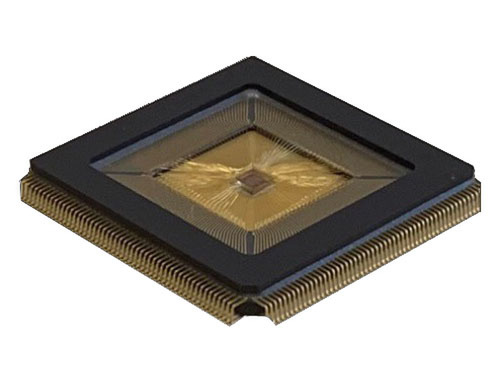

今回取り上げるEnCharge AIは、創業したのが昨年2月なので、やっと1年経ったばかりというできたてホヤホヤなスタートアップ企業である。一応プロトタイプのシリコンは存在するようだが、外部に評価用チップを出荷できるような状況ではない。

さらに言えば同社がステルスモードを抜けたのは今年1月のこと。今年1月に同社は総額2170万ドルの投資を複数のベンチャーキャピタルやファンドから受けており、これに合わせてステルスモードから抜けた格好だ。なのだが、実は同社の技術は過去6年に渡って蓄積されてきたものである。

創業者はNaveen Verma教授(CEO)とKailash Gopalakrishnan博士(Chief Product Officer)、Echere Iroaga博士(COO)の3人である。Verma教授はプリンストン大のECE(Electrical and Computer Engineering)学部の教授職を現在も継続しながらEnCharge AIを立ち上げた格好だが、CPOのGopalakrishnan博士は2022年3月まではIBMのフェロー職にあり、COOのIroaga博士はIkanos CommunicationsからApplied Micro経由で、EnCharge AIに合流直前まではMACOMでVP&GM, Connectivity Business Unitというポジションにおられた。

ちなみにApplied Microは2017年にMACOMに買収された(連載446回参照)ので、これにともなってApplied MicroからMACOMに移籍された格好だ。

長年研究してきた演算ユニット内蔵メモリーを商品化

そんなEnCharge AIであるが、核となる技術はアナログベースのCIM(Compute-In-Memory)である。実はこれはVerma教授の研究テーマでもあり、プリンストン大でVerma教授はこの技術をずっと研究してきていた。冒頭に書いた過去6年の技術と言うのは、プリンストン大の中で行なわれてきた研究をさしている。

実際この技術は2021年のISSCCで“A Programmable Neural-Network Inference Accelerator Based on Scalable In-Memory Computing”として発表されている。発表したのはHongyang Jia博士以下7名であるが、これはVerma教授の研究室のメンバーであり、それもあって最後に指導教官であるVerma教授も名前を連ねている。ここで研究してきた技術をベースに実製品を構築する目的で創業されたのがEnCharge AIというわけだ。

さてそのEnCharge AIのコアであるが、先に書いたようにアナログベースのCIMである。CIMはこれまでも何度か説明してきたように、メモリーアクセスのコスト(主に消費電力)が圧倒的に低下することもあり、性能/消費電力比を引き上げるのには非常に効果的な仕組みとなっている。

デジタルベースで言えばSamsungのPIMやSK HynixのGDDR6-AiMがそうだし、Compute-Near-Memoryで言えばCerebrasのWSEやGraphCoreのTSPやインテルの試作AIプロセッサーなど多数ある。

ただデジタルベースでは、現実的には膨大なSRAMを搭載してここに演算ユニットを埋め込む形になるので、とにかくダイサイズが巨大化するという欠点があった(CerebrasのWSEなどその極北に位置する製品である)。

別のアプローチが、SRAM以外のメモリーを利用する方式である。TetraMemのmemristorやNORフラッシュを使うMythicのAMPやSyntiantのNDPなどがその例で、メモリー素子を利用してそのままアナログ的に畳み込み演算をすることで高効率化を図るというアプローチだ。EnCharge AIのアプローチも、このアナログ演算に近いのだが、最大の違いはメモリスタでもNORフラッシュでもないことである。

この連載の記事

-

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 -

第853回

PC

7つのカメラと高度な6DOF・Depthセンサー搭載、Meta Orionが切り開く没入感抜群の新ARスマートグラス技術 -

第852回

PC

Google最新TPU「Ironwood」は前世代比4.7倍の性能向上かつ160Wの低消費電力で圧倒的省エネを実現 -

第851回

PC

Instinct MI400/MI500登場でAI/HPC向けGPUはどう変わる? CoWoS-L採用の詳細も判明 AMD GPUロードマップ - この連載の一覧へ