株式会社Laboro.AI

株式会社Laboro.AIは、本年4月に公開した当社オリジナル日本語版BERTモデルに蒸留を施し軽量・高速化を図った『 Laboro DistilBERT 』を開発し、非商用途に無償公開いたしました。 <今回のポイント> ・︎ 本年4月に公開した当社BERTモデルをさらに軽量・高速化 ・︎ 比較実験から、従来モデルを上回る精度と高速性を確認 ・︎ リアルタイム性が求められるようなビジネスシーンでの活用可能性

プレスリリースの概要

オーダーメイドによるAI・人工知能ソリューション『カスタムAI』の開発・提供およびコンサルティング事業を展開する株式会社Laboro.AI(ラボロエーアイ、東京都中央区、代表取締役CEO椎橋徹夫・代表取締役CTO藤原弘将。以下、当社)は、本年4月公開の自然言語処理アルゴリズムBERTを用いて開発した当社オリジナル日本語版BERTモデルに蒸留を施し、より一層の軽量・高速化を図った言語モデル『Laboro DistilBERT(ラボロディスティルバート)』を開発し、非商用途にオープンソースとして公開いたしました。

当社実験の結果では、蒸留前モデルの約98%の精度を保ちながらも処理時間を約60%短縮できたことを確認いたしました。また、従来一般公開されていた日本語版BERTの蒸留モデルと比較しても、それを上回る精度が発揮されたことを確認いたしました。

当社では今後も、AIに関わる各種技術領域での研究開発に取り組んでいくほか、機械学習技術を用いたオーダーメイドAIソリューション『カスタムAI』をより多くの産業の企業様に導入いいただくことを目指すとともに、イノベーション創出のパートナーとして引き続き精進してまいります。

本件について詳細は、下記もしくはこちらのPDF版プレスリリース(全文)からご確認いただけます。

https://prtimes.jp/a/?f=d27192-20201218-9503.pdf

背景 – BERTの課題

2018年10月にGoogleが発表した自然言語処理モデルBERT(Bidirectional Encoder Representations from Transformers)は、自然言語処理に大きなブレイクスルーをもたらしたと言われるアルゴリズムですが、一方で、そのベースモデルには1億1千万にも及ぶパラメーターが含まれるなど、その実装のためには大規模な情報処理環境が必要となります。

そこで、大規模なモデルを教師モデルとして学習させパラメーター数を圧縮する蒸留(distillation)という手法を施したDistilBERTが、2019年10月に公開されています。元論文では、DistilBERTはBERTの精度を97%の精度で保ちながらも60%の高速化を実現したことが報告されています。

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

※DistilBERTについては詳しくは、元論文 ”DistilBERT, a distilled version of BERT: smaller, faster, cheaper and lighter” (https://arxiv.org/abs/1910.01108)でご確認いただけます。

開発内容 – Laboro DistilBERTについて

当社では、主に英文への対応が中心であったBERTを国内でも活用いただきやすくすることを目指し、日本語文章に対応した独自のBERT事前学習モデル『Laboro BERT』を、本年4月にオープンソースとして公開しています。そして今般、このLaboro BERTに蒸留を行った『Laboro DistilBERT』を開発し、同じく非商用途に公開することといたしました。Laboro DistilBERTは、新たに取得した13GBの日本語コーパスによって事前学習させたLaboro BERTを教師モデルにした蒸留モデルです。

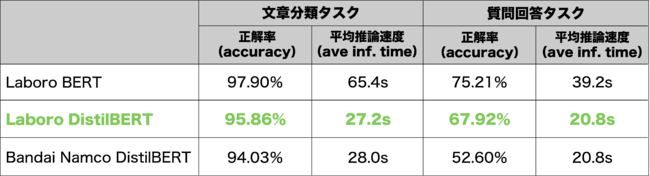

Laboro DistilBERTの性能評価のため、文章分類と質問回答の2つのタスクで評価を実施しました。この際、比較対象として教師モデルであるLaboro BERTに加え、日本語の蒸留BERTモデルとして知られる株式会社バンダイナムコ研究所が公開するモデル(以下、Bandai Namco DistilBERT)の計3モデルで比較を行っています。その結果、まず文章分類タスクにおいては、Laboro DistilBERTがLaboro BERTの精度(正解率:accuracy)の98%を保ちつつ速度(推論時間:inference time)を58%削減したことを確認いたしました。また質問回答タスクでは、90%の精度維持と47%の速度削減を確認いたしました。さらにBandai Namco DistilBERTに対しては、いずれのタスクにおいても精度・速度ともに上回る結果を確認いたしました。

(Laboro DistilBERTの性能評価実験の結果)

- - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - - -

※本年4月公開のLaboro BERTについては、当社ホームページ(https://laboro.ai/activity/column/engineer/laboro-bert/)にてご確認いただけます。

※Bandai Namco DistilBERTについては、株式会社バンダイナムコ研究所が公開するGitHub(https://github.com/BandaiNamcoResearchInc/DistilBERT-base-jp)にてご確認いただけます。

今後の展開 – Laboro DistilBERTの活用可能性

Laboro DistilBERTは、高い精度と早いレスポンスの双方が求められる、以下のようなシーンでの活用が期待されます。

・スマートフォンをはじめとするエッジ端末上での自然言語処理

・スピーディーな反応が求められる双方向コミュニケーション

・低コスト条件とリアルタイム性が重視される言語モデルへの活用

Laboro DistilBERTのご利用について

Laboro DistilBERTは、国際的な著作権ライセンスであるクリエイティブコモンズのCC BY-NC 4.0(Attribution - NonCommercial 4.0 International)の下で利用いただくことができ、非商用目的に限り無料で公開しております。利用詳細およびダウンロードは、下記の当社ホームページ内にてご確認いただけます。

<Laboro DistilBERTについて>

https://laboro.ai/activity/column/engineer/laboro-distilbert/

なお、商用目的での利用をご希望の場合は、当社ホームページのお問い合わせフォームからのご連絡をお願いしております。

株式会社Laboro.AIについて

株式会社Laboro.AIは、オーダーメイドのAIソリューション『カスタムAI』の開発・提供を事業とし、アカデミア(学術分野)で研究される先端のAI・機械学習技術をビジネスへとつなぎ届け、すべての産業の新たな姿をつくることをミッションに掲げています。業界に隔たりなく、様々な企業のコアビジネスの改革を支援しており、その専門性から支持を得る国内有数のAIスペシャリスト集団です。

<会社概要>

社 名:株式会社Laboro.AI(ラボロ エーアイ)

事 業:機械学習を活用したオーダーメイドAI開発、およびその導入のためのコンサルティング

所在地:〒104-0061 東京都中央区銀座8丁目11-1 GINZA GS BLD.2 3F

代表者:代表取締役CEO 椎橋徹夫・代表取締役CTO 藤原弘将

設 立:2016年4月1日

URL : https://laboro.ai/