今回のAIプロセッサーの昨今は、8月に開催されたHot Chips 32でAlibaba Groupが発表したHanguang 800シリーズを紹介する。

メガプラットフォーマーが自前でプロセッサーを

用意するのは当たり前の時代になった

いきなり余談だが、Alibaba GroupはHotChips 32で3件の発表を行なっている。1 つがこれであるが、他にAlibaba CloudによるX-Dragonというクラウドプラットフォーム用SoC、それとAlibaba Groupのファブレス半導体メーカーであるT-HEADによるXuantie-910というRISC-Vベースのプロセッサーである。

最近GAFA+BATH(Baidu・Alibaba・Tensent・Huawei)などという言葉も流行っているが、Alibabaはもう立派なメガプラットフォーマーであり、こうなってくると機械学習に特化したGoogleの自社開発プロセッサーであるGoogle TPUと同じように「自社専用でプロセッサーを作っても、十分ペイできる」という状況が発生する。

Google TPUは一部市販などもされているが、Hanguang 800シリーズはAlibaba Group内での利用に留まっており、それでも開発費や生産コストで十分元が取れるという、ここまで紹介してきたAIチップ(Google TPUを除く)とはやや様相の異なるビジネスモデルが成立している格好だ。

さらに余談になるが、今回Hanguang 800の説明はAlibaba Groupとして開催されたが、チップの開発そのものはXuantie-910と同じくAlibaba子会社のT-Head(Pingtouge Semiconductor、平?哥半?体有限公司)で行なわれている。

これはHuaweiの半導体が、実際にはHuawei子会社のHiSiliconで設計・製造されているのと同じような図式である。実際T-Headのウェブサイトでは、Hanguang 800が並んで掲載されていたりする。

こうした話は別にBATHだけではない。AWS(Amazon Web Services)も、インテルやAMD、NVIDIAのCPU/GPUを利用したインスタンスを立ち上げる一方で、イスラエルのファブレスCPUメーカーだったAnnapurna Labを2015年に買収。ここで設計・製造したGraviton/Graviton 2プロセッサーをAWSで採用しており、さらに2018年には推論専用チップとしてAWS Inferentiaを2018年に発表、2019年からこれを利用したサービスを始めている。

今年、AWSが開いたre:inventというイベントでは、学習用チップとしてTrainiumという新しいプロセッサーを発表しており、2021年中に利用可能状態になるとする。もうメガプラットフォーマーは、自分でプロセッサーを用意するのが当たり前の時代になりつつあるわけだ。

性能より総保有コストを最優先に設計された

Hanguang 800

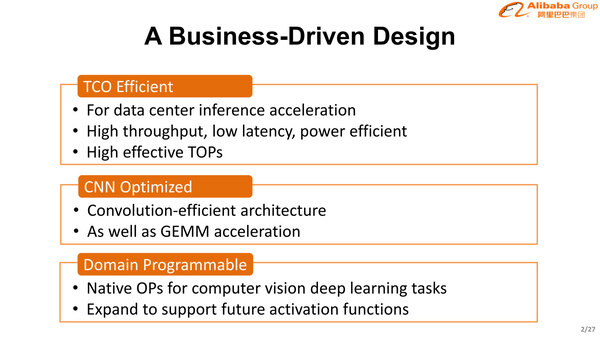

ということで話をHanguang 800に戻そう。Hanguang 800そのものは2019年に発表はされていたが、Hot Chips 32で詳細が明らかになった。そのHanguang 800の設計目標が下の画像だ。

Hanguang 800の設計目標。まずTCO(Total Cost of Ownership:総保有コスト)が最優先で、次にCNN(畳み込みニューラルネットワーク)の高速化、最後にプログラミングしやすさが来るという、ある意味わかりやすい目標

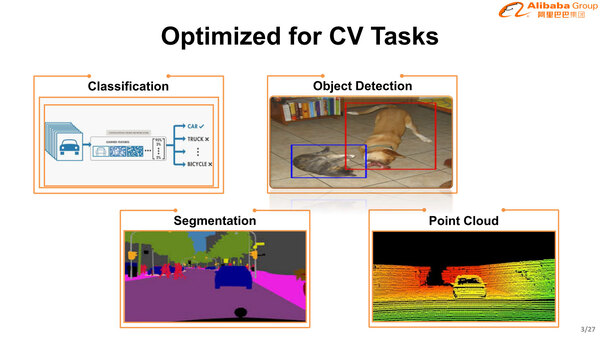

TCOといっても、設計・製造コストや廃棄コストはそんなに他の製品と大きくは変わらないので、必然的に性能/消費電力比が一番重要になる。実際、稼働中の消費電力が一番コストに効いてくるからだ。また利用できる処理もある意味割り切った。

AIでは新しい技術がかなり頻繁に登場するため、ある程度演算器の構成などに柔軟性を持たせることで今後登場する技術にも対応できるようにする配慮が必要であるが、Hanguang 800はある意味「設計時点で見えている技術に最適化する」という、割り切った構成になっている。

この連載の記事

-

第865回

PC

1400WのモンスターGPU「Instinct MI350」の正体、AMDが選んだ効率を捨ててでも1.9倍の性能向上を獲る戦略 -

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 - この連載の一覧へ