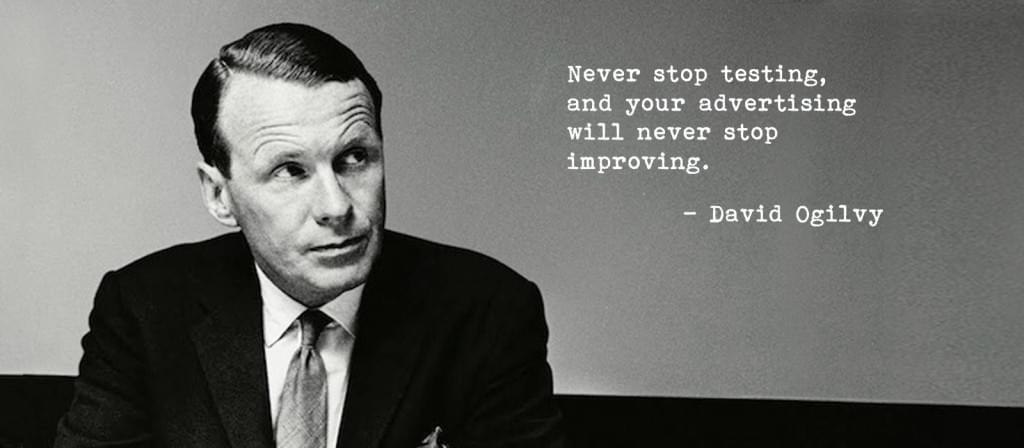

近代広告の父として知られるデイヴィッド・オグルヴィは「試行を止めてはいけない、そうすれば広告は進化し続ける」と言いました。2008年、ビル・ゲイツは「私たちはこれまでよりも、もっとA/Bテストをするべきだ」と主張しました。

今から50年前、デイヴィッド・オグルヴィは、全身ツイード地の細身のスーツを身にまとい、オックスフォード出身者の教養を漂わせ、絶え間なくタバコを吸いながら、有名な「試行を止めてはいけない、そうすれば広告は進化し続ける」と自信に満ちた表情で語ったのです

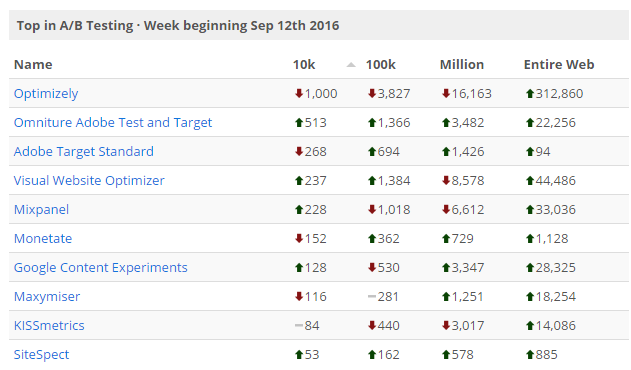

最近のWebの世界では、さまざまな使いやすいツールのおかげで、A/Bテストやコンバージョンの最適化はより身近で、手を出しやすくなっています。33万を超えるアクティブなWebサイトがA/BテストツールOptimizelyを使い、7万8000を超えるアクティブなサイトが同じくA/BテストツールのVisual Website Optimizerを使っています。間違いなくA/Bテストは普及してきています。約1万2000の代表的なオンラインでビジネスをしている企業が、これらの人気サービスを使用しています。

2016年9月時点でBuiltWithのA/B テストツールの使用率に掲載された数値。Optimizelyがトラフィック数およびWebサイト数(SMEなどの小さなサイトも含む)の両方でトップになっています

A/Bテストがおばあちゃんでも始められるくらい簡単になり、ソフトウェアが急増したにも関わらず、UserTesting.comによると90%のA/Bテストが失敗しています。VWOによる同様の調査では、7つのA/Bテストのうち1つ(14%)しか満足のいく結果が得られないことが判明しています。これはたった1割のテストしかコンバージョンレートの改善に貢献しているだけで、ほとんどの場合、もっとも重要な指標(オンラインでの購入、利益、申し込み)へのインパクトはさらに小さいのです。

これらの批判は、単にA/Bテストへの実態のない誇大広告でしょうか? そうではありません。A/Bテストは単に間違えやすいということです。今回はこの5年間、多くのグローバルブランド(小さい会社も含め)でA/Bテストをして得た知見を紹介します。

暗記テスト

学校でテストに合格するために、先生が生徒に答えや語句を記憶させたいと思ったとき、シンプルな方法として丸暗記がありました。

これをA/Bテストに当てはめると、A/Bテストのケーススタディやブログをちらっと見て、なにも考えずに、わざわざ訪れてくれたユーザーがいる自分のサイトで同じようなテストをすることになります。

A/Bテストについてケーススタディやブログを検索すると、極端に安易なアイデア(もしくは限定的過ぎたり、曖昧なもの)に出くわします。

- CTAは目に付きやすいページ上部に置く!

- 動画はコンバージョンが良い!

- キャッチコピーは短いより長い方が良い!

- キャッチコピーは長いより短い方が良い!

- 購買ステップは複数ページよりも1ページが良い!

- 複数ページの購買ステップは1ページよりも効果が良い!

- フォーム入力は「常に」少ない方が良い!

上のようにA/Bテストを実施し、その通りになったことも、そうでなかったこともあります(さまざまなマーケットやターゲットで実施しました)。

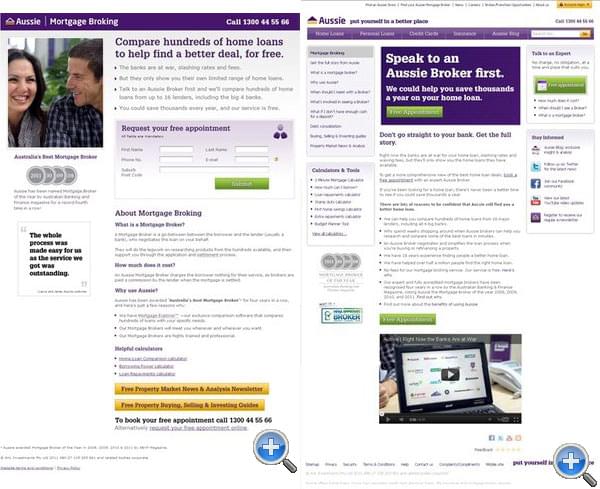

WhichTestWonで掲載されている事例を紹介します。オーストラリアの住宅ローン業者のサイトで、対称はオーストラリア人、動画も含めたA/Bテスト(ほかにもいろいろなテストはありました)を実施しました。

よくWebサイト内の動画が、どんな場合でも効果的であるかのようなことを耳にします。これに反して、テストでは動画なしのバージョンのほうが64%も多くの申し込みがありました。

もしA/Bテストを丸暗記のパターンで実施してしまうと、コンバージョンレートを改善したり、現状のA/Bテストより良い成果を出すことは難しいでしょう。

これまでに説明したような安易な考えでは、A/Bテストで最適な結果を出せません。

A/Bテストを実用的なサンプル数(実施後に事例として紹介できるくらいの数)で実施すると分かりますが、人は、そこまで単純ではありません。それぞれ、まったく違います。独自の夢や希望、野望、ゴール、欲求、個性、問題、精神をそれぞれ持っているのです。

ショットガン テスト

過去の多くの組織が夢中になって実施したA/Bテストを見ると、「ショットガンテスト」と呼ぶ現象に出くわします。

A/Bテストの結果を最大限にするために、A/Bテストのスピード、1テストあたりの平均インパクト、元のサイトよりコンバージョンレートが上回る可能性(勝率)を改善するべきです。高い平均インパクトや低い勝率でスピード感のあるA/Bテストを、ショットガンテストと呼んでいます。

最適化チームがスピード感を持ってA/Bテストをしているにも関わらず、勝率とインパクトがひどいときはショットガンテストです。最適化チームは、サイト上にあるすべてのコンテンツをテストし、あっという間にものすごい量のアウトプットをします。しかし、それぞれの結果をレビューするとき、壁に大量なものを投げて、なにか突き刺さることを期待しているかのように思えるでしょう。

ときどき、「少なくともなにかは学んでいる」という意見を耳にするでしょう(事実でもあります)。しかし、その学びにビジネス上のインパクトがない限り、価値はありません。

ショットガンテストが普及している企業では、ほとんどのテスト項目が本当に影響があるかどうかを議論されていません。多くの人はWhichTestWonを聞いたこともなく、テストのアイデアを出す際の方法論も持っていません(Web Marketing ROIで使っている手法を思いついたきっかけです)。

恐怖のボタンのカラーテスト

テストのアイデアは簡単に思いつきます。しかし、ターゲットユーザーに対して影響の大きいテストを思いついて、実施することは難しいのです。

単にボタンのラベルを変えただけでCTRが77%向上した話やグーグルが青色の影を41パターン試した結果、1番効果的な色を見つけた話を聞いたとき、このようなテストは実行するのが簡単で、常に良い結果をもたらしてくれると考えてしまいます。

しかし、それは事実とは程遠いのです。

大きな成果を上げるために、大きく考えることが大切です。小さく変更していてはいけません。もしA/Bテストが数行のjQueryだけで実装できてしまうなら、それは小さすぎます。

ユーザーを思い浮かべてください。彼らはなにを求めているのでしょうか。我々が想定しているものでしょうか。事実を知っているでしょうか。自分が提供できる価値はなにでしょうか。キャッチコピーで明確な表現ができているでしょうか。市場の中で、理想的な提供価値はどうあるべきでしょうか。もし分からないなら、HotjarやQualarooを使って、サンクスページで「今日、購入/登録をしなかった1番大きい要因はなにでしょうか?」と尋ねてください。

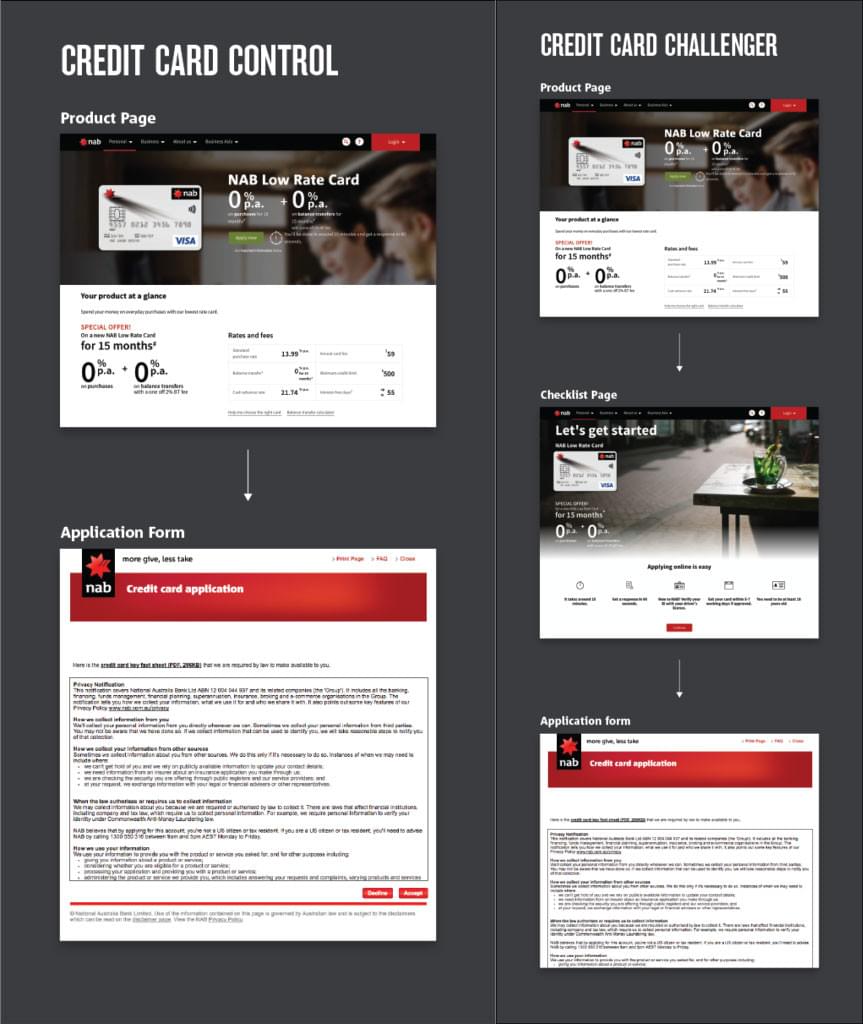

WhichTestWonにあるこちらの例を見てください、ナショナルオーストラリア銀行(NBA)の2つのサインアップフローが紹介されています。

さて、どちらのサインアップフローが勝ったでしょうか。答えは2つ目です。WhichTestWonのユーザーのうち約40%の人が誤って「Credit Card Control(Version A)」が勝つと予想しました。結果として、コンバージョンが23.6%上昇し、全体の訪問者に対する申し込みの割合は9.5%上昇しました。この事例は、ユーザーの行動を予想することが難しいという事実を示すとても良い例です。

ホームランを狙う

ほかのサイトで結果が良かったA/Bテストを参考にしたい気持ちは分かります。しかし、それは災いの始まりです。

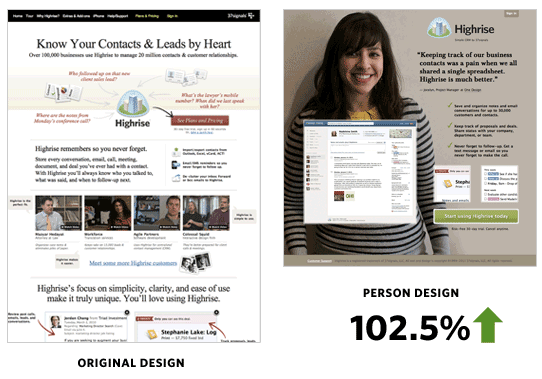

37signalsがHighriseのコンバージョンレートを上げようとしたとき、彼らは以下のようなまったく異なったホームページを用意しました。

その結果、102.50%コンバージョンレートが上昇しました。彼らはCTAや見出しを変更しただけではありません。まったく違ったページを(専門家の意見をもとに効果が出るように)デザインして、次の項目を変えました。

- 見出し

- キャッチコピー

- 背景画像

- 全体の見た目のデザイン

- CTAの文言

- CTAの色

- 製品の価値の伝え方

そしてうまくいきました。大成功です。サインアップの数は同じトラフィックあたり2倍になりました。もしかしたら大失敗していたかもしれません。しかし大きく狙わなければ、大きなリターンは望めません。それに、細かい統計に悩まされなくて済むこともメリットの1つです。

統計的に失敗しやすい点

ここまで、ほとんどA/Bテストの心理学について話してきました。どうやって適切なユーザーを惹きつけて、コンバージョンさせるかを。しかし、テスト自体はどうでしょうか。もっとも間違いやすいの次の2点です。

- テストの期間が短すぎる

- サンプルの数が少なすぎる

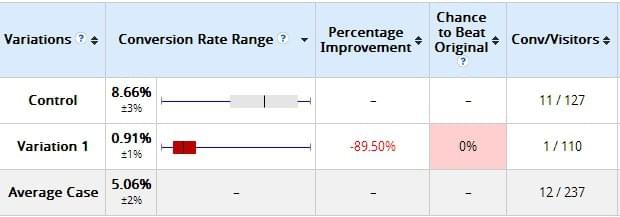

もし新しくA/Bテストを実施して、最初の数日にかなりの数のテストをした場合、よくあるシナリオとして、以下のようにひどい失敗になります。

上のスクリーンショットはVWOで紹介されているテストで、Variation1というテストが大失敗していることが分かります。90%近く失敗しています。

A/Bテストが目新しいときは、実施しているテストを止めて新しいものを試したいという誘惑があります。

A/Bテストの(統計的にも言われている)究極のルールは、テスト期間を短くしすぎないことです。同じテストをさらに1週間(失敗しそうなとき、テストを実施し続けるには強い気持ちとデータの精度に対する献身的な精神が必要です)、もしくは十分な期間かけて実施すると、以下のように結果が現れました。

10日後、ひどい状態だったテストは、元のサイトよりコンバージョンレートが上回る可能性95%の勝率を維持してフルスピードで動いていました。この事例は、テスト期間を短く設定しすぎると、正しい結果が得られないことを示しています。

実施前にテストの最短期間を(予想トラフィック数をもとに)設定することを勧めます。

もし疑うなら(もしくは結果が良すぎて信じられないなら)、新規のA/Bテストとしてまったく同様のテストを実施してみてください。

正しくA/Bテストをする

A/Bテストを始めるとき、小さく変えていくことや1度に1つ変えることは、とても良いことです。しかしA/Bテストで本当に重要な結果を得るためには、ユーザーを正確に捉え、大胆に変え、十分な数のサンプルと期間でテストすることが必要です。

もし結果が良さそうなら、再度テストすることを恐れてはいけません。A/Aテストも重要です。

Webサイトのゴールと、そのゴールに沿ってユーザーにどのようなアクションをして欲しくて、そのあとにどのような行動が予想できるかをよく理解する時間を取ることによって、成功するA/Bテストのスタートラインに立てます。そして、その過程で競合に差を付けられます。

(原文:A/B Testing: Here’s How You Could Be Doing It Wrong)

[翻訳:萩原伸悟/編集:Livit]