ロードマップでわかる!当世プロセッサー事情 第855回

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術

2025年12月22日 12時00分更新

前回はサーバーラックをNVL72に特化する形で説明したが、そもそもHot Chips初日の午前中は、7本ものサーバーラック向けセッションが行なわれた。

Hot Chips初日午前中に開催された

サーバーラック向けチュートリアル・セッション一覧

2. Scaling fabric technologies(Darrin Vallis, AMD)

3. Liquid cooling with Google Characteristics(Jorge Padilla, Google)

4. Rearchitected power systems(Harsha Bojja, Microsoft)

5. Case study: Nvidia GB200NVL72(John Norton, NVIDIA)

6. Case study: Meta's Catalina(William Arnold & Matt Bowman, Meta)

7. Case study: Google TPU Rack(Pankaj Makhija, Google)

前回はこの5.と6.をまとめて説明したが、残りのセッションの内容をまとめる形で、最近のデータセンター向けラックのトレンドを解説したい。

急速に跳ね上がった消費電力

単三乾電池程度の直径だった配線が350mmのジュース缶サイズに!

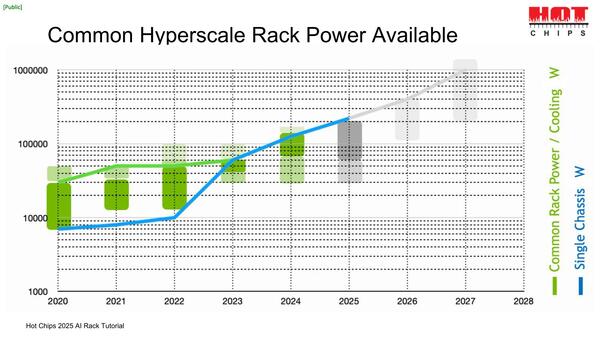

生成AIが登場した2022年末から、急激にデータセンターにおける消費電力が増え始めた。下の画像はラックあたりの消費電力の実績と予測だ。

水色がAIデータセンター向けのもの、緑は「一般的な」データセンター向けラックの消費電力で、2020年にはラックあたり30kW程度だったのが2023年には50kWくらいまで増えている。

CPUが主体のデータセンターラックはだいたいこの程度で、GPUが入るラックは120kW程度と言われていたのが、2024年には150kWが当たり前となり、2025年には200kWを超えるところまで消費電力が増えているという状況だ。

前回も少し触れたのだがRubin Ultraはラックあたり600kWに達すると予告があり、別のロードマップでは1MWに達するという話になっている。

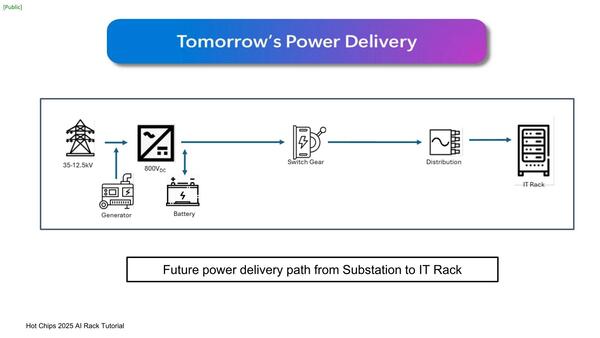

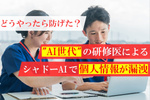

さてそのラックへの電力供給であるが、従来の一般的なシステムでは高圧線から電力を引き込み、AC200V前後の形でラックに供給、ラック内で54V DCに変換した上でラック内のシャーシに供給するというパターンであった。

本当に必要なのは48Vであるが、多少電圧変動があることを前提に54V程度に降圧し、最後にシャーシ内で48Vに落として分配する形になる。こうすれば、54Vが例えば50V位に下振れしても48Vを維持できるからだ

ところが例えば200Vで600kWを供給しようとすると、電流は3000Aとかいう化け物のような電流が流れることになる。配線にともなう電力損失は電流に比例するので、例えば分電盤(上の画像のDistribution)からラックまでの配線抵抗が1Ωだったとしても、配線損失がシャレにならない。

そこで分電盤からラックまでの電圧を800Vに引き上げたうえで、さらにDC化しよう、というのが今後のトレンドである。理由は配線抵抗による損失を少しでも減らすためだ。配線損失は電流の2乗に比例するから、少しでも電流を減らすことで配線損失を減らしたいわけだ。

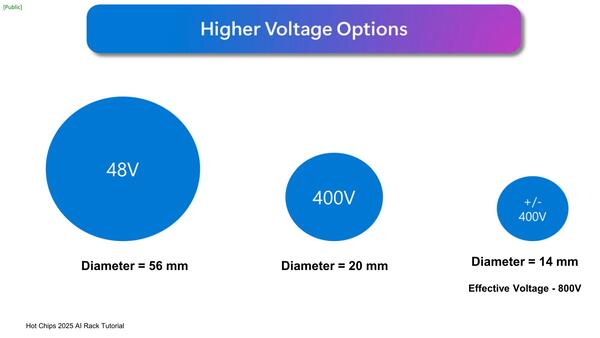

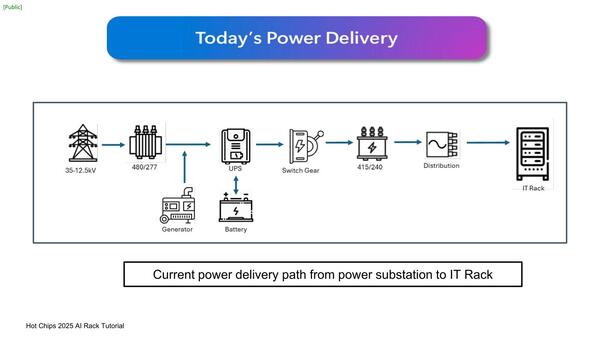

もう1つの理由は、もはや48Vでは配線が困難なためである。下の画像は500kWの電力供給に必要な配線の太さを示したものである。

直径56mmの配線というのはさすがに非現実的すぎる。といっても実感が湧かないだろうということで示されたのが下の画像。

厳密に言えば若干数字は異なるのだが、対比という意味ではジュース缶と単三乾電池程度の比だと思えばよい。ちなみにこれは配線内の銅線の直径で、この外に絶縁や保護用の外皮がつくから、配線そのものはもっと太くなる

56mmというのは350mmのジュース缶サイズ、14mmというのは単三電池のサイズである。ジュース缶サイズの配線が這い回る光景はどう考えても現実的ではない。

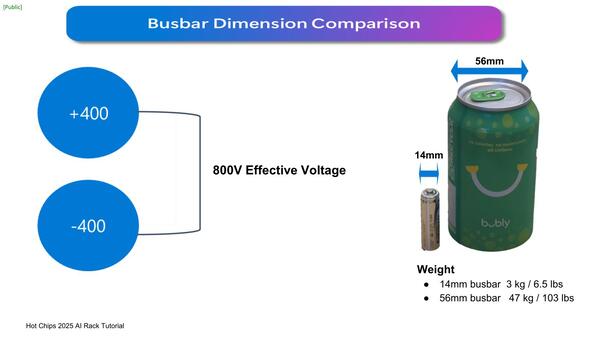

ただし、高密度サーバーになると、もうラック内に電源ユニットを収めるのは難しくなるので、サーバーラックの脇に電源供給用のラックを並べよう、というのがOCP(Open Compute Project)でMt.Diabloとして標準化が進められている案である。

800V→48Vの変換に要する電源部の体積がより大きくなることに加え、BBU(Battery Backup Unit:UPSのような電源断時に電力を供給するバッテリー)やCBU(Capacitor Bank Unit:大容量コンデンサーを利用した、瞬電のようなわずかな時間の電源断に対応するための装置)などもより大容量が必要になる関係で、もう別のラックに収めないと間に合わなくなってきた

左側が電源用のSidecarで、右がCompute Rackとなっているが、左右を反転させることは別に問題はない。Diablo 400は現在Version 0.5の仕様が公開されている

こうした構成により、電力供給に関するロスを従来構成と比較して7~10%削減できる、と見積もられている。

ちなみにラックあたり600kWや1MWと、おそろしい数字が出ているわけだが、600kWのラックを500本並べればそれだけで300MW、1MWクラスのラックを1000本並べると1GWになる。

10月にAMDがOpen AIとの間でトータル6GW分のGPUを納入する契約を結んだことを発表したが、AMDのHeliosが多くても1万ラック前後でこの6GW分相当になる計算だ。なかなかにおそろしい。

この連載の記事

-

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 -

第853回

PC

7つのカメラと高度な6DOF・Depthセンサー搭載、Meta Orionが切り開く没入感抜群の新ARスマートグラス技術 -

第852回

PC

Google最新TPU「Ironwood」は前世代比4.7倍の性能向上かつ160Wの低消費電力で圧倒的省エネを実現 -

第851回

PC

Instinct MI400/MI500登場でAI/HPC向けGPUはどう変わる? CoWoS-L採用の詳細も判明 AMD GPUロードマップ -

第850回

デジタル

Zen 6+Zen 6c、そしてZen 7へ! EPYCは256コアへ向かう AMD CPUロードマップ -

第849回

PC

d-MatrixのAIプロセッサーCorsairはNVIDIA GB200に匹敵する性能を600Wの消費電力で実現 -

第848回

PC

消えたTofinoの残響 Intel IPU E2200がつなぐイーサネットの未来 -

第847回

PC

国産プロセッサーのPEZY-SC4sが消費電力わずか212Wで高効率99.2%を記録! 次世代省電力チップの決定版に王手 -

第846回

PC

Eコア288基の次世代Xeon「Clearwater Forest」に見る効率設計の極意 インテル CPUロードマップ -

第845回

PC

最大256MB共有キャッシュ対応で大規模処理も快適! Cuzcoが実現する高性能・拡張自在なRISC-Vプロセッサーの秘密 - この連載の一覧へ