巨大GPUクラスタ「OCI Zettascale10」、データ+AIの包括基盤「AI Data Platform」など発表

オラクル“転機の年”に独自AI戦略を加速 「Oracle AI World 2025」を米国で開催

2025年10月23日 08時00分更新

“AI開発競争”には加わらないオラクルの戦略的ポジション

今回の年次イベントで、AI分野への注力姿勢を明確にしたオラクルだが、なぜ、そしてどのように、AIに注力しようとしているのか。

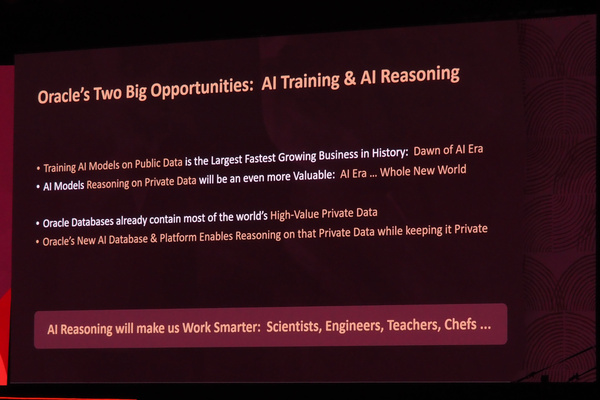

オラクルの会長でありCTOを務めるラリー・エリソン氏は、オラクルはAI分野で2つの大きな可能性を持つと説明する。「AIトレーニング」「AI推論(Reasoning)」の2つだ。1つずつ、その内容を確認してみたい。

まずは「AIトレーニング」だ。エリソン氏は、新興生成AI企業やハイパースケーラーたちが、莫大な資金をAIモデルのトレーニング(学習)に投入している現状を指して、「(AI開発は)人類史上最大で、最も急速に成長しているビジネスだ」と語る。

こうした“AI開発競争”に直接は参加せず、AI開発に取り組む企業が必要とする巨大なコンピューティングリソースを提供するというのが、現在のオラクルが取るポジションである。「オラクルは、AIトレーニングのためのデータセンター構築において重要な役割を果たしている」(エリソン氏)。

すでに一昨年には、高速なRDMA(RoCEv2)ネットワークを用いたGPUサーバークラスタである「OCI Supercluster」を発表していた(OCI:Oracle Cloud Infrastructure)。さらに昨年(2024年)には、その規模と性能を大幅に拡張し、最大13万基以上のNVIDIA Blackwell GPUで構成される、ピーク性能2.4ゼタFLOPSのZettascaleクラスタも発表、大規模な生成AIモデルを開発する企業向けに提供してきた。顧客企業には、OpenAI、Meta、xAI、Cohereといった名が並ぶ。

そして今回、新たに発表したのが、Zettascaleクラスタをさらに拡張した「OCI Zettascale10」クラスタである。OpenAIやソフトバンクなどと米国で取り組む巨大AIデータセンター「Stargate Project」において開発、導入されたアーキテクチャであり、オラクルはこれを「クラウドにおける最大のAIスーパーコンピューター」と呼んでいる。

Zettascale10は、複数のデータセンター間(半径2km以内)を高速RDMAネットワークで接続し、数十万台規模のNVIDIA GPU、マルチギガワット級のクラスタを構成するアーキテクチャだ。クラスタ全体のピーク性能は「最大16ゼッタFLOPS」を実現するという。世界最高速スパコン(現在のTOP500リスト1位)である「El Capitan」のピーク性能が2.7エクサFLOPSなので、その“およそ6000倍”という桁外れの計算性能である。

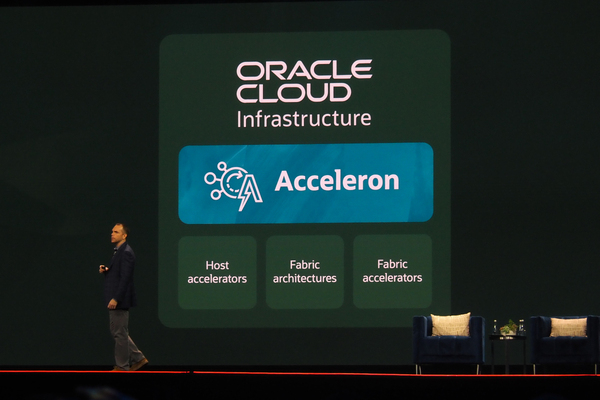

なお、このクラスタで超低遅延/広帯域/セキュアなRDMAネットワークを実現するために、オラクルでは新たに「OCI Acceleron」というネットワークアーキテクチャを開発し、Zettascale10に実装している(Acceleronの詳細については、あらためて別の記事でご紹介したい)。