キャッシュと帯域を増やすことで

処理の高速化を実現

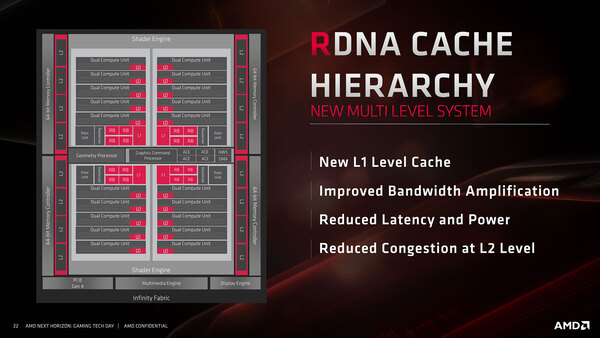

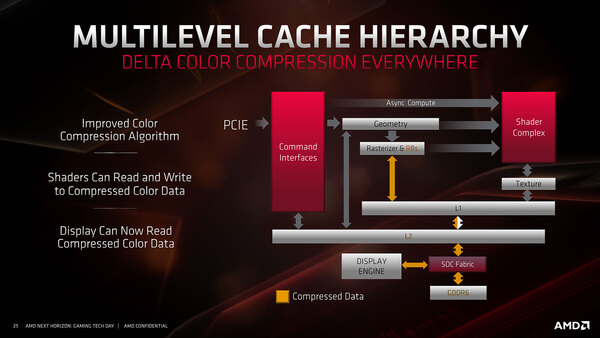

次がキャッシュシステムである。新たに1次キャッシュが追加されたほか、帯域の強化やレイテンシーの削除などが主な改良点である。

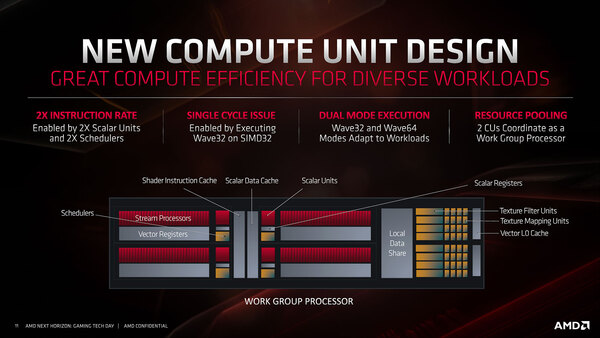

まずキャッシュの説明の前にWGP(Work Group Processor)について定義しておく。先ほどのCUの構成であるが、RDNAでは2つのCUで共有される形でシェーダーの命令キャッシュやScalar Data Cache/Local Data Shareなどが用意される。このCU×2+共有キャッシュの塊がWGPと定義される。

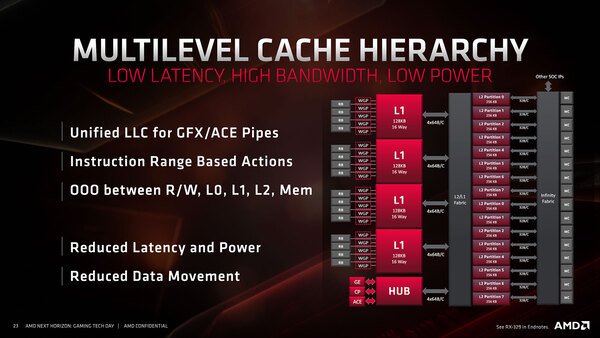

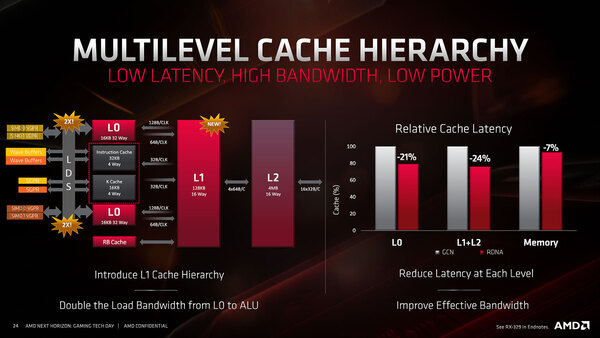

これを念頭に、1次キャッシュの構成を示したのが下の画像である。1次キャッシュには5つのWGP(=10CU)と、RB(Render Backend)が直接接続されることになっている。

実は1次キャッシュの目的は、このRBをフルに生かすための工夫ともいえる。レンダーバックエンドは描画処理の最終段階の作業を担うもので、複数のスレッドをブン回して得られた最終的な描画データを、フレームバッファにピクセル単位で出力する作業を担うことになる。

普通であれば、RBはそのまま2次キャッシュ経由でメモリーに書き出すのが効率が良いわけだが、あえてここに1次キャッシュを挟んだ理由は、Deferred Rendering(遅延レンダリング)の技法が多用されるようになってきたことに起因する。

たとえばLightingを例に取れば、従来型のレンダリング(Forward Rendering)ではオブジェクトに対してLightingの計算を行ない、その結果をラスタライズして出力を得るのに対し、Deferred Renderingでは先にラスタライズを済ませてしまい、その後でラスタライズしたデータに対して必要な箇所だけLightingを施す、という手順になる。

この方式はシェーダーの負荷が軽くなるというメリットがある半面、いったんメモリーに書き出したデータを読み出して処理し、改めて書き戻すことになるので、メモリー帯域に大きな負荷がかかる。

GCNの場合はいったんラスタライズされたデータが2次キャッシュに格納され、RBは2次キャッシュから読み出して処理し、2次キャッシュに書き戻しをし……、という形で煩雑に2次キャッシュアクセスが発生していたが、メモリーより高速とは言え2次キャッシュもそれほど高速ではない。

そこでRDNAではWGP/RBと2次キャッシュの間に1次キャッシュを挟み、RBは1次キャッシュとの間で読み出し/書き戻しを行わせることで処理の高速化を実現した形になる。

それだけでなく、1次キャッシュは0次キャッシュとも広帯域で接続することで、LDS(Local Data Share)の帯域を従来比2倍に増やしたとしており、RB関連以外の処理の高速化にも貢献している。

また、RB⇔1次キャッシュ⇔2次キャッシュ⇔メモリーのデータ転送に関してはデータ圧縮をかけており、これにより効率的に帯域を利用できるとする。

この連載の記事

-

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 -

第853回

PC

7つのカメラと高度な6DOF・Depthセンサー搭載、Meta Orionが切り開く没入感抜群の新ARスマートグラス技術 - この連載の一覧へ