AIエージェントに選択肢 「AWS re:Invent 2025」レポート 第3回

Amazon Bedrockに18のオープンウェイトモデルを追加 Amazon Nova 2も発表

3強LLMの時代、Amazon BedrockはなぜマニアックなAIの品揃えにこだわるのか?

2025年12月03日 10時30分更新

ラスベガスで開催中のAmazon Web Servicesのフラグシップイベント「AWS re:Invent 2025」。AI開発プラットフォームである「Amazon Bedrock」では、今年も選択できる基盤モデルが続々と追加された。大規模言語モデル(LLM)がOpenAI、Claude、Geminiの3強に収斂する昨今、AWSはオープンソースや新興AIプロバイダーの基盤モデルにこだわりを見せる。

Amazon Bedrockには新たに18モデルを追加 Amazon Novaもバージョンアップ

AWSのAI開発プラットフォームであるAmazon Bedrock。AWS CEOのマット・ガーマン氏が登壇した基調講演では、導入は10万社を超え、1社あたりすでに1TBのトークンがAmazon Bedrockで処理されたことがアピールされた。

Amazon Bedrockは、さまざまなLLMを選択できるのが大きな特徴だ。同社が基盤モデル(Foundation Model)と呼ぶこれらのLLMは、Claudeをはじめとする提携AIプロバイダーのクローズドモデルのほか、Meta LlamaやGemma、OpenAIのオープンソースモデル、自社開発のAmazon Nova、そして新興AIプロバイダーのモデルも選択できる。

今回、AWSはAmazon Bedrockで選択できる基盤モデルとして、18のオープンウェイトモデルを追加した。追加されたのはGoogleのGemma(4B、12B、27B)、MiniMax AIのMiniMax M2、Mistal AIのMistral Large 3(3B、8B、14B)、Magistral Small 1.2、Voxtral Mini、Voxtral Small 1.0、Moonshot AIのKimi K2 Thinking、NVIDIAのMemotron Nano 2 9B、Nano VL 12B、OpenAIのgpt-oss-safeguard-20b、gpt-oss-safeguard-120b、QwenのQwen3-Next-80B-A3B、Qwen3-VL-235-A22Bの18モデルになる。

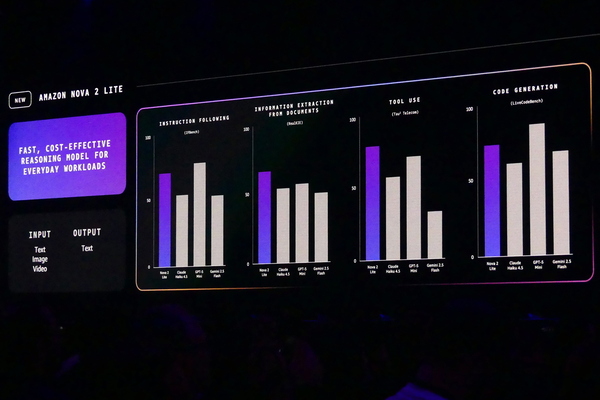

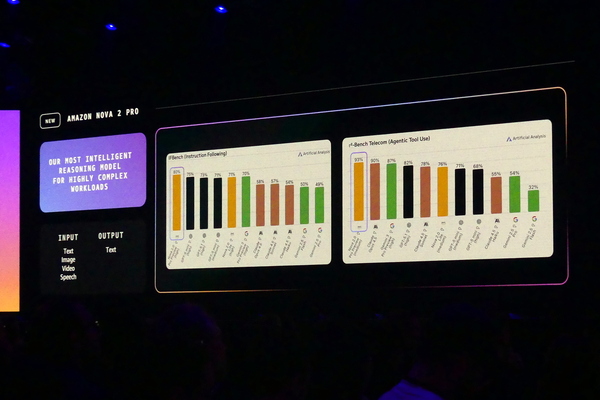

また、昨年発表されたAmazon Novaもバージョンアップし、業界最高の価格性能比を謳うAmazon Nova 2となった。日常利用に適したコスト効果の高い「Nova 2 Lite」、複数ステップの複雑なタスクに適した「Nova 2 Pro」、音声ベースの会話AIに最適な「Nova 2 Sonic」、テキスト、画像、音声、動画の入力からテキストと画像の両方を生成する「Nova 2 Omini」など幅広いラインナップを誇る。基調講演ではGPT、Claude、Geminiなどと比較したベンチマークも披露され、自信のほどが伺える。

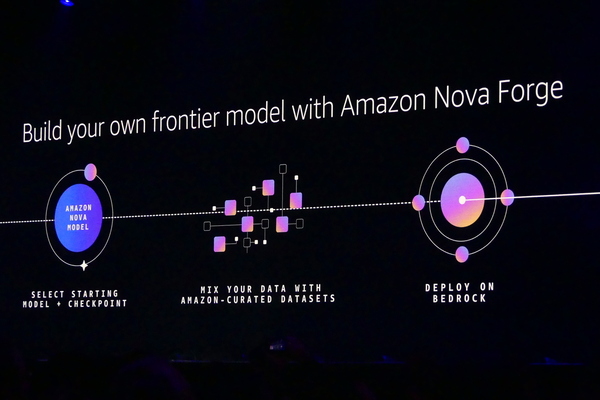

Amazon Novaを利用して、独自のモデルを構築できる「Amazon Nova Forge」も発表された。Amazon Novaのトレーニングにおけるチェックポイントを始点として、Amazon Sage Maker AIを使って、オープンモデルより容易にモデルを構築できる。報酬関数を利用した強化ファインチューニングや、組み込み済みのResponsible AIツールキットを用いたガードレールを構築することも可能だ。

モデルを選択できる自由は大きな差別化要因

AWSは毎年のようにAmazon Bedrockの基盤モデルを増やし続けてきた。今回のAWS re:Invent 2025においても、新しいモデルがかなり追加された。ここで気になるのは、Poolside、Mistral AI、A21 Labs、TwelveLabs、WRITERなど日本でも知名度のないマニアックなLLMを今も追加し続けていることである。

生成AIブームから3年が経ち、大規模言語モデルの市場は事実上OpenAIのGPT系、AnthropicのClaude、GoogleのGeminiの3強に収斂しつつある。精度面の進化が緩やかになり、マルチモーダル対応や開発の自動化、セキュリティなどの実装が進んできたこともあり、LLM自体の差別化は以前に比べて難しくなっている。担当直入に言えば、3強を選べれば、だいたいのニーズがカバーできる状況にある。

この理由はなにか? もちろん「多彩な品揃えはAmazonの持つ小売のDNA」と言えば、多くのユーザーが納得する説明にはなる。ベストセラーだけでなく、ロングテール化しそうな多彩な選択肢を顧客に提供するのは小売の基本。実際、re:Invent 2025の展示会場を見れば、今も新興のAIプロバイダーは雨後の筍のごとく増えている。同社のサイトでもVercelやVeoriaの事例を元に、複数のモデルの中から選択できる重要さをアピールしている。

もちろん、OpenAI中心のマイクロソフト、Geminiを自社開発するGoogleに対する差別化として、基盤モデルの選択肢を重視しているという理由もある。もう1つ理由を挙げるとすれば、AIプロバイダーがAWSの優良顧客である点だ。現にClaudeを提供するAnthropicは、AWSのチップを搭載したUltraServersで自社サービスの強化を行なっている。さらにAWSはOpenAIが開発基盤に関して大型の提携を発表している(関連記事:AWS、OpenAIと5兆円超の提携 ChatGPTの開発基盤に)。

寡占が進むLLMの市場の中で、AWSがマルチ基盤戦略をとり続けるのかは不透明だ。ただ、基調講演を聴いた限り、「自由な選択肢を提供する」という同社の意思はかなり力強いと感じられた。精度面でのLLMの進化が頭打ちになれば、ユーザーは同じ性能でよりコストパフォーマンスの高いLLMの選択を重視するようになる。今後、大化けするかもしれないAIプロバイダーにつばを付けておくという意味でも、マルチ基盤戦略は意味があるのかもしれない。

AWS re:Invent 2025の現地レポートは引き続きお送りする。

この連載の記事

-

第13回

ビジネス・開発

ありがとうヴァーナー 「自らの仕事に誇りを持て」は働くすべての人に向けたエール -

第12回

ビジネス・開発

AIに「丸投げ」は厳禁 AWSのIDE「Kiro」はなぜ仕様駆動型開発に行き着いたのか? -

第11回

ビジネス・開発

ダ・ヴィンチに学べ AI時代に求められる「ルネサンス・デベロッパー」という生き方 -

第10回

ビジネス・開発

Amazon ボーガスCTOが最後の基調講演 「AIは開発者の仕事を奪うのか?」への直球な答え -

第9回

クラウド

推論ワークロードの時代 20年積み上げてきたAWSのビルディングブロックは通用するのか? -

第8回

TECH

ラスベガスで珠玉のインドカレー こりゃあ店も混むわけだ -

第7回

クラウド

200万人が視聴し、6万人がラスベガスに集ったre:Invent 2025 4つの基調講演で見えたAWSの進む道 -

第6回

ビジネス・開発

1人で100機のロケットを打ち上げるため、Blue OriginにはAIエージェントが必要だった -

第5回

クラウド

教えて、ほめて、注意して AWSが考える「本番に強いAIエージェントの育て方」 -

第4回

クラウド

AWSガーマンCEOが10分で怒濤の新発表25連発 LTチャレンジにレガシーAWSファンも大歓声 - この連載の一覧へ