NVIDIA提携によるAIプライベートクラウドのターンキーソリューション、今後の戦略は

HPEが“AIファクトリー”を強化、競合との差別化ポイントを担当幹部に聞く

2025年08月14日 09時00分更新

Hewlett Packard Enterprise(HPE)は、2025年6月末に開催された年次イベント「HPE Discover Las Vegas 2025」で、AI戦略をさらに一歩進めた。NVIDIAとの提携で実現する“AI factory”ポートフォリオの拡充、データ主権(ソブリン)への対応が、その主な内容だ。

今回はHPE Discoverの会場で、プライベートクラウドソリューションの担当幹部であるシェリ・ウィリアムズ氏に、HPE AI factoryを中心とした戦略について聞いた。

――HPE Discoverで強化されたAI factoryについて教えてください。

ウィリアムズ氏:HPEのAI factoryは、顧客企業が自社のAI導入フェーズにあわせて活用できるソリューションです。

NVIDIAと共同開発した「HPE Private Cloud AI(以下、PC AI)」を基盤として、エンタープライズが即時オンプレミス導入できるターンキー型、モデルビルダー(AIモデルの開発企業)やサービスプロバイダー向けのスケーラビリティ重視型など、導入目的に応じたタイプを用意しています。そして、どのタイプをを選んでも、インフラ、ソフトウェア、サービス、持続性のための機能、そしてエコシステムは共通しています。

今年のDiscoverでは、このPC AIにおいて、セキュアなエアギャップ実装、マルチテナントのサポート、独自のフェデレーションアーキテクチャによる複数世代のGPUのプール/共有などの機能を発表しました。「HPE ProLiant Gen12」サーバーでは、NVIDIA Blackwell GPUをサポートしたことで性能が2倍に向上したほか、ゼロトラストセキュリティの機能も追加されています。

「エアギャップ実装」は、データ主権や機密性のニーズに対応するため、外部とのネットワーク接続なしで運用できるものだ。これは9月から利用できるようになる。

――2024年秋にデータ主権のニーズに対応しました。顧客の反響はいかがですか。

ウィリアムズ氏:特に、欧州や日本で大きな関心を集めています。これまでのところは政府、防衛分野の組織が中心ですね。オンプレミスのエアギャップ環境でも、(パブリッククラウドのような)クラウド体験を実現したいという強いニーズがあり、米国やフランスではPoCも進行中です。

――ライバルであるDell Technologiesも、NVIDIAとの提携で“AI Factory”を展開しています。これと比較した、HPE独自の差別化ポイントは何でしょうか。

ウィリアムズ氏:HPEのAI factoryは製品名ではなく、ソリューションポートフォリオを指し示す言葉です。ソリューションの基準はNVIDIAが定義しており、もちろんHPEのAI facrotyはそれを満たしています。

最大の差別化要素はソフトウェアスタックです。今年のDiscoverでは、Morpheus、OpsRAMP、Zertoを含む「HPE CloudOps Software」スイートを発表しました。HPE AI factoryにもCloudOpsスイートが含まれるため、Morpheusによる環境管理やオーケストレーション、OpsRampによるモニタリングやオブザーバビリティ、Zertoによるデータ保護が利用できます。

さらに、PC AIでは「NVIDIA Enterprise AI」「NVIDIA NIM」、これらを補完する「HPE AI Essentials」も使うことができます。

――(最新世代のNVIDIA GPUだけでなく、過去世代のGPUも連携動作させることができる)フェデレーションアーキテクチャを採用しています。その理由は?

ウィリアムズ氏:NVIDIAのロードマップは常に進化しており、新世代のGPUが次々に投入されます。その結果、顧客企業がAIに投資しても、3カ月後にはそれが古くなってしまうことを意味します。

フェデレーションアーキテクチャによって、AIへの投資が長期間にわたって保護されることになります。高価なGPUへの投資が将来にわたって価値を維持し、AIエコシステムからメリットを享受できることを確実にする設計です。

――OpsRampが、NVIDIA AI Factory向けのオブザーバビリティ/モニタリングソリューションとして認定を受けました。その効果や顧客メリットを教えてください。

ウィリアムズ氏:OpsRampを使えば、NVIDIA AI Factoryのリファレンスアーキテクチャに準拠したインフラを、すべて監視/可視化できることになります。HPEのハードウェアに限定されず、GPUの管理、GPU利用率の最適化、キャパシティ問題への対応も可能です。顧客企業は、AIオペレーションをよりシームレスに行えるようになります。

またHPEには、先ほど触れたCloudOpsスイートやエコシステムプログラム「Unleash AI」があります。Unleash AIプログラムでは、PC AIで約35種のISVが認定済みであり、HPE独自のAI向けISVエコシステムを構築しています。Deloitte、AccentureといったグローバルSIパートナーとも連携しています。

PC AIの導入期間短縮にも取り組んできました。現在は「受注から35日以内」にデータセンターへの導入が可能となり、パートナーによる1~2日での稼働も実現しています。

ISVパートナーの一例として、特化型AIエージェントを開発するAibleでは、米国の農業研究機関向けにPC AIでモデルを構築し、稼働させています。モデルの構築から稼働までを数日間で実現し、データサイエンティストではないユーザーでも90分以内で35個ものAIエージェントを構築できています。なおこの顧客は、農業データのソブリンティという観点から州内のプライベートクラウドを利用し、すべてのデータを保護しています。

――PC AIのようなソリューションも、導入を支援できるパートナーもあり、顧客側にはデータもあります。「すべてのパーツがそろっている」ように思えますが、企業がAIを活用するにあたっての課題はどこにあるのでしょうか。

ウィリアムズ氏:最大の課題は「データの管理」だと思います。どんなデータが必要なのか、そのデータはどこにあるのか、分散しているのか、アクセスできるのか……。これらを把握し、AIで活用する準備が支援できるパートナーが必要です。さらに、データのガバナンス、エージェントの管理や制御なども重要になってくるでしょう。

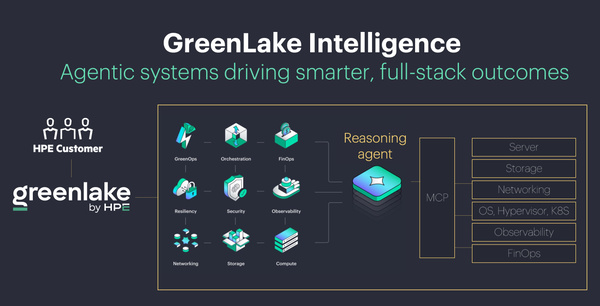

先に挙げたAibleの例からも分かるように、これからAIエージェントの構築は簡単なものになります。その結果、今後は(多数のAIエージェントをまとめる)オーケストレーションが必要になるでしょう。オーケストレーションの分野では「HPE GreenLake Intelligence」を提供しています。

――エンタープライズのデータ管理分野では、SalesforceがInformaticaを買収するなど、大きな動きが見られます。HPEはここでどのような役割を果たすのでしょうか。

ウィリアムズ氏:HPE GreenLake Intelligenceでは、データ管理を中核に据えています。GreenLake上に「Aruba Central」やストレージ(管理)システムが稼働しています。これらのシステムには長年にわたって蓄積されたデータがあり、エージェントの構築やシステム間の連携ロジックの構築に活用できます。プラットフォーム自体に、多くのデータ管理機能が組み込まれているのです。