次世代ラックスケールシステム「Kyber」を2027年に出荷予定 NVIDIAのエンタープライズ戦略

2025年05月23日 11時00分更新

AI開発を加速するクラウドプラットフォーム

「DGX Cloud Lepton」

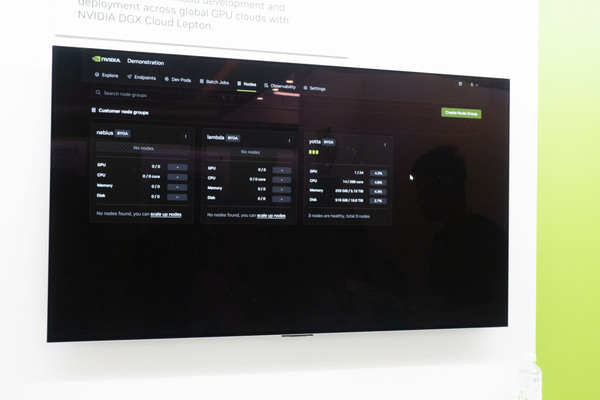

GTC Taipeiで発表された新しいクラウドソフトウェア「DGX Cloud Lepton」も紹介された。これは、AI開発者がGPUインスタンスを利用する際の環境構築時間を短縮することを目的としている。

ユーザーは、利用したいリージョンやGPUインスタンス(NBS、Lambda、YottaなどのNVIDIA Cloudパートナーから選択可能)を選択できる。BYO(Bring Your Own)アカウントやオンデマンドでのレンタルが可能である。利用するGPUの種類(H100、A100など)も選択可能。

AI開発者の多くはコンテナ環境でジョブを実行するため、自身のコンテナイメージを提供するか、Docker HubやNVIDIA Cloudなどの公開イメージから引っ張ってくることも可能だ。

NVIDIA Cloudパートナーのインフラストラクチャーは、NVIDIAのリファレンスアーキテクチャーを採用しており、最適化・標準化されているため、ユーザーはマルチGPUジョブやマルチノードジョブを容易に実行でき、大規模モデルのトレーニングにも適している。トレーニング済みのモデルは、NVIDIA NIMとしてエンドポイントに展開できる。

展開したNIMサービスは、エンドポイントを通じてテストが可能であり、ChatGPTのようなプレイグラウンド形式で質問を送信したり、API経由でリクエストを送信するといった検証が可能とのこと。

DGX Cloud Leptonの大きな利点は、GPUリソースのレンタルやコンテナサービスの展開において、IT専門家がほとんど不要であることだという。スタートアップや小規模企業のように、多くのIT専門家を抱えていない組織でも、AWSやGCPのようなクラウドサービスでGPUインスタンスを管理するために専門家を雇う必要がなく、DGX Cloud Leptonを通じて容易にリソースをレンタルし、自身の環境を展開して、AI開発ジョブやトレーニング、サービスを開始できる。

これは、データセンター向けDGXシステムと手元環境向けDGX Personal/Stationが共通のソフトウェアスタックを持つことと合わせて、AI開発・活用のハードルを下げるためのNVIDIAの包括的な取り組みを象徴していると言える。

この連載の記事

-

第53回

スマホ

クアルコムを抜いたMediaTek、6Gや新Chrombookチップ、NVIDIAとの協業をアピール -

第52回

PCパーツ

“美しさ”と“スマートさ”に注目! Phanteksの新しいPCケース/簡易・本格水冷CPUクーラーをCOMPUTEXで見てきた -

第52回

sponsored

エモいPCケースに最新パーツ搭載、SilevrStone「FLP02」でレトロなPCデスク環境を作れる! -

第51回

ケース

かなり難解。ウッドパズルのようなPCケース「Puzzle」 -

第50回

PCパーツ

無茶なことを考えたな! 3基のM.2 SSDを同時冷却できる水冷ユニット -

第49回

sponsored

be quiet!の音がしないキーボード、着脱式テンキーがおもしろい -

第48回

サーバー・ストレージ

水冷コネクターが日本製で結露が起きない! データセンター構築を簡素化するSupermicro「DCBBS」を見てきた! -

第47回

PCパーツ

Noctuaがポンプのないサイフォン式クーラーのデモを公開 -

第46回

PCパーツ

え?聞いてないよ。Noctuaから掟破りの水冷ユニットが発売予定 -

第45回

PCパーツ

XPGの新CPUクーラーは空冷・水冷それぞれの分野で最新技術と使いやすさを両立、液晶付きでビジュアル面も充実 -

第44回

デジタル

MSIってEV充電製品も出してるの? 日本でも展開予定の製品をCOMPUTEXで見てきた - この連載の一覧へ