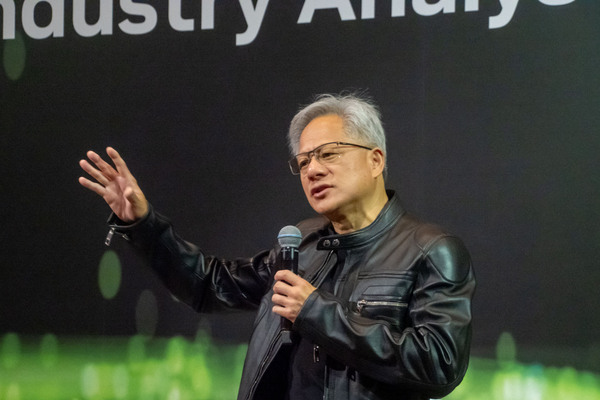

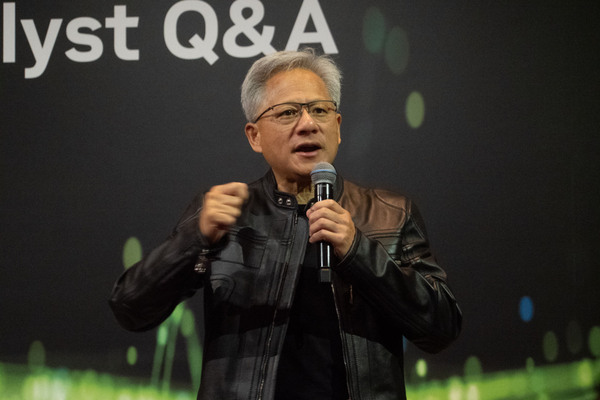

中国への輸出規制は効果がないとNVIDIA CEOが持論を展開、ヒューマノイドロボットが次の数兆ドル産業になる

2025年05月21日 20時00分更新

性能が収益に等しくなるため

機器は毎年アップグレードする

AI工場における機器の寿命とアップグレード頻度について質問が出た。ファン氏は毎年アップグレードする理由として「工場では性能がコストに等しく、性能が収益に等しい」からだと説明。

電力に限界がある工場の場合、ワットあたりの性能が4倍になれば、そのデータセンターの収益も4倍になる。新世代を導入することで、顧客の収益は増え、コストは下がる。そのため、顧客には「毎年すべてを買うのではなく、毎年なにかを買う」よう伝えている。これにより、古い技術への過剰投資を防ぐ。NVIDIAのアーキテクチャーはすべての工場で互換性があり、ソフトウェアを長期間アップグレードできる利点があると述べた。

ソフトウェアの最適化とモデルの改善は、すべての工場、すべてのコンピューターに恩恵をもたらし、NVIDIAのCUDAは「非常に価値がある」ため、年1回のアップグレードも価値があると述べた。これらを組み合わせることで、データセンターフリート全体の収益が上がり、コストが下がり、寿命が延びる。

最後に、NVIDIA CUDAのインストールベースが非常に高いため、あらゆる新しいイノベーションがCUDA上で動作すること、開発者がまずCUDAで開発するのは性能、技術、そして最大インストールベースの大きさが理由であることを挙げた。これらの理由から、データセンターの寿命は「かなり長くなる」と述べた。

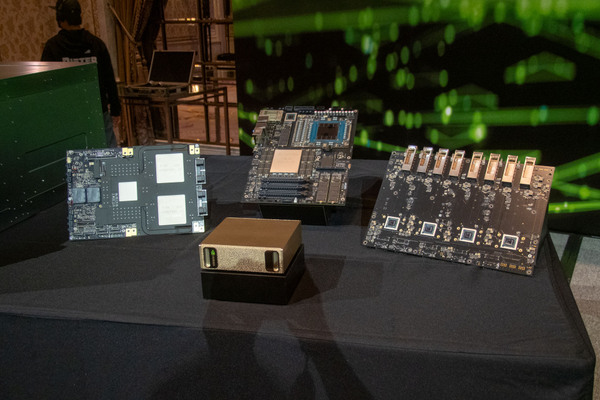

NVLink Fusionの外部提供について、顧客がカスタムチップとNVLink、NVLink Switchを使うようなビジョンは期待できるかという質問にファン氏は、それは「ひとつつのビジョン」だが、より可能性が高いのは、NVLinkチップレット、NVLink Switch、NVLink Spine、Spectrum-X、そして付随ソフトウェアを顧客が購入する形だろうと述べた。

例として富士通を挙げ、彼らは長年CPUシステムを販売しておりAIを追加したいと考えているとし、富士通のCPUと既存のソフトウェアスタックに、NVIDIAのAI技術を組み合わせるには、NVLink Fusionが使用される。NVIDIAがこのシステム(CPUとNVIDIA AIを組み合わせたもの)を富士通に販売し、彼らがNVLinkシステムに接続すれば、富士通のエコシステム全体が「AIスーパーチャージされる」と話す。

ファン氏は、顧客はNVIDIAのエコシステムとソフトウェアを求めているため、融合する意味があるとし、クアルコムのような他のCPUベンダーとも同様に行なうとし、NVLink IPをSynopsysやCadenceに提供したため、あらゆるCPU会社が可能になったと述べた。これにより、NVIDIAのエコシステムが他のエコシステムと融合すると説明した。

ソフトウェア産業の柔軟性について、GPUのような専用ハードウェアの将来性、GPGPUの継続性について質問があった。ファン氏はこれを「良い質問」と評価。流体、粒子物理、有限要素法、グラフィックスなどのアルゴリズムは「消えない」とし、長年洗練され、数兆ドル規模のソフトウェアが既に存在するため「書き直す理由はない」と述べた。

柔軟なソフトウェア、柔軟なハードウェアは「常に価値がある」とし、CPUが60年間成功した理由だと説明した。NVIDIAが開発したCUDAは20年以上の歴史を持ち、深層学習から古典的機械学習、データ処理、物理、化学など非常に多岐にわたる応用領域を持つ。その利点は「柔軟性」だが、遅ければ高価になってしまう。

しかしNVIDIAの技術は「非常に高速」であるとした。高速で柔軟であれば、データセンターは多様な用途に使え、利用率が高くなり、コストが下がる。「汎用性イコール低コストだが、超高性能が必要」であり、これこそがCUDAが成功した理由だと説明。スティーブ・ジョブズがiPhoneを発表した際に、音楽プレーヤー、カメラ、PCといった別々のデバイスが1つの汎用デバイスになった例を挙げ、汎用デバイスは単体では高価でも、すべてを持つよりコストは低いと説明した。

NVIDIAを以前「ソフトウェア会社」と表現したことに関連して、将来NVIDIAを代表する要素(CUDA, Omniverse以外)はなにかと尋ねられた。ファン氏は、NVIDIAは常に「ソフトウェアから始める」、具体的には「アルゴリズム」から始めると説明。アルゴリズムを理解しないとアクセラレーションできないため、常にアルゴリズムから始めて、スタック全体を共同設計する。これはコンパイラ上で動作するCPUとは異なるとした。

NVIDIAは、ソフトウェアによるアルゴリズム加速(フルスタック)から始まり、システム会社、データセンター会社を経て、今は「AIインフラ会社」になっていると述べた。

インフラは重要であり、その上で動作するソフトウェアやシステム構成、最適化はPCとは大きく異なる。これらのAI工場を考える際には、「電力、冷却、ネットワーキング、スケールアップネットワーキング、ファブリック、セキュリティ、ストレージ」すべてを一度に考慮する必要がある。そうでなければ、ソフトウェアやスループットが最適化されず、収益に影響が出ると説明。コンピューターが会社の収益に直接影響を与えるのは「初めて」だと述べた。

ASMLの装置がTSMCの収益に直結するのと似ており、これまでのITデータセンターのコンピューターとは考え方がまったく異なる。AI工場は非常に高価であるため、極限まで最適化する必要があるとした。

NVLink Fusionがさまざまなプロセッサー間の通信を可能にすることについて、AI工場レベルでの意味合い、特に異なるワークロードが適切なチップにどのようにルーティングされるか、という質問にファン氏は、NVIDIAが作成したOSである「Dynamo」と、ネットワーキングAPIである「Nixell」に言及した。

Dynamoは「オーケストレーションシステム」であり、データセンターの異なる部分で処理を実行する。ワークロードを見て賢く判断し、コンテキスト処理、デコード、大規模モデル、小型モデルなど、タスクをデータセンター全体にルーティングできる。H100、H200、GB200、GB300などが混在してもDynamoがオーケストレーションする。特定のタスクに特化したアクセラレータがあれば、Dynamoは見つけてそれを使う。

NVIDIAアーキテクチャーの利点は、すべてが動作することであり、モデルの種類(大規模、小型、汎用、推論、画像、ビデオ、ワールド、ロボティクスなど)に関わらずCUDA上ですべてが動作すると強調した。そして、このデータセンターはすべてNVLink、Spectrum X対応であり、ラックアーキテクチャーも同じだと述べた。

ASICの成長速度と業界の期待についてという質問にファン氏は、NVIDIAがASICよりも速く成長すると予測していると述べた。多くのASICプロジェクトは失敗するか、長期間維持するのが非常に難しいが、NVIDIAのペースは速い。ASICを使う正当化のためには、NVIDIAよりも「かなり」優れている必要があるとし、NVIDIAの競争力、技術進歩の速さ、コスト削減、高い利用率、世界中での普及を挙げた。

AI開発者であればNVIDIAアーキテクチャー上で開発するのが最も理にかなっているとした。GoogleのTPUのようなASICも存在し、GoogleもGemini ProやGeminiをNVIDIA GPU上でも展開していることにも触れ、ASICは存在する理由があるが、それらはNVIDIAと競争しなければならないと述べた。

この連載の記事

-

第53回

スマホ

クアルコムを抜いたMediaTek、6Gや新Chrombookチップ、NVIDIAとの協業をアピール -

第52回

PCパーツ

“美しさ”と“スマートさ”に注目! Phanteksの新しいPCケース/簡易・本格水冷CPUクーラーをCOMPUTEXで見てきた -

第52回

sponsored

エモいPCケースに最新パーツ搭載、SilevrStone「FLP02」でレトロなPCデスク環境を作れる! -

第51回

ケース

かなり難解。ウッドパズルのようなPCケース「Puzzle」 -

第50回

PCパーツ

無茶なことを考えたな! 3基のM.2 SSDを同時冷却できる水冷ユニット -

第49回

sponsored

be quiet!の音がしないキーボード、着脱式テンキーがおもしろい -

第48回

サーバー・ストレージ

水冷コネクターが日本製で結露が起きない! データセンター構築を簡素化するSupermicro「DCBBS」を見てきた! -

第47回

PCパーツ

Noctuaがポンプのないサイフォン式クーラーのデモを公開 -

第46回

PCパーツ

え?聞いてないよ。Noctuaから掟破りの水冷ユニットが発売予定 -

第45回

PCパーツ

XPGの新CPUクーラーは空冷・水冷それぞれの分野で最新技術と使いやすさを両立、液晶付きでビジュアル面も充実 -

第44回

デジタル

MSIってEV充電製品も出してるの? 日本でも展開予定の製品をCOMPUTEXで見てきた - この連載の一覧へ