スマホで試してみよう

最後にスマートフォンアプリ「PocketPal AI」を試してみよう。AndoridはPlayストア、iOSはApp Storeからアプリをダウンロードしよう。なお検証したスマートフォンは「Google Pixel 9 Pro XL(16 GB RAM)」だ。

ダウンロードが終わったらタップして起動しよう。

起動直後の画面、このままでは使えないので右下の「Go to Models」をタップしてモデルをダウンロードしよう。

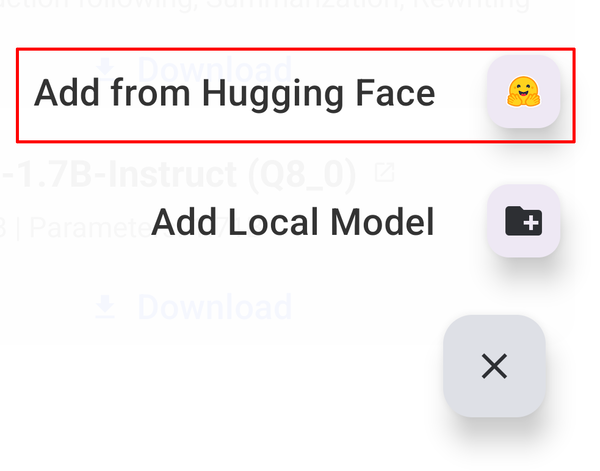

アプリで使えるモデルのリストが表示される。ollamaやLM Studioと違い、DeepSeekのモデルはまだ登録されていなかったため、右下の「+」をタップ、「Add From Hugging Face」をタップしよう。

もちろんここにリストされているモデルを使いたい場合はそのまま「Download」をタップすればよい。

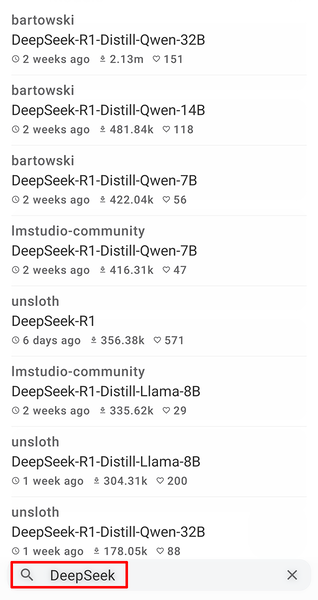

画面下部の検索ウィンドウに「DeepSeek」と入力して検索。

いつもの「DeepSeek-R1-Distill-Llama-8B」をタップ。

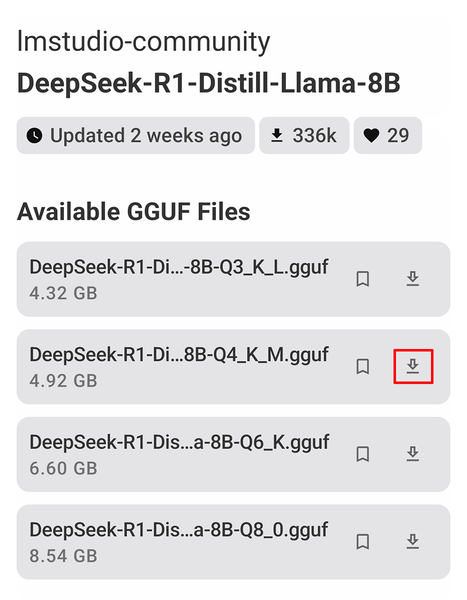

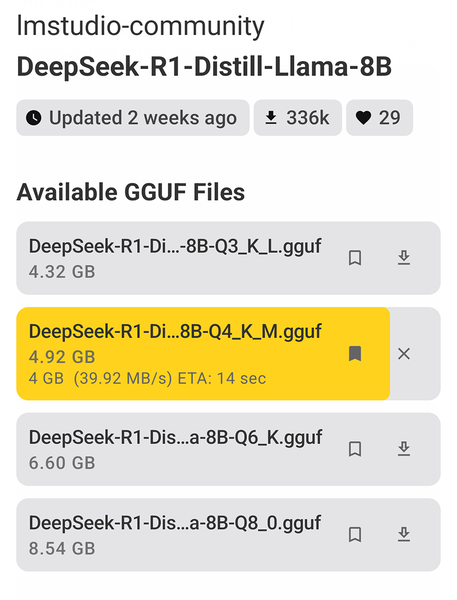

このモデルには4つの量子化モデルが用意されている。量子化とは先述の通りモデルの精度をある程度犠牲にする代わりに、サイズを小さくする技術だ。

これまでのollamaやLM Studioでは自動的に4ビット(Q4)モデルが選択されていたが、PocketPal AIではまだDeepSeekがデフォルトモデルとして登録されていないため、Hugging Faceから直接ダウンロードすることになる。

ファイル名に含まれる「Q3」「Q4」「Q6」「Q8」は、それぞれ3ビット、4ビット、6ビット、8ビットでの量子化を表している。3ビット(Q3)モデルは4.32GB、8ビット(Q8)モデルは8.54GBと、ビット数が小さいほどファイルサイズは小さくなるが、その分精度は低下する。

ここではollamaやLM Studioと同じようにQ4モデルを選択し、「↓」をタップしてダウンロードしよう。

ダウンロードが開始される。4GBを超えるデータなのでWi-Fi環境を利用したほうがいいだろう。

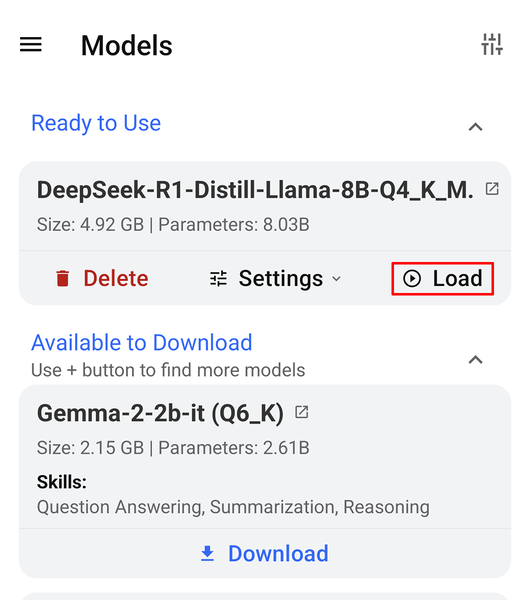

ダウンロードが終了したら表示される「Load」をタップ。

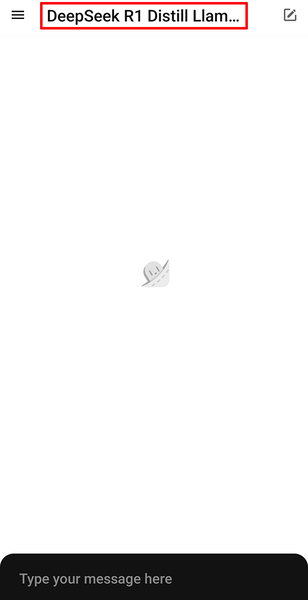

画面上部のモデル表示欄に「DeepSeek-R1-Distill-Llama-8B」と表示されれば準備OKだ。

スマホでも会話できるかな?

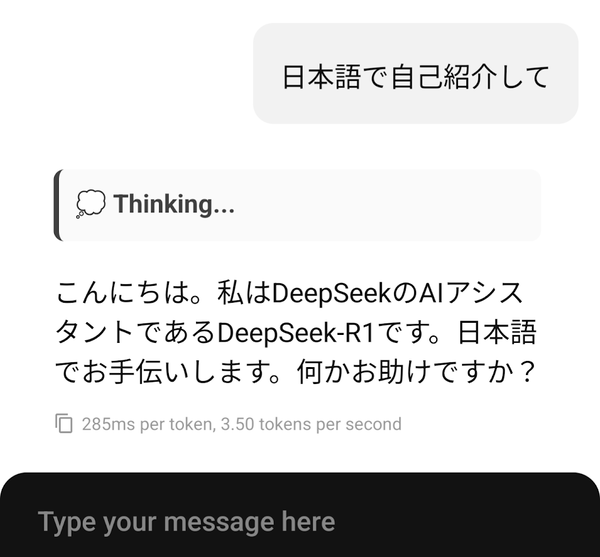

では、いよいよ実験だ。画面下部の入力欄にプロンプトを入力して「紙飛行機」アイコンをタップ。

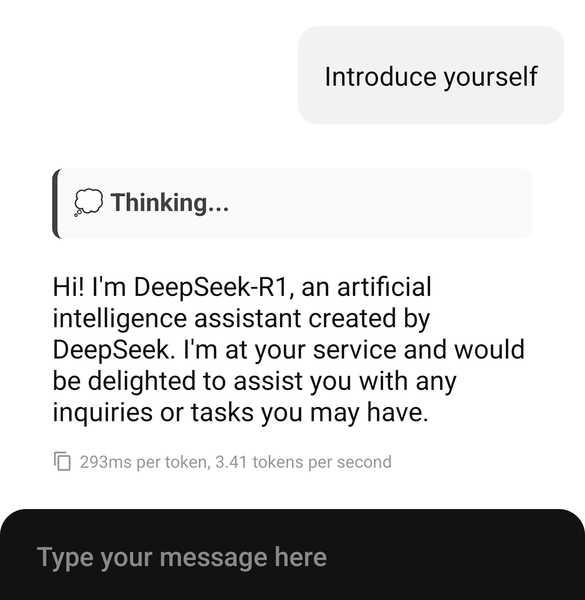

プロンプト:Introduce yourself

これだけ生成するのに10秒以上時間はかかるが、無事ローカルでも動作することがわかった。

これまでと同じモデルなので日本語性能も同程度かと思われる。ただし、このモデルをベースに日本語対応を強化したファインチューニングモデルも続々と登場しているので、試してみるのもいいだろう。

この連載の記事

-

第45回

AI

面白すぎて危険すぎ! PCを“勝手に動かす”AI、OpenClaw(旧Moltbot/Clawdbot)とは -

第44回

AI

「こんなもの欲しいな」が、わずか数時間で形になる。AIツール「Google Antigravity」が消した“実装”という高い壁 -

第43回

AI

ChatGPT最新「GPT-5.2」の進化点に、“コードレッド”発令の理由が見える -

第42回

AI

ChatGPT、Gemini、Claude、Grokの違いを徹底解説!仕事で役立つ最強の“AI使い分け術”【2025年12月最新版】 -

第41回

AI

中国の“オープンAI”攻撃でゆらぐ常識 1兆パラ級を超格安で開発した「Kimi K2」 の衝撃 -

第40回

AI

無料でここまでできる! AIブラウザー「ChatGPT Atlas」の使い方 -

第39回

AI

xAI「Grok」無料プラン徹底ガイド スマホ&PCの使い方まとめ -

第38回

AI

【無料】「NotebookLM」神機能“音声概要”をスマホで使おう! 難しい論文も長〜いYouTubeも、ポッドキャスト化して分かりやすく -

第37回

AI

OpenAIのローカルAIを無料で試す RTX 4070マシンは普通に動いたが、M1 Macは厳しかった… -

第36回

AI

無料で「Gemini 2.5 Pro」が使える!グーグル「Gemini CLI」の使い方を簡単解説 -

第35回

AI

【無料】グーグル神AIツール5選 「Google AI Studio」はこれがやばい - この連載の一覧へ