ロードマップでわかる!当世プロセッサー事情 第644回

業界初のマルチダイGPUとなるRadeon Instinct MI200の見事な構成 AMD GPUロードマップ

2021年12月06日 12時00分更新

連載635回でFrontierに納入される予定のRadeon Instinctの構成をいろいろ説明したが、“AMD Accelerated Data Center Premiere”では当然こちらの説明もあったので、答え合わせも兼ねてご紹介したい。

ちなみに発表記事で簡単にRadeon Instinct MI200シリーズの概要が紹介されているが、細かい製品仕様の話は最後にする。

1つのパッケージに2つのダイを搭載した見事な構成の

Radeon Instinct MI200シリーズ

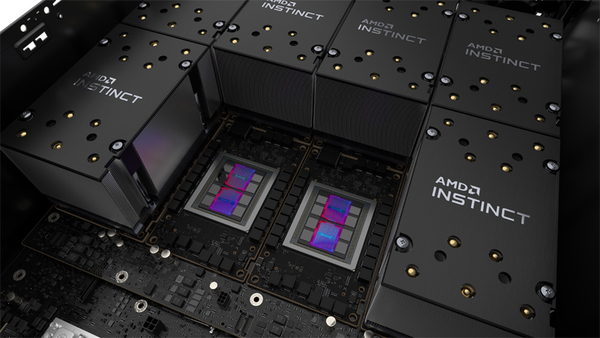

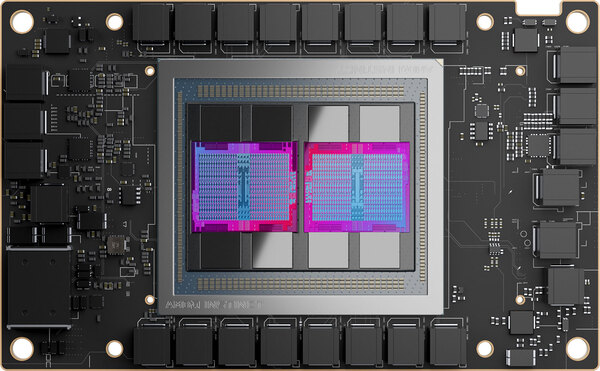

連載635回のノード構成推定図で「1つのRadeon Instinctと描いたものが、2つのRadeon Instinctを搭載したモジュールだと仮定すると、このギャップはもう少し縮まる」と書いたが、実際に発表されたRadeon Instinct MI200シリーズは見事に、1つのパッケージに2つのダイを搭載した構成となった。

フォームファクターはOAM(OCP Accelerator Module)準拠。OCP(Open Compute Project)はFacebook(現Meta)が主導する、標準的なサーバー向け仕様を策定するプログラムで、多くのメーカーがこれに参画しており、NVIDIAのA100もこのOAM仕様のものがメインである

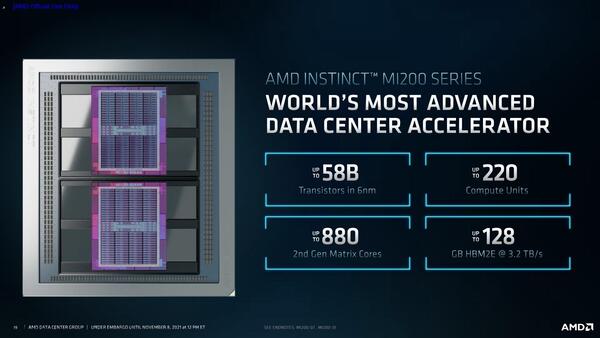

そのRadeon Instinct MI200シリーズの構成が下の画像だ。HBMはダイあたり4スタック、XCUはダイあたり110なので、実はRadeon Instinct MI100と比較すると、微妙にXCUの数が減っている計算になる。

HBM2eの寸法(9.975×10.975mm)から推定されるダイサイズは25.1×29.3mmで735.4mm2ほど。Radeon Instinct MI100の推定ダイサイズ(763.2mm2)とほぼ変わらない

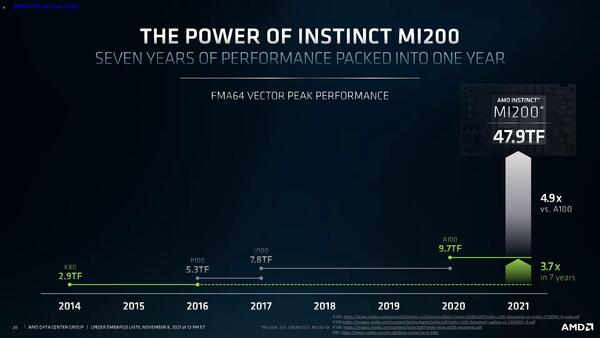

それにもかかわらず、FP64のベクトル演算性能が4倍ほどに引き上げられている。ダイ1つあたりの性能で言っても軽く倍である。

こちらはNVIDIAの製品との性能比較になっているが、Radeon Instinct MI100の性能はFP64で11.5TFlops、FP32で23.1TFlopsとされている

もう少し細かい数字が下の画像であるが、FP64のベクトル演算で47.9TFlops、FP64のマトリックス演算で95.7TFlopsというすさまじい数字を叩き出している。

rennsai635回でFrontierのノード(EPYC×1+Radeon Instinct×4)の性能を49TFlops程度と推定したが、実際にはMilan-Xを無視してRadeon Instinct×4だけでも191.6TFlopsに達しており、スペック表の数字が正しければ9000ノードにおけるピークで1.72EFlopsに達する。1.5EFlops以上、というFrontierの目標数値はわりと堅く実現できる格好だ。

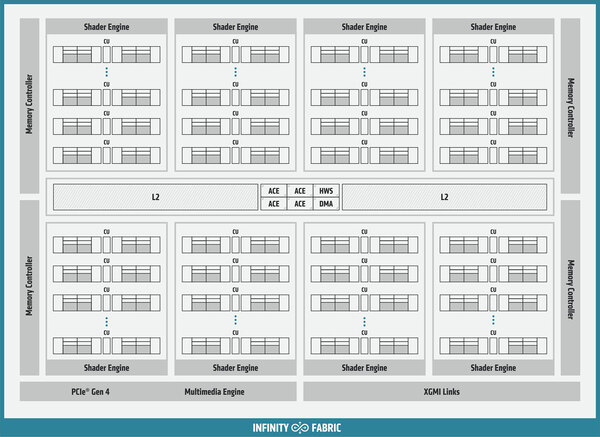

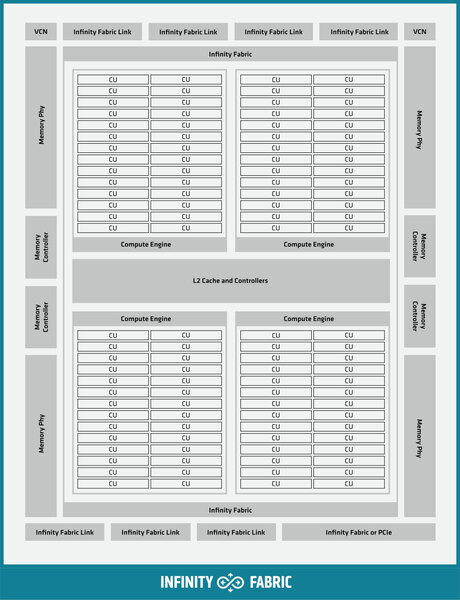

ではなぜこれが可能になったのか? という話であるが、MI100とMI200のダイの基本構成を比較するとわかる。

まずCU(CNDAからはXCUという呼び方に変わったが)の数そのもので言えば、MI100が16×8=128XCUで、うち8つを無効化して120XCU構成としている。一方MI200は14×8=112XCUで、うち2つを無効化して110XCUとしている格好だ。

細かいところでは、ACEがなくなったというか、これまではACEが任意のShader Computeに対してスレッドを割り振って処理する格好だったのが、どうもMI200ではACEが直接CUに対してスレッドを割り振るような格好で処理をすることになったようだ。このあたりの得失など、そのうちなにかしら話が出てくることを期待したい。

またHWS(HardWare Scheduler)のブロックもなくなっているが、これはCompute Engineにその機能が搭載されたのか、それとも全部ソフトウェアでスケジュールするようにしたのかも現時点でははっきりしない。

MI200の基本構成を見ると、一番上の左右にVCN(Video Codec Next)が搭載されているが、これはMI100にはなかった機能だ。このVCNではH.264/AVC、HEVC、VP9、JPEGのデコードと、H.264/AVC、HEVCのエンコードが可能とされている。

2次キャッシュのサイズそのものはMI100/MI200ともに8MBであり、16wayセットアソシエイティブ方式なのも同じであるが、MI100が64Bytes/サイクルなのに対し、MI200は128Bytes/サイクルと帯域が倍増されている。

メモリーI/Fが4組なのは同じだが、MI100はHBM2なので2.4GT/s、一方MI200はHBM2eで3.2TB/sとなっている。さらに、MI100にはXGMI Linksというポートが右下にあるが、これはInfinity Fabricのリンクのことだ。XGMIは“Socket/Inter-Chip Global Memory Interconnect”で、パッケージ同士の接続に利用されるものだが、MI100では最大4枚までのカードをRing Busの構成で接続できた。

一方MI200では後述するように、複数のダイ/パッケージ同士をPoint-to-Pointの形でInfinity Fabricで接続するため、MI200では外部向けに7ポートのInfinity Fabricと、1本のInfinity Fabric/PCIeポートが用意される格好になっている。

この連載の記事

-

第864回

PC

なぜAMDはチップレットで勝利したのか? 2万ドルのウェハーから逆算する経済的合理性 -

第863回

PC

銅配線はなぜ限界なのか? ルテニウムへの移行で変わる半導体製造の常識と課題 -

第862回

PC

「ビル100階建て相当」の超難工事! DRAM微細化が限界を超え前人未到の垂直化へ突入 -

第861回

PC

INT4量子化+高度な電圧管理で消費電力60%削減かつ90%性能アップ! Snapdragon X2 Eliteの最先端技術を解説 -

第860回

PC

NVIDIAのVeraとRubinはPCIe Gen6対応、176スレッドの新アーキテクチャー搭載! 最高クラスの性能でAI開発を革新 -

第859回

デジタル

組み込み向けのAMD Ryzen AI Embedded P100シリーズはZen 5を最大6コア搭載で、最大50TOPSのNPU性能を実現 -

第858回

デジタル

CES 2026で実機を披露! AMDが発表した最先端AIラックHeliosの最新仕様を独自解説 -

第857回

PC

FinFETを超えるGAA構造の威力! Samsung推進のMBCFETが実現する高性能チップの未来 -

第856回

PC

Rubin Ultra搭載Kyber Rackが放つ100PFlops級ハイスペック性能と3600GB/s超NVLink接続の秘密を解析 -

第855回

PC

配線太さがジュース缶並み!? 800V DC供給で電力損失7~10%削減を可能にする次世代データセンターラック技術 -

第854回

PC

巨大ラジエーターで熱管理! NVIDIA GB200/300搭載NVL72ラックがもたらす次世代AIインフラの全貌 - この連載の一覧へ