バーチャルYouTuber(VTuber)などに見られるアバターを使って、自由に自分を表現したいという技術は、VRMフォーマットを使った3Dアバターであったり、Live2Dを使った2Dデータの組み合わせで表現されるのが一般的です。しかし、それぞれの技術はデータ作成が複雑でした。いま、そこにAI技術を組み合わせることで、もっと簡単に実現できないかという新しい方法が、Xを中心とした日本人のコミュニティから、登場してきています。

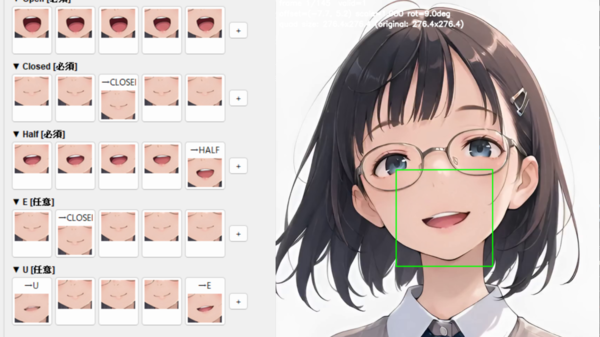

ループ動画に合わせて目と口を動かす

ろてじんさん(@rotejin)が制作している「MotionPNG Tuber」は、AI動画に合わせて目と口を動かすようにすることで、VTuberのような仕組みにしようという画期的な方法論です。AI動画向けに音声のリップシンクを実現する動画環境はクラウドサービスやローカル環境など複数登場していますが、まだリアルタイムに動かすことができません。VTuberのようにリアルタイムに話したことを、そのまま応答することはできないのです。

しかし、動画に音声に合わせた口パクをリアルタイムに重ね合わせることが実現できれば、簡易的なVTuberのような仕組みが作れるのでは、というのが着目点です。

実際に、作り方に従って筆者が作成したのが、以下の動画です。話している音声に合わせて口が動いています。

△MotionPNG Tuberの筆者の作例

ろてじんさんは当初、PNG形式の画像データ4枚だけを使って実現するPNG Tuberを試されていました。「開いた目と開いた口」、「閉じている目と閉じている口」などの組み合わせ4枚を使い、音声に合わせて口パクをさせる仕組みです。

リアルタイムPNGTuberは画像を全てpngに書き出し直し。腕の差分を3枚だけ作って、3~5秒毎にランダムに切り替えてみた。少しポーズが変わるだけでリッチさアップね。 https://t.co/TSDFRqhW7Gpic.twitter.com/bsWZcKqo93

— ろてじん (@rotejin) December 17, 2025

△ろてじんさんのX投稿より

音声に合わせて用意した画像を切り替えるだけでいいので、手軽に作れることもあり、様々な人が挑戦してきています。筆者も、Google AI StudioのBuildで簡易的な環境「PNG TUBE Studio」というアプリを作ってみました。4枚の差分画像があれば、音声に合わせて口パク、適宜の目パチをしてくれるというものです。

△PNG TUBE Studioで動かしている状態

この連載の記事

-

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る -

第135回

AI

実在感が恐ろしいレベル 画像生成AIの常識をひっくり返した「Nano Banana Pro」 -

第134回

AI

“AI読者”が小説執筆の支えに 感想を励みに30話まで完成 - この連載の一覧へ